Auto Scaling là khả năng tự động điều chỉnh số lượng tài nguyên điện toán (như máy chủ ảo, container) để đáp ứng nhu cầu lưu lượng truy cập thay đổi, giúp tối ưu hiệu năng và chi phí. Công nghệ này hoạt động dựa trên các chỉ số hiệu suất hoặc lịch trình được định sẵn.

Bạn đã bao giờ trải qua tình trạng website hoặc ứng dụng của mình chạy chậm như rùa, thậm chí “sập” hẳn vào những giờ cao điểm hay trong các chiến dịch khuyến mãi lớn chưa? Ngược lại, vào những lúc vắng khách, bạn có cảm thấy đang lãng phí tài nguyên và tiền bạc cho những máy chủ hoạt động không hết công suất?

Những vấn đề này thực sự là nỗi đau đầu của nhiều nhà quản trị hệ thống và chủ doanh nghiệp. Việc dự đoán chính xác nhu cầu và điều chỉnh hạ tầng thủ công vừa tốn thời gian, công sức lại tiềm ẩn nhiều rủi ro. May mắn thay, công nghệ điện toán đám mây (Cloud Computing) đã mang đến một giải pháp mạnh mẽ: Auto Scaling.

Bài viết này sẽ đi sâu giải thích Auto Scaling là gì, tại sao nó lại quan trọng đến vậy, cách thức hoạt động ra sao, khi nào bạn nên ứng dụng nó và những khái niệm liên quan cần biết. Hãy cùng khám phá cách Auto Scaling giúp bạn xây dựng hạ tầng linh hoạt, hiệu quả và đáng tin cậy hơn nhé!

Auto Scaling là gì?

Hãy tưởng tượng bạn là chủ một cửa hàng. Vào ngày thường, chỉ cần 2 quầy thu ngân là đủ. Nhưng cuối tuần hoặc dịp lễ, khách đông gấp bội, bạn cần nhanh chóng mở thêm 3-4 quầy nữa để tránh ùn tắc. Khi khách vắng, bạn lại đóng bớt quầy để tiết kiệm chi phí nhân viên. Auto Scaling hoạt động tương tự như vậy với hạ tầng công nghệ của bạn.

Nói một cách kỹ thuật hơn, Auto Scaling là một tính năng trong điện toán đám mây cho phép hệ thống tự động tăng (Scale Out/Up) hoặc giảm (Scale In/Down) số lượng tài nguyên tính toán. Các tài nguyên này có thể là máy chủ ảo (Virtual Machines – VMs), instances (phiên bản), containers, hoặc các hàm serverless.

Việc điều chỉnh này không diễn ra ngẫu nhiên. Nó được thực hiện dựa trên các chính sách co giãn (Scaling Policies) mà bạn định nghĩa trước. Các chính sách này thường căn cứ vào các chỉ số hiệu năng (Metrics) được giám sát liên tục hoặc dựa trên một lịch trình (Schedule) cụ thể.

Mục tiêu cốt lõi của Auto Scaling là đảm bảo ứng dụng của bạn luôn có đủ tài nguyên cần thiết để đáp ứng chính xác nhu cầu tải (Load) tại mọi thời điểm. Nhờ đó, hệ thống có thể duy trì hiệu năng ổn định (Stable Performance), cung cấp tính sẵn sàng cao (High Availability) và quan trọng là tối ưu hóa chi phí (Cost Optimization) hiệu quả.

Tại sao Auto Scaling lại quan trọng?

Việc ứng dụng Auto Scaling không chỉ là một xu hướng công nghệ mà còn mang lại những lợi ích vô cùng thiết thực cho hoạt động của hệ thống và kinh doanh. Nó giải quyết trực tiếp nhiều thách thức cố hữu của việc quản lý hạ tầng theo phương pháp truyền thống, giúp bạn vận hành hiệu quả hơn.

1. Đảm bảo tính sẵn sàng và độ tin cậy cao

Tính sẵn sàng cao (High Availability – HA) có nghĩa là ứng dụng hoặc dịch vụ của bạn luôn hoạt động và người dùng có thể truy cập được gần như mọi lúc. Auto Scaling đóng góp trực tiếp vào việc này bằng cách đảm bảo luôn có đủ tài nguyên khỏe mạnh để phục vụ yêu cầu.

Một trong những khả năng quan trọng là tự động thay thế các instance (máy chủ ảo) gặp sự cố. Nếu một instance không vượt qua được kiểm tra sức khỏe (health check) do lỗi phần cứng hoặc phần mềm, Auto Scaling sẽ tự động chấm dứt instance đó và khởi chạy một instance mới thay thế, giảm thiểu thời gian chết.

Bên cạnh đó, khi lưu lượng truy cập tăng đột biến, Auto Scaling sẽ nhanh chóng bổ sung tài nguyên. Điều này ngăn chặn tình trạng quá tải, giúp ứng dụng không bị chậm hoặc ngừng phản hồi. Ví dụ, một trang tin tức có thể tự động tăng gấp đôi số lượng máy chủ khi có sự kiện nóng thu hút lượng lớn độc giả.

Việc duy trì hoạt động liên tục này không chỉ nâng cao trải nghiệm người dùng mà còn xây dựng niềm tin vào thương hiệu của bạn. Đối với các hệ thống quan trọng, tính sẵn sàng cao là yếu tố then chốt đảm bảo hoạt động kinh doanh không bị gián đoạn.

2. Tối ưu hóa chi phí sử dụng hạ tầng

Một trong những lợi ích hấp dẫn nhất của Auto Scaling chính là khả năng tối ưu chi phí (Cost Optimization). Trong mô hình điện toán đám mây, bạn thường trả tiền theo dung lượng sử dụng (pay-as-you-go). Auto Scaling giúp bạn tận dụng tối đa lợi thế này.

Cơ chế hoạt động rất đơn giản: khi nhu cầu tải thấp, Auto Scaling sẽ tự động giảm bớt số lượng tài nguyên đang chạy không cần thiết (Scale In). Bạn sẽ không phải trả tiền cho những máy chủ ảo “ngồi chơi” vào ban đêm hay những ngày cuối tuần vắng vẻ.

Hãy so sánh với việc cấp phát tài nguyên cố định theo cách truyền thống. Bạn thường phải tính toán và duy trì đủ máy chủ để đáp ứng mức tải cao nhất dự kiến. Điều này dẫn đến lãng phí đáng kể trong phần lớn thời gian khi tải không đạt đỉnh.

Ví dụ, một website thương mại điện tử có thể chỉ cần 5 máy chủ vào ngày thường nhưng cần đến 50 máy chủ trong đợt Black Friday. Với Auto Scaling, họ chỉ trả tiền cho 50 máy chủ trong vài ngày cao điểm, thay vì phải duy trì 50 máy chủ suốt cả năm. Điều này giúp tiết kiệm chi phí hạ tầng một cách đáng kể.

3. Cải thiện hiệu năng và trải nghiệm người dùng

Hiệu năng (Performance) của ứng dụng, đặc biệt là tốc độ phản hồi, ảnh hưởng trực tiếp đến trải nghiệm người dùng (User Experience – UX). Không ai thích chờ đợi một trang web tải chậm hay một ứng dụng phản hồi ì ạch. Auto Scaling giúp giải quyết vấn đề này hiệu quả.

Khi lưu lượng truy cập tăng lên, mỗi máy chủ phải xử lý nhiều yêu cầu hơn, dẫn đến thời gian phản hồi chậm lại. Auto Scaling sẽ phát hiện tình trạng này (thông qua các metrics như CPU Utilization, Request Latency) và tự động bổ sung thêm máy chủ (Scale Out).

Việc bổ sung tài nguyên kịp thời giúp san sẻ tải, đảm bảo mỗi máy chủ hoạt động trong ngưỡng tối ưu. Nhờ đó, ứng dụng của bạn luôn duy trì được tốc độ phản hồi nhanh chóng và ổn định, ngay cả trong những giờ cao điểm nhất.

Một trải nghiệm người dùng mượt mà, nhanh chóng sẽ giữ chân khách hàng, tăng tỷ lệ chuyển đổi và nâng cao uy tín cho dịch vụ của bạn. Auto Scaling chính là chìa khóa để đảm bảo hiệu năng hệ thống luôn song hành cùng sự tăng trưởng của người dùng.

4. Tăng cường tính linh hoạt và khả năng mở rộng

Trong môi trường kinh doanh đầy biến động ngày nay, khả năng thích ứng nhanh chóng là yếu tố sống còn. Tính linh hoạt (Elasticity) và khả năng mở rộng (Scalability) mà Auto Scaling mang lại chính là lợi thế cạnh tranh quan trọng.

Elasticity là khả năng tự động tăng hoặc giảm tài nguyên để phù hợp với nhu cầu thay đổi đột ngột, thường là trong ngắn hạn. Ví dụ, một ứng dụng xem video trực tuyến cần scale out mạnh mẽ khi có trận bóng đá hấp dẫn và scale in ngay sau khi trận đấu kết thúc.

Scalability là khả năng của hệ thống có thể xử lý khối lượng công việc ngày càng tăng mà vẫn đảm bảo hiệu năng. Auto Scaling giúp bạn dễ dàng mở rộng quy mô hạ tầng khi doanh nghiệp phát triển, lượng người dùng tăng lên mà không cần phải đầu tư lớn hay cấu hình lại phức tạp.

Nhờ Auto Scaling, hạ tầng của bạn không còn là một khối cố định, cứng nhắc mà trở nên “co giãn” linh hoạt. Doanh nghiệp có thể tự tin đối mặt với những biến động về nhu cầu, nắm bắt các cơ hội tăng trưởng mà không bị giới hạn bởi năng lực hạ tầng.

5. Tự động hóa quản lý hạ tầng

Quản lý hạ tầng theo phương pháp thủ công đòi hỏi nhiều công sức giám sát, phân tích và điều chỉnh. Các quản trị viên hệ thống (System Administrators) phải liên tục theo dõi tải, dự đoán nhu cầu và thực hiện thêm/bớt máy chủ. Công việc này không chỉ tốn thời gian mà còn dễ xảy ra sai sót.

Auto Scaling giúp tự động hóa (Automation) phần lớn quy trình này. Một khi bạn đã thiết lập các chính sách co giãn phù hợp, hệ thống sẽ tự động vận hành mà không cần hoặc cần rất ít sự can thiệp của con người. Điều này giải phóng thời gian cho đội ngũ IT tập trung vào các nhiệm vụ chiến lược hơn.

Việc tự động hóa cũng giúp giảm thiểu rủi ro do lỗi con người (human error) trong quá trình điều chỉnh hạ tầng. Các quyết định scale được thực hiện dựa trên dữ liệu và quy tắc rõ ràng, đảm bảo tính nhất quán và kịp thời. Đây là một phần quan trọng trong thực hành DevOps, giúp tăng tốc độ triển khai và độ tin cậy của hệ thống.

Cơ chế hoạt động của Auto Scaling

Hiểu rõ cách Auto Scaling hoạt động sẽ giúp bạn cấu hình và sử dụng nó hiệu quả hơn. Về cơ bản, quá trình này bao gồm việc giám sát, ra quyết định dựa trên chính sách và thực hiện hành động điều chỉnh tài nguyên. Hãy cùng tìm hiểu các thành phần và luồng hoạt động chính.

1. Các thành phần chính của hệ thống Auto Scaling

Một hệ thống Auto Scaling điển hình thường bao gồm các thành phần cốt lõi sau:

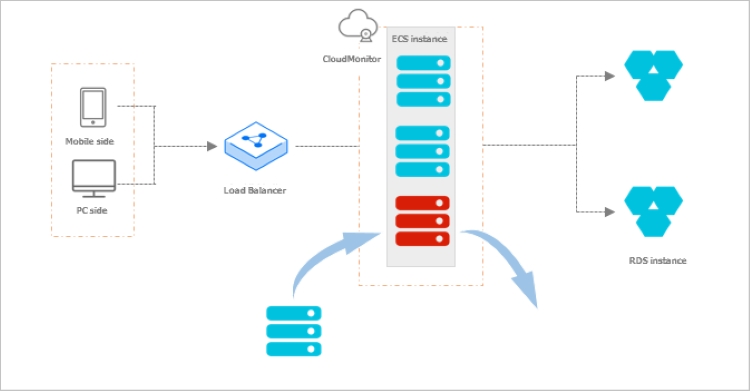

- Nhóm tài nguyên có thể co giãn (Scalable Resource Group): Đây là tập hợp các tài nguyên giống hệt nhau mà Auto Scaling sẽ quản lý. Ví dụ: một nhóm các máy chủ ảo EC2 trong Auto Scaling Group (ASG) của Amazon Web Services (AWS), một VM Scale Set (VMSS) trong Microsoft Azure, hoặc một Managed Instance Group (MIG) trong Google Cloud Platform (GCP). Trong Kubernetes, đây có thể là một nhóm các Pod được quản lý bởi một Deployment hoặc ReplicaSet.

- Cấu hình khởi chạy (Launch Configuration / Template): Đây là bản thiết kế chi tiết định nghĩa cách tạo ra một tài nguyên mới khi cần Scale Out. Nó bao gồm thông tin như loại máy ảo (instance type), image hệ điều hành (AMI/OS Image), cấu hình mạng, user data (script khởi chạy), và các thiết lập khác. Đảm bảo mọi instance mới đều giống hệt nhau.

- Chính sách co giãn (Scaling Policy): Đây là bộ quy tắc quyết định KHI NÀO và LÀM THẾ NÀO để thực hiện hành động co giãn. Có nhiều loại chính sách khác nhau (sẽ tìm hiểu ở phần sau), nhưng chúng thường dựa trên việc theo dõi các chỉ số hoặc dựa vào lịch trình định sẵn. Ví dụ: “Nếu CPU trung bình của nhóm vượt quá 70% trong 5 phút, hãy thêm 2 instance mới”.

- Giám sát (Monitoring): Để các chính sách hoạt động, hệ thống cần liên tục theo dõi trạng thái và hiệu năng của nhóm tài nguyên. Các dịch vụ giám sát đám mây như AWS CloudWatch, Azure Monitor, Google Cloud Monitoring thu thập các chỉ số (Metrics) quan trọng. Các metrics phổ biến bao gồm: Mức sử dụng CPU (CPU Utilization), Mức sử dụng bộ nhớ (Memory Usage), Lưu lượng mạng (Network I/O), Độ dài hàng đợi yêu cầu (Request Queue Length), độ trễ phản hồi…

- Hành động co giãn (Scaling Actions): Dựa trên quyết định của Scaling Policy, hệ thống sẽ thực hiện các hành động cụ thể:

- Scale Out: Thêm các instance/VM/container mới vào nhóm.

- Scale In: Xóa bớt các instance/VM/container khỏi nhóm.

- Scale Up: (Ít phổ biến hơn trong Auto Scaling tự động) Tăng cấu hình (CPU, RAM) của các instance hiện có.

- Scale Down: (Ít phổ biến hơn) Giảm cấu hình của các instance hiện có.

2. Luồng hoạt động cơ bản

Để dễ hình dung, hãy xem xét một luồng hoạt động Scale Out đơn giản của một ứng dụng web chạy trên AWS sử dụng ASG:

- Giám sát: Dịch vụ AWS CloudWatch liên tục theo dõi chỉ số “CPU Utilization” (Mức sử dụng CPU trung bình) của tất cả các instance trong ASG. Giả sử, chỉ số này được thu thập mỗi phút.

- Đánh giá Chính sách: Một Scaling Policy được cấu hình: “Nếu CPU Utilization trung bình lớn hơn 70% trong khoảng thời gian 5 phút liên tục, hãy thực hiện hành động Scale Out”.

- Kích hoạt Hành động: Vào giờ cao điểm, lưu lượng truy cập tăng mạnh. CPU Utilization trung bình của nhóm vượt ngưỡng 70% và duy trì trên mức đó trong 5 phút. CloudWatch gửi cảnh báo (Alarm) đến ASG.

- Thực hiện Scale Out: ASG nhận tín hiệu và tự động thực hiện hành động Scale Out. Nó sử dụng Launch Template đã cấu hình để khởi chạy một (hoặc nhiều, tùy chính sách) instance EC2 mới.

- Khởi tạo & Đăng ký: Instance mới khởi động, cài đặt ứng dụng (nếu cần thông qua user data). Sau khi vượt qua kiểm tra sức khỏe (health check) của ASG và (nếu có) của Elastic Load Balancer (ELB), instance này sẽ được đưa vào nhóm và bắt đầu nhận một phần lưu lượng truy cập từ ELB.

- Ổn định: Với instance mới, tải được san sẻ, CPU Utilization trung bình của nhóm giảm xuống dưới ngưỡng 70%. Hệ thống trở lại trạng thái ổn định với nhiều tài nguyên hơn.

Quá trình Scale In (giảm số lượng instance khi tải thấp) cũng diễn ra tương tự nhưng theo chiều ngược lại, dựa trên một chính sách khác (ví dụ: CPU Utilization < 30%).

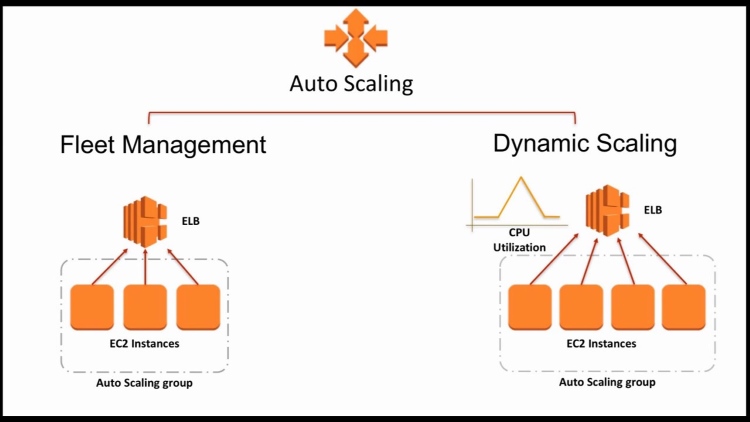

Các loại Auto Scaling phổ biến

Không phải tất cả Auto Scaling đều giống nhau. Tùy thuộc vào cách thức kích hoạt và cơ chế ra quyết định, có thể phân loại thành một số loại chính. Hiểu rõ các loại này giúp bạn chọn phương pháp phù hợp nhất với đặc thù ứng dụng và mô hình lưu lượng truy cập của mình.

1. Reactive Scaling (Co giãn phản ứng / Dynamic Scaling)

Đây là loại Auto Scaling phổ biến và được sử dụng rộng rãi nhất. Reactive Scaling hoạt động dựa trên việc theo dõi các chỉ số hiệu năng (metrics) trong thời gian thực. Khi một chỉ số vượt qua hoặc xuống dưới một ngưỡng (threshold) đã định trước, hành động scale sẽ được kích hoạt.

Ví dụ kinh điển là scale dựa trên CPU Utilization. Khi CPU trung bình của nhóm máy chủ vượt 70%, hệ thống sẽ thêm máy chủ mới. Khi CPU xuống dưới 30%, hệ thống sẽ loại bỏ bớt máy chủ. Các metrics khác như lưu lượng mạng, số lượng yêu cầu mỗi giây, độ dài hàng đợi cũng thường được sử dụng.

Ưu điểm lớn nhất của Reactive Scaling là nó phản ứng trực tiếp với tình hình tải thực tế của ứng dụng. Tuy nhiên, nó có một nhược điểm là luôn có độ trễ nhất định. Hệ thống cần thời gian để phát hiện sự thay đổi metric, kích hoạt hành động, và quan trọng nhất là thời gian để instance mới khởi động và sẵn sàng phục vụ (boot time). Độ trễ này có thể gây ảnh hưởng tạm thời đến hiệu năng nếu tải tăng quá nhanh.

2. Scheduled Scaling (Co giãn theo lịch trình)

Scheduled Scaling cho phép bạn định cấu hình các hành động scale diễn ra vào những thời điểm cụ thể trong tương lai. Thay vì phản ứng với metrics, nó hoạt động dựa trên một lịch trình (schedule) bạn đã biết trước.

Ví dụ, bạn biết rằng ứng dụng của mình luôn có lượng truy cập cao nhất vào khoảng 8 giờ sáng đến 5 giờ chiều các ngày trong tuần. Bạn có thể cấu hình Scheduled Scaling để tự động tăng số lượng instance lên mức mong muốn vào 7:45 sáng và giảm xuống vào 5:15 chiều mỗi ngày làm việc.

Ưu điểm của Scheduled Scaling là tính chủ động và không có độ trễ phản ứng. Tài nguyên đã sẵn sàng trước khi nhu cầu tăng cao. Nó rất hữu ích cho các mô hình tải có tính chu kỳ rõ ràng và dễ dự đoán. Tuy nhiên, nhược điểm là nó kém linh hoạt với những thay đổi bất ngờ không nằm trong lịch trình. Nếu có một sự kiện đột xuất làm tăng tải vào buổi tối, Scheduled Scaling sẽ không tự phản ứng được (trừ khi kết hợp với Reactive Scaling).

3. Predictive Scaling (Co giãn dự đoán)

Đây là một phương pháp tiên tiến hơn, thường sử dụng Machine Learning (ML) để phân tích dữ liệu lịch sử về tải và các metrics. Predictive Scaling cố gắng dự đoán nhu cầu tải trong tương lai gần và chủ động điều chỉnh tài nguyên trước khi nhu cầu thực sự xảy ra.

Ví dụ, AWS cung cấp tính năng Predictive Scaling Policies. Nó phân tích dữ liệu CloudWatch trong quá khứ (thường là vài tuần) để tìm ra các mẫu tải lặp lại (hàng giờ, hàng ngày, hàng tuần) và tạo ra dự báo cho 24-48 giờ tới. Dựa trên dự báo này, nó sẽ lên lịch các hành động scale phù hợp.

Ưu điểm lớn của Predictive Scaling là nó kết hợp tính chủ động của Scheduled Scaling và khả năng xử lý các mẫu tải phức tạp, giúp khắc phục độ trễ của Reactive Scaling. Nó đặc biệt hiệu quả cho các ứng dụng có mô hình tải biến động nhưng vẫn có tính quy luật nhất định. Nhược điểm là nó phức tạp hơn trong cấu hình và yêu cầu phải có đủ dữ liệu lịch sử để mô hình ML hoạt động chính xác.

4. (Tùy chọn) Phân biệt Horizontal Scaling vs Vertical Scaling

Mặc dù không phải là “loại” Auto Scaling theo cơ chế kích hoạt, việc phân biệt giữa Horizontal Scaling (Mở rộng ngang) và Vertical Scaling (Mở rộng dọc) là rất quan trọng khi nói về co giãn.

- Horizontal Scaling (Scale Out / Scale In): Đây là phương pháp chính mà hầu hết các hệ thống Auto Scaling tự động thực hiện. Nó liên quan đến việc thêm (Scale Out) hoặc bớt (Scale In) số lượng máy chủ/instance/container trong nhóm tài nguyên. Ưu điểm là khả năng mở rộng gần như không giới hạn và tăng khả năng chịu lỗi.

- Vertical Scaling (Scale Up / Scale Down): Phương pháp này liên quan đến việc tăng (Scale Up) hoặc giảm (Scale Down) cấu hình của một máy chủ/instance hiện có (ví dụ: tăng CPU, RAM). Ưu điểm là đơn giản hơn trong một số trường hợp, không cần thay đổi kiến trúc nhiều. Nhược điểm là có giới hạn về cấu hình tối đa của một máy chủ và thường yêu cầu khởi động lại (downtime).

Hầu hết các nền tảng cloud tập trung vào tự động hóa Horizontal Scaling vì tính linh hoạt và khả năng mở rộng vượt trội của nó. Vertical Scaling thường được thực hiện thủ công hoặc bán tự động hơn.

Khi nào nên sử dụng Auto Scaling?

Auto Scaling là một công cụ mạnh mẽ, nhưng không phải lúc nào cũng là giải pháp tối ưu cho mọi loại ứng dụng. Việc xác định đúng các trường hợp mà Auto Scaling thực sự phát huy hiệu quả sẽ giúp bạn tận dụng tối đa lợi ích của nó. Dưới đây là một số tình huống phổ biến nên cân nhắc sử dụng Auto Scaling:

- Ứng dụng web/API có lưu lượng truy cập biến động: Đây là trường hợp sử dụng kinh điển nhất. Nếu website, blog, diễn đàn, hoặc API của bạn có lượng người dùng thay đổi rõ rệt theo giờ trong ngày, ngày trong tuần, hoặc theo mùa vụ, Auto Scaling là lựa chọn lý tưởng để đảm bảo hiệu năng ổn định và tiết kiệm chi phí. Ví dụ: các trang tin tức, mạng xã hội, ứng dụng đặt xe.

- Nền tảng Thương mại điện tử (E-commerce): Các trang E-commerce thường đối mặt với sự biến động cực lớn về lưu lượng, đặc biệt trong các đợt khuyến mãi lớn như Black Friday, Cyber Monday, hoặc các ngày lễ. Auto Scaling giúp các nền tảng này xử lý hàng triệu lượt truy cập mà không bị quá tải, đồng thời tiết kiệm chi phí vào những ngày thường vắng khách.

- Hệ thống xử lý dữ liệu theo lô (Batch Processing): Một số công việc xử lý dữ liệu lớn (như báo cáo cuối ngày, phân tích dữ liệu, xử lý video) đòi hỏi năng lực tính toán cao trong một khoảng thời gian ngắn. Auto Scaling có thể tự động khởi chạy một cụm máy chủ lớn để thực hiện công việc, sau đó tự động xóa chúng đi khi hoàn thành, tối ưu chi phí đáng kể.

- Ứng dụng Microservices: Trong kiến trúc microservices, mỗi dịch vụ nhỏ hoạt động độc lập. Auto Scaling cho phép bạn co giãn từng microservice riêng lẻ dựa trên nhu cầu cụ thể của dịch vụ đó. Ví dụ, dịch vụ xử lý thanh toán có thể cần scale mạnh hơn dịch vụ quản lý người dùng trong giờ cao điểm mua sắm.

- Môi trường Development (Phát triển) và Testing (Kiểm thử): Để tiết kiệm chi phí, bạn có thể sử dụng Scheduled Scaling để tự động bật các môi trường Dev/Test vào đầu giờ làm việc và tắt chúng đi vào cuối ngày hoặc cuối tuần khi không có ai sử dụng.

- Các ứng dụng yêu cầu tính sẵn sàng cao: Bất kỳ ứng dụng nào mà thời gian chết (downtime) gây ảnh hưởng nghiêm trọng đến hoạt động kinh doanh hoặc trải nghiệm người dùng đều nên sử dụng Auto Scaling kết hợp với các kỹ thuật HA khác (như multi-AZ deployment) để tăng cường khả năng chịu lỗi và đảm bảo hoạt động liên tục.

Ngược lại, các ứng dụng có lưu lượng truy cập cực kỳ ổn định, dễ dự đoán và không thay đổi nhiều theo thời gian có thể không cần đến sự phức tạp của Auto Scaling. Trong những trường hợp đó, việc cấp phát tài nguyên cố định có thể là đủ.

Auto Scaling trên các nền tảng Cloud phổ biến

Hầu hết các nhà cung cấp dịch vụ điện toán đám mây lớn (Public Cloud Providers) đều cung cấp các dịch vụ Auto Scaling mạnh mẽ và dễ sử dụng, được tích hợp chặt chẽ vào hệ sinh thái của họ. Mặc dù khái niệm cốt lõi là giống nhau, tên gọi và cách triển khai cụ thể có thể khác biệt đôi chút.

1. Amazon Web Services (AWS)

AWS là một trong những nhà tiên phong về Auto Scaling. Dịch vụ chính là Amazon EC2 Auto Scaling. Nó cho phép bạn tạo và quản lý các Auto Scaling Groups (ASGs). Bạn định nghĩa Launch Configurations hoặc Launch Templates để xác định cách tạo instance EC2 mới, và thiết lập các Scaling Policies (Dynamic, Scheduled, Predictive) dựa trên các chỉ số từ Amazon CloudWatch. ASG thường được sử dụng cùng với Elastic Load Balancing (ELB) để phân phối tải đến các instance trong nhóm.

2. Microsoft Azure

Trên Azure, tính năng tương đương được gọi là Azure Autoscale. Nó thường được sử dụng để tự động co giãn các Virtual Machine Scale Sets (VMSS) – một cách để quản lý một nhóm các máy ảo giống hệt nhau. Bạn có thể cấu hình các Autoscale settings dựa trên các metrics hiệu suất (từ Azure Monitor) hoặc theo một lịch trình cố định. Azure Autoscale cũng có thể áp dụng cho các dịch vụ khác như App Service Plans, Azure Functions.

3. Google Cloud Platform (GCP)

GCP cung cấp tính năng Auto Scaling cho các Managed Instance Groups (MIGs). Bạn định nghĩa một Instance Template và sau đó cấu hình Autoscaler cho MIG đó. Autoscaler có thể hoạt động dựa trên nhiều loại tín hiệu, bao gồm CPU Utilization, khả năng phục vụ của Load Balancer (HTTP(S) load balancing serving capacity), các chỉ số từ Cloud Monitoring, hoặc thậm chí dựa trên độ dài hàng đợi của Cloud Pub/Sub (Queue-based scaling).

4. Kubernetes (K8s)

Kubernetes, nền tảng điều phối container mã nguồn mở phổ biến, cũng có nhiều cơ chế Auto Scaling tích hợp:

- Horizontal Pod Autoscaler (HPA): Tự động điều chỉnh số lượng bản sao (replicas) của một Pod dựa trên các metrics như CPU hoặc Memory utilization, hoặc các custom metrics. Đây là cơ chế phổ biến nhất.

- Vertical Pod Autoscaler (VPA): Tự động điều chỉnh yêu cầu tài nguyên (CPU, Memory requests) cho các container trong Pod. Ít phổ biến hơn HPA và có thể yêu cầu Pod khởi động lại.

- Cluster Autoscaler: Tự động điều chỉnh số lượng node (máy chủ vật lý hoặc ảo) trong cluster Kubernetes của bạn dựa trên việc có Pod nào đang chờ được lên lịch (pending) do thiếu tài nguyên hay không.

Việc lựa chọn nền tảng nào phụ thuộc vào hệ sinh thái đám mây bạn đang sử dụng. Tuy nhiên, các nguyên tắc cơ bản về cấu hình metrics, thresholds và policies vẫn khá tương đồng giữa các nền tảng.

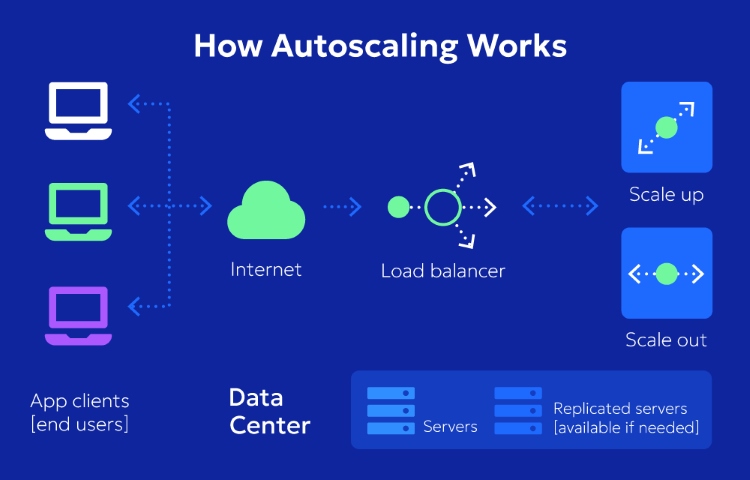

Phân biệt Auto Scaling và Load Balancing

Nhiều người mới tìm hiểu về cloud thường nhầm lẫn giữa Auto Scaling và Load Balancing (Cân bằng tải), hoặc không rõ mối quan hệ giữa chúng. Mặc dù cả hai đều góp phần xây dựng các ứng dụng có hiệu năng cao và tính sẵn sàng tốt, chúng giải quyết hai vấn đề khác nhau nhưng lại bổ trợ chặt chẽ cho nhau.

Load Balancing (Cân bằng tải) là gì? Hãy tưởng tượng Load Balancer như một người điều phối giao thông thông minh đứng trước một nhóm các máy chủ. Nhiệm vụ của nó là phân phối lưu lượng truy cập (incoming traffic) đến nhiều máy chủ/instance khác nhau một cách hiệu quả, dựa trên các thuật toán định sẵn (như Round Robin, Least Connections).

Mục đích chính của Load Balancing là:

- Tránh quá tải cho bất kỳ một máy chủ đơn lẻ nào.

- Tăng tính sẵn sàng bằng cách định tuyến traffic đến các máy chủ khỏe mạnh nếu có máy chủ bị lỗi.

- Cải thiện tốc độ phản hồi chung của ứng dụng.

Điểm khác biệt chính giữa Auto Scaling và Load Balancing:

- Load Balancer: Tập trung vào việc phân phối tải đến các tài nguyên hiện có. Nó không tự tạo ra hoặc xóa bớt tài nguyên.

- Auto Scaling: Tập trung vào việc điều chỉnh số lượng tài nguyên để đáp ứng mức tải chung. Nó không trực tiếp phân phối các yêu cầu riêng lẻ.

Mối quan hệ bổ trợ:

Trong hầu hết các kiến trúc ứng dụng web hiện đại, Auto Scaling và Load Balancing hoạt động cùng nhau để mang lại hiệu quả tối ưu.

Hãy hình dung kịch bản: Load Balancer đứng ở phía trước, nhận tất cả traffic từ người dùng. Phía sau Load Balancer là một nhóm các máy chủ được quản lý bởi Auto Scaling (ví dụ: một ASG trong AWS).

- Khi tải tăng lên, Auto Scaling sẽ thêm máy chủ mới vào nhóm.

- Load Balancer sẽ tự động phát hiện máy chủ mới (thông qua health check) và bắt đầu gửi một phần traffic đến máy chủ đó.

- Khi tải giảm, Auto Scaling sẽ xóa bớt máy chủ khỏi nhóm.

- Load Balancer sẽ ngừng gửi traffic đến máy chủ sắp bị xóa.

Như vậy, Auto Scaling đảm bảo luôn có đủ số lượng máy chủ cần thiết, còn Load Balancer đảm bảo traffic được phân phối đều đến các máy chủ đó. Sự kết hợp này tạo nên một hệ thống vừa linh hoạt, vừa ổn định và hiệu quả.

Lưu ý khi triển khai Auto Scaling

Triển khai Auto Scaling không chỉ đơn giản là bật tính năng lên. Để đạt được hiệu quả tối ưu và tránh những hành vi không mong muốn, bạn cần cân nhắc một số yếu tố quan trọng và áp dụng các thực hành tốt nhất (best practices) sau:

- Chọn đúng Metrics và Thresholds: Đây là yếu tố then chốt. Metrics bạn chọn (CPU, RAM, Network, Queue…) phải phản ánh chính xác điểm nghẽn (bottleneck) của ứng dụng. Thresholds (ngưỡng) cần được đặt hợp lý – không quá nhạy để tránh scale liên tục (thrashing), cũng không quá cao để tránh phản ứng chậm trễ. Hãy thử nghiệm và theo dõi để tìm ra giá trị tối ưu.

- Cấu hình Thời gian chờ (Cooldown Periods) hợp lý: Sau khi một hành động scale (Out hoặc In) diễn ra, hệ thống cần một khoảng thời gian để ổn định và các metrics phản ánh đúng tình trạng mới. Cooldown Period ngăn Auto Scaling thực hiện hành động scale tiếp theo quá sớm trong giai đoạn này, tránh các quyết định sai lầm.

- Thiết kế ứng dụng Stateless: Các ứng dụng không lưu trạng thái người dùng hoặc phiên làm việc trên chính máy chủ web (stateless) sẽ dễ dàng cho việc Scale Out/In hơn rất nhiều. Bất kỳ instance nào cũng có thể xử lý bất kỳ yêu cầu nào. Nếu ứng dụng là stateful, bạn cần các cơ chế phức tạp hơn để quản lý trạng thái phiên khi scale.

- Đảm bảo thời gian khởi động Instance nhanh: Thời gian từ lúc Auto Scaling quyết định Scale Out đến khi instance mới sẵn sàng phục vụ (boot time + application startup time) càng ngắn càng tốt. Hãy tối ưu hóa Image/AMI, sử dụng các kỹ thuật pre-warming hoặc caching để giảm thiểu độ trễ này.

- Sử dụng Health Checks hiệu quả: Tận dụng health check của cả Auto Scaling group và Load Balancer. Auto Scaling cần biết instance nào khỏe mạnh để không xóa nhầm, còn Load Balancer cần biết để chỉ gửi traffic đến instance sẵn sàng. Cấu hình health check chính xác giúp tăng độ tin cậy.

- Giám sát và Tinh chỉnh (Monitor & Tune): Auto Scaling không phải là “cấu hình một lần rồi quên”. Hãy liên tục giám sát hoạt động của nó, xem lại lịch sử scale, phân tích các metrics liên quan. Dựa trên dữ liệu thực tế, hãy tinh chỉnh lại các policies, thresholds, cooldown periods để ngày càng tối ưu hơn.

Áp dụng những lưu ý này sẽ giúp hệ thống Auto Scaling của bạn hoạt động mượt mà, hiệu quả và đáng tin cậy, thực sự mang lại những lợi ích như mong đợi.

Câu hỏi thường gặp về Auto Scaling (FAQ)

Khi tìm hiểu về Auto Scaling, có một số câu hỏi thường được nhiều người quan tâm. Dưới đây là giải đáp cho một số thắc mắc phổ biến:

Q1: Sử dụng Auto Scaling có mất thêm phí không?

A: Bản thân tính năng Auto Scaling trên hầu hết các nền tảng đám mây lớn như AWS, Azure, GCP thường không tính phí riêng. Tuy nhiên, bạn sẽ trả tiền cho các tài nguyên thực tế mà Auto Scaling khởi chạy và quản lý, ví dụ như chi phí giờ hoạt động của các máy chủ ảo (VM/EC2 instance), chi phí lưu lượng mạng, chi phí ổ đĩa… Do đó, chi phí tổng thể sẽ tăng hoặc giảm tùy theo số lượng tài nguyên được sử dụng tại mỗi thời điểm. Mục tiêu của Auto Scaling là giúp bạn trả tiền đúng với nhu cầu sử dụng, tránh lãng phí.

Q2: Cần kiến thức kỹ thuật chuyên sâu để cấu hình Auto Scaling không?

A: Để cấu hình Auto Scaling hiệu quả, bạn cần có hiểu biết cơ bản về điện toán đám mây, kiến trúc ứng dụng của bạn và các chỉ số hiệu năng quan trọng. Tuy nhiên, các nhà cung cấp cloud ngày càng cung cấp giao diện quản lý trực quan và các cấu hình mặc định hợp lý, giúp việc bắt đầu trở nên dễ dàng hơn. Đối với các cấu hình phức tạp hoặc tối ưu sâu, kiến thức chuyên sâu hơn về hệ thống và mạng sẽ hữu ích.

Q3: Auto Scaling phản ứng nhanh như thế nào?

A: Tốc độ phản ứng của Auto Scaling (độ trễ từ khi cần scale đến khi tài nguyên mới sẵn sàng) phụ thuộc vào nhiều yếu tố:

- Tần suất thu thập metrics: Khoảng thời gian giữa các lần lấy mẫu chỉ số (ví dụ: 1 phút hay 5 phút).

- Thời gian đánh giá ngưỡng: Chính sách thường yêu cầu metric duy trì trên/dưới ngưỡng trong một khoảng thời gian nhất định (ví dụ: 5 phút liên tục).

- Thời gian khởi động instance (Boot time): Thời gian cần để máy chủ ảo mới khởi động hệ điều hành và ứng dụng.

- Thời gian Health Check: Thời gian cần để hệ thống xác nhận instance mới khỏe mạnh.

- Cooldown Period: Thời gian chờ giữa các lần scale. Tổng cộng, độ trễ có thể từ vài phút đến lâu hơn. Predictive và Scheduled Scaling có thể giúp giảm độ trễ này.

Q4: Auto Scaling có thể dùng cho Database không?

A: Việc áp dụng Auto Scaling trực tiếp cho các database truyền thống (đặc biệt là primary node/master) thường phức tạp hơn so với ứng dụng stateless vì vấn đề đồng bộ dữ liệu và duy trì trạng thái. Tuy nhiên, có một số cách áp dụng:

- Scale Read Replicas: Auto Scaling thường được dùng để tự động tăng/giảm số lượng bản sao chỉ đọc (read replicas) của database để xử lý tải đọc tăng cao.

- Sử dụng Dịch vụ Database Managed: Nhiều dịch vụ database quản lý trên cloud (như AWS RDS Aurora, Azure SQL Database Hyperscale, Google Cloud Spanner) đã tích hợp sẵn các cơ chế co giãn (thường là cả về compute và storage) tinh vi hơn, được thiết kế riêng cho database. Đây thường là lựa chọn tốt hơn.

Kết luận

Auto Scaling đã thực sự cách mạng hóa cách chúng ta quản lý và vận hành hạ tầng trên nền tảng đám mây. Nó không còn là một khái niệm xa lạ mà đã trở thành một thành phần thiết yếu trong việc xây dựng các ứng dụng hiện đại, linh hoạt và hiệu quả về chi phí.

Qua bài viết này, hy vọng bạn đã có cái nhìn rõ ràng Auto Scaling là gì, những lợi ích vượt trội mà nó mang lại như tối ưu chi phí, đảm bảo hiệu năng, tăng cường tính sẵn sàng và tự động hóa quản lý. Chúng ta cũng đã cùng tìm hiểu về cơ chế hoạt động, các loại hình phổ biến, trường hợp nên áp dụng và cách nó tương tác với các công nghệ khác như Load Balancing.

Hiểu và áp dụng Auto Scaling đúng cách không chỉ giúp ứng dụng của bạn hoạt động ổn định hơn trước sự biến động của lưu lượng truy cập mà còn giải phóng nguồn lực IT, giúp doanh nghiệp tập trung vào việc phát triển sản phẩm và dịch vụ cốt lõi. Trong kỷ nguyên số với yêu cầu ngày càng cao về tốc độ và độ tin cậy, Auto Scaling chính là chìa khóa giúp hạ tầng của bạn luôn sẵn sàng cho mọi thử thách và cơ hội.

Nếu bạn đang vận hành ứng dụng trên cloud, hãy bắt đầu tìm hiểu và thử nghiệm cách cấu hình Auto Scaling trên nền tảng bạn đang sử dụng. Khám phá sức mạnh của sự tự động hóa và linh hoạt mà nó mang lại!

Hiệu quả của Auto Scaling phụ thuộc nhiều vào nền tảng hạ tầng ổn định phía dưới. Bạn có thể tham khảo dịch vụ thuê Cloud Server giá rẻ chất lượng, uy tín tại InterData. Hoặc trải nghiệm sức mạnh bộ xử lý thế hệ mới với lựa chọn thuê Cloud Server AMD cho hiệu năng cao.

Đối với ứng dụng cần cấu hình cao cấp và tốc độ xử lý vượt trội, giải pháp thuê Cloud Server Intel Platinum là lựa chọn đáng cân nhắc. Nền tảng này sử dụng chip Intel Xeon Platinum, ổ cứng SSD NVMe U.2 cùng băng thông được tối ưu, mang lại sự ổn định cao.