XGBoost là một trong những thuật toán học máy mạnh mẽ và phổ biến hiện nay, đặc biệt trong các bài toán phân loại và hồi quy. Được xây dựng dựa trên nguyên lý boosting, XGBoost mang lại hiệu suất vượt trội nhờ các tính năng như tối ưu hóa bộ nhớ, xử lý song song và chính quy hóa. Bài viết này sẽ giúp bạn hiểu rõ về XGBoost là gì, cách thức hoạt động, cấu trúc và những ứng dụng nổi bật của XGBoost trong học máy.

XGBoost là gì?

XGBoost, một thuật toán học máy vận hành theo nguyên tắc boosting và cụ thể hơn là gradient boosting, đã trở thành một công cụ được ưa chuộng rộng rãi cho việc giải quyết các bài toán thuộc lĩnh vực phân loại cũng như hồi quy.

Về cơ bản, XGBoost được xem như một phiên bản kế thừa và mở rộng từ thuật toán Cây Quyết định Tăng cường Gradient (Gradient Boosting Decision Tree – GBDT), tuy nhiên nó mang trong mình hàng loạt cải tiến đáng kể nhằm nâng cao hiệu suất hoạt động và năng lực xử lý các tập dữ liệu quy mô lớn.

Những điểm làm nên sự khác biệt của XGBoost bao gồm khả năng tối ưu hóa quá trình tính toán, cơ chế tích hợp nhằm hạn chế hiện tượng quá khớp (overfitting), cùng với đó là năng lực thực thi các tác vụ tính toán một cách song song.

Cách hoạt động của XGBoost

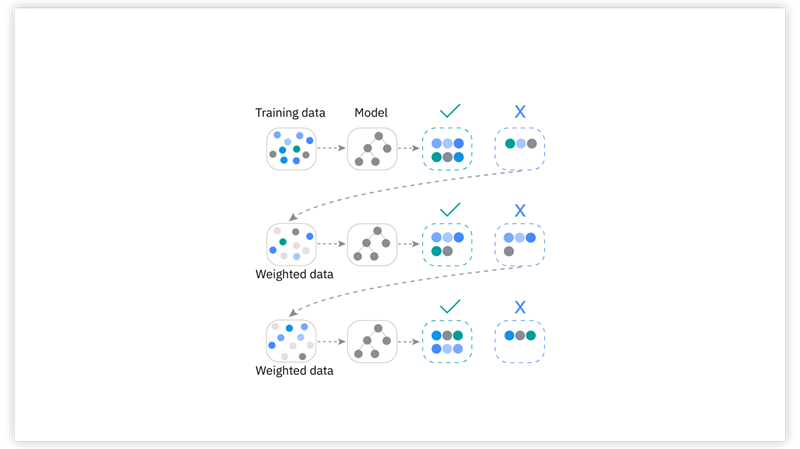

Cơ chế vận hành của XGBoost tuân thủ chặt chẽ nguyên lý cốt lõi của boosting. Theo đó, các mô hình học máy không được tạo ra độc lập mà được xây dựng tuần tự thành một chuỗi. Trong chuỗi này, mỗi mô hình mới được huấn luyện với mục tiêu chính là khắc phục những điểm yếu hay sai sót còn tồn tại từ mô hình liền trước nó.

Để thực hiện điều này, XGBoost chọn cây quyết định (decision trees) làm đơn vị mô hình cơ sở (base model) và áp dụng kỹ thuật gradient boosting để tuần tự xây dựng nên các cây quyết định này, hướng chúng tới việc giảm thiểu lỗi tổng thể của hệ thống.

Gradient Boosting

Gradient Boosting là một kỹ thuật học máy ensemble, tập trung vào việc xây dựng mô hình một cách cộng dồn, từng bước một, nhằm liên tục cải thiện độ chính xác.

Trọng tâm của phương pháp này là việc tối thiểu hóa một hàm mất mát (loss function) đã định trước. Ở mỗi giai đoạn lặp, thuật toán sẽ tạo ra một cây quyết định mới. Nhiệm vụ của cây này không phải là dự đoán trực tiếp kết quả cuối cùng, mà là dự đoán phần lỗi còn lại (phần dư – residual) từ tập hợp các cây đã được tạo ra trước đó.

Cây quyết định mới được huấn luyện sao cho nó góp phần giảm thiểu hiệu quả nhất giá trị lỗi của toàn bộ mô hình tính đến thời điểm hiện tại. Kết quả dự đoán cuối cùng của mô hình Gradient Boosting là sự kết hợp có trọng số của tất cả các cây quyết định đã được xây dựng trong suốt quá trình.

Cải tiến trong XGBoost

XGBoost đã mang đến những nâng cấp giá trị so với phương pháp gradient boosting cơ bản thông qua một số cơ chế đổi mới:

- Điều chuẩn hóa (Regularization): Ngay trong quá trình huấn luyện mô hình, XGBoost đã tích hợp hai dạng điều chuẩn (L1 và L2) vào hàm mục tiêu. Việc này tạo ra một “rào cản” chống lại sự phức tạp quá mức của mô hình, qua đó góp phần đáng kể vào việc hạn chế tình trạng quá khớp, đặc biệt phát huy tác dụng khi làm việc với những bộ dữ liệu có kích thước lớn hoặc bản chất phức tạp.

- Tính toán song song (Parallelization): Một ưu điểm vượt trội so với nhiều phiên bản gradient boosting trước đó là XGBoost được thiết kế để tận dụng khả năng xử lý song song của phần cứng. Điều này cho phép thuật toán thực hiện nhiều phép tính đồng thời, giúp rút ngắn đáng kể thời gian cần thiết cho việc huấn luyện mô hình.

- Tối ưu bộ nhớ (Memory Efficiency): XGBoost triển khai các cấu trúc dữ liệu và thuật toán được tối ưu hóa để sử dụng bộ nhớ một cách hiệu quả. Nhờ vậy, nó có khả năng xử lý các tập dữ liệu rất lớn mà không đòi hỏi quá nhiều tài nguyên bộ nhớ, làm tăng tính thực tiễn khi áp dụng vào các bài toán quy mô lớn.

- Xử lý giá trị khuyết (Missing Values Handling): Thuật toán này được trang bị khả năng xử lý tự động các giá trị bị thiếu trong dữ liệu đầu vào. Người dùng không nhất thiết phải thực hiện các bước tiền xử lý phức tạp để lấp đầy hoặc loại bỏ các giá trị này, giúp tiết kiệm thời gian và công sức trong giai đoạn chuẩn bị dữ liệu.

Cấu trúc của XGBoost

Để nắm bắt cách thức XGBoost vận hành một cách thấu đáo, việc xem xét kỹ lưỡng cấu trúc nền tảng cũng như các yếu tố cấu thành chủ chốt của thuật toán này là điều cần thiết.

Decision Trees (Cây quyết định)

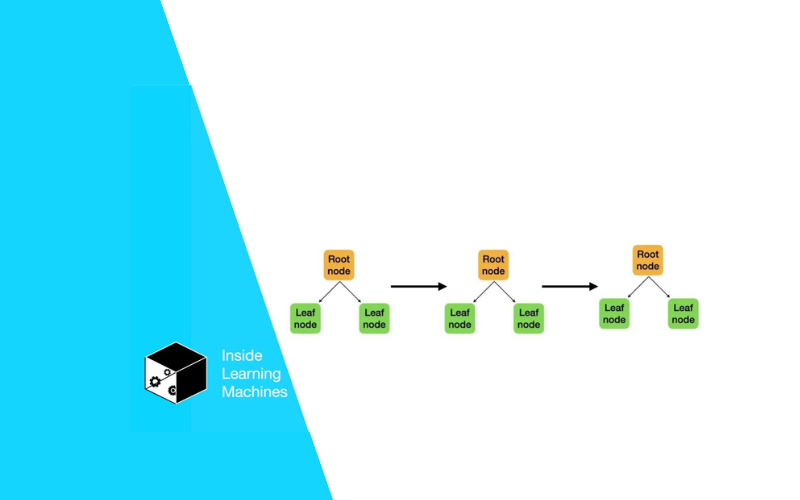

Trong kiến trúc của XGBoost, cây quyết định đóng vai trò là những mô hình dự đoán đơn lẻ, làm nền tảng cho toàn bộ hệ thống ensemble.

Về bản chất, một cây quyết định hoạt động như một lưu đồ, nơi dữ liệu được phân tách tại các nút dựa trên giá trị của các đặc trưng cụ thể. Mỗi nút đại diện cho một bài kiểm tra (phép chia) đối với một đặc trưng, và các nhánh phát sinh từ nút đó tương ứng với các kết quả có thể của bài kiểm tra.

Bằng cách đi theo các nhánh từ gốc đến lá, cây quyết định đưa ra một dự đoán. Cấu trúc này cho phép mô hình học và biểu diễn các mối liên hệ, đôi khi phức tạp, giữa các đặc trưng đầu vào và biến mục tiêu cần dự đoán.

Loss Function (Hàm mất mát)

Hàm mất mát giữ một vị trí trung tâm và không thể thiếu trong quy trình huấn luyện của XGBoost. Nó đóng vai trò như một thước đo định lượng mức độ sai lệch giữa dự đoán của mô hình và giá trị thực tế.

Mục đích xuyên suốt của thuật toán là điều chỉnh các tham số, cụ thể là cấu trúc và trọng số của các cây quyết định, sao cho giá trị của hàm mất mát này đạt mức tối thiểu.

XGBoost hỗ trợ nhiều loại hàm mất mát khác nhau, và việc lựa chọn hàm mất mát phù hợp phụ thuộc chặt chẽ vào bản chất của bài toán đang giải quyết; ví dụ, hàm log-loss thường được dùng cho bài toán phân loại nhị phân, trong khi lỗi bình phương trung bình (Mean Squared Error – MSE) lại thích hợp cho các bài toán hồi quy.

Learning Rate (Tốc độ học)

Tốc độ học (learning rate) là một siêu tham số có tầm ảnh hưởng lớn, đóng vai trò điều tiết trong quá trình huấn luyện của XGBoost. Tham số này quy định “trọng lượng” hay mức độ đóng góp của mỗi cây quyết định mới được thêm vào mô hình tổng thể trong từng bước lặp.

Việc thiết lập một tốc độ học quá lớn có thể khiến mô hình học quá nhanh và trở nên quá khớp (overfitting) với dữ liệu huấn luyện, mất đi khả năng tổng quát hóa. Ngược lại, một tốc độ học quá nhỏ lại có thể làm cho quá trình hội tụ diễn ra rất chậm, đòi hỏi nhiều bước lặp hơn và có nguy cơ bị kẹt ở một giải pháp chưa phải là tốt nhất.

Regularization (Điều chuẩn)

Cơ chế điều chuẩn (Regularization) là một thành phần then chốt được tích hợp trong XGBoost, đóng góp trực tiếp vào sự thành công của thuật toán này. Chức năng chính của nó là kiểm soát độ phức tạp của mô hình học được, ngăn chặn việc mô hình trở nên quá tinh vi và chỉ phù hợp với dữ liệu huấn luyện (tức là tránh overfitting).

XGBoost áp dụng hai kỹ thuật điều chuẩn phổ biến là L1 (còn gọi là Lasso) và L2 (còn gọi là Ridge). Các kỹ thuật này thêm “hình phạt” vào hàm mục tiêu dựa trên độ lớn của các trọng số trong mô hình, qua đó khuyến khích mô hình sử dụng các đặc trưng một cách cân bằng hơn và giảm thiểu sự phụ thuộc quá mức vào bất kỳ một hoặc một vài đặc trưng đơn lẻ nào.

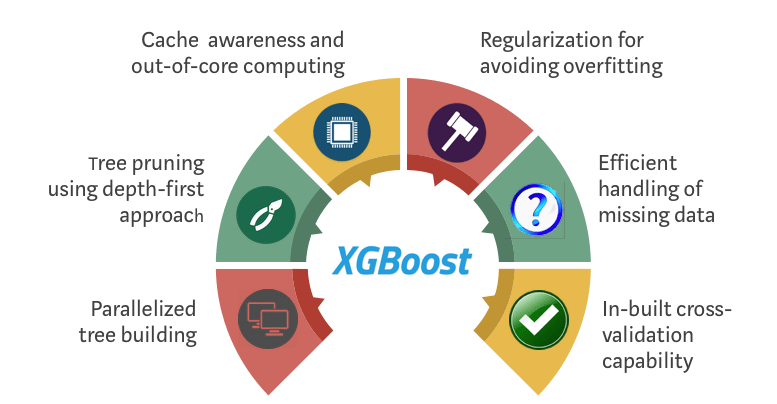

Các tính năng của mô hình XGBoost

Mô hình XGBoost là một triển khai phổ biến của phương pháp gradient boosting. Dưới đây là một số tính năng hoặc chỉ số của XGBoost khiến nó trở nên thú vị:

Chính quy hóa (Regularization): XGBoost có tùy chọn để xử phạt các mô hình phức tạp thông qua cả chính quy hóa L1 và L2. Chính quy hóa giúp ngăn ngừa hiện tượng overfitting (quá khớp mô hình).

Xử lý dữ liệu thưa (Sparse data): Các giá trị bị thiếu hoặc các bước xử lý dữ liệu như mã hóa one-hot có thể làm cho dữ liệu trở nên thưa. Bộ phân loại XGBoost sử dụng thuật toán phân chia dữ liệu nhận thức về tính thưa để xử lý các kiểu mẫu thưa khác nhau trong dữ liệu.

Phác thảo phân vị có trọng số (Weighted quantile sketch): Hầu hết các thuật toán cây quyết định hiện tại có thể tìm điểm phân chia khi các điểm dữ liệu có trọng số bằng nhau (sử dụng thuật toán phân vị phác thảo). Tuy nhiên, chúng không được trang bị để xử lý dữ liệu có trọng số. XGBoost có một thuật toán phác thảo phân vị có trọng số phân tán để xử lý hiệu quả dữ liệu có trọng số.

Cấu trúc khối cho học song song (Block structure for parallel learning): Để tăng tốc độ tính toán, bộ phân loại XGBoost có thể sử dụng nhiều lõi trên CPU. Điều này trở nên khả thi nhờ vào cấu trúc khối trong thiết kế hệ thống của nó. Dữ liệu được sắp xếp và lưu trữ trong các đơn vị bộ nhớ gọi là khối. Không giống như các thuật toán khác, phương pháp này cho phép các vòng lặp tiếp theo tái sử dụng bố cục dữ liệu thay vì tính toán lại từ đầu.

Nhận thức bộ nhớ đệm (Cache awareness): Trong học máy XGBoost, Scala yêu cầu truy cập bộ nhớ không liên tục để lấy các thống kê gradient theo chỉ mục hàng. Do đó, Tianqi Chen đã thiết kế XGBoost để tối ưu hóa việc sử dụng phần cứng. Việc tối ưu này được thực hiện bằng cách phân bổ bộ đệm nội bộ cho mỗi luồng, nơi các thống kê gradient có thể được lưu trữ. Và các cây song song này giúp cải thiện các thuật toán XGBoost nhờ vào sự hỗ trợ của các ngôn ngữ Julia và Java.

Tính toán ngoài bộ nhớ (Out-of-core computing): Tính năng này tối ưu hóa không gian đĩa có sẵn và tối đa hóa việc sử dụng nó khi xử lý các bộ dữ liệu lớn không vừa với bộ nhớ.

Một số lợi ích và hạn chế của thuật toán XGBoost

Lợi ích của XGBoost

XGBoost có khả năng mở rộng và hiệu quả cao, vì nó được thiết kế để xử lý các bộ dữ liệu lớn với hàng triệu hoặc thậm chí hàng tỷ đối tượng và đặc trưng.

XGBoost thực hiện các kỹ thuật xử lý song song và sử dụng tối ưu hóa phần cứng, chẳng hạn như tăng tốc GPU, để tăng tốc quá trình huấn luyện. Khả năng mở rộng và hiệu quả này khiến XGBoost trở nên phù hợp cho các ứng dụng dữ liệu lớn và dự đoán thời gian thực.

XGBoost cung cấp một loạt các tham số có thể tùy chỉnh và kỹ thuật chính quy hóa, cho phép người dùng điều chỉnh mô hình theo nhu cầu cụ thể của mình.

XGBoost cung cấp phân tích tầm quan trọng của đặc trưng tích hợp, giúp xác định các đặc trưng có ảnh hưởng lớn nhất trong bộ dữ liệu. Thông tin này có thể có giá trị trong việc chọn lựa đặc trưng, giảm chiều và hiểu rõ hơn về các mẫu dữ liệu cơ bản.

XGBoost không chỉ thể hiện hiệu suất xuất sắc mà còn trở thành công cụ được các nhà khoa học dữ liệu và chuyên gia học máy ưa chuộng trên toàn thế giới. Nó liên tục vượt trội so với các thuật toán khác trong các cuộc thi Kaggle, cho thấy hiệu quả trong việc tạo ra các mô hình dự đoán chất lượng cao.

Hạn chế của XGBoost

XGBoost có thể tốn nhiều tài nguyên tính toán, đặc biệt khi huấn luyện các mô hình phức tạp, làm cho nó ít phù hợp với các hệ thống hạn chế tài nguyên.

Mặc dù mạnh mẽ, XGBoost vẫn có thể nhạy cảm với dữ liệu nhiễu hoặc các điểm ngoại lai, yêu cầu phải xử lý dữ liệu cẩn thận để đạt hiệu suất tối ưu.

XGBoost có thể gặp phải vấn đề overfitting (quá khớp) khi sử dụng các bộ dữ liệu nhỏ hoặc khi sử dụng quá nhiều cây trong mô hình.

Mặc dù có các điểm số tầm quan trọng của đặc trưng, mô hình tổng thể có thể khó giải thích hơn so với các phương pháp đơn giản hơn như hồi quy tuyến tính hay cây quyết định. Sự thiếu minh bạch này có thể là một nhược điểm trong các lĩnh vực như y tế hoặc tài chính, nơi khả năng giải thích là rất quan trọng.

So sánh XGBoost với Gradient Boosting

XGBoost thực chất là một phiên bản tối ưu và mạnh mẽ hơn của thuật toán Gradient Boosting Machine (GBM). Dù chung gốc rễ là kỹ thuật boosting với cây quyết định, XGBoost mang lại những cải tiến vượt trội về tốc độ, khả năng kiểm soát mô hình và xử lý dữ liệu hiệu quả hơn hẳn so với phiên bản tiền nhiệm.

Cả hai thuật toán đều xây dựng mô hình tuần tự, nhưng chính những cải tiến kỹ thuật cụ thể đã giúp XGBoost trở thành lựa chọn hàng đầu trong nhiều bài toán. Chúng ta sẽ cùng khám phá những khác biệt chính, giúp bạn thấy rõ vì sao XGBoost lại được ưa chuộng đến vậy trong cộng đồng khoa học dữ liệu hiện nay.

Khác biệt về Regularization (Điều chuẩn hóa)

Điểm khác biệt then chốt là XGBoost tích hợp sẵn điều chuẩn hóa L1 (Lasso) và L2 (Ridge) vào hàm mục tiêu, giúp kiểm soát độ phức tạp mô hình hiệu quả. Ngược lại, GBM truyền thống thường thiếu cơ chế này và chủ yếu dựa vào việc giới hạn các tham số của cây để chống overfitting (quá khớp).

Điều chuẩn hóa (Regularization) là kỹ thuật thêm một thành phần “phạt” vào quá trình huấn luyện để ngăn mô hình trở nên quá phức tạp. XGBoost thực hiện điều này bằng cách phạt độ lớn của các trọng số ở nút lá, khuyến khích mô hình đơn giản và tổng quát hóa tốt hơn. Việc tích hợp trực tiếp vào hàm mục tiêu giúp kiểm soát overfitting một cách bài bản hơn.

Trong khi đó, để chống overfitting, người dùng GBM thường phải tinh chỉnh các tham số như max_depth (độ sâu tối đa của cây) hay min_samples_leaf (số mẫu tối thiểu ở lá). Mặc dù cũng có tác dụng, cách này không trực tiếp kiểm soát độ lớn của các trọng số như L1/L2 trong XGBoost, dẫn đến khả năng kiểm soát overfitting có phần hạn chế hơn, đặc biệt với dữ liệu phức tạp.

Tốc độ và Khả năng xử lý song song

XGBoost vượt trội về tốc độ huấn luyện nhờ khả năng xử lý song song và các tối ưu hóa cấp thấp. Nó có thể tận dụng hiệu quả phần cứng đa lõi, điều mà các thuật toán GBM cơ bản thường thực thi tuần tự và không làm được. Điều này tạo ra khác biệt lớn về thời gian, nhất là với dữ liệu lớn.

Khả năng xử lý song song (Parallel Processing) cho phép XGBoost thực hiện nhiều tính toán đồng thời. Cụ thể, quá trình tìm điểm chia tốt nhất cho các nút cây có thể diễn ra song song trên nhiều lõi CPU. XGBoost tổ chức dữ liệu theo cấu trúc “block” được sắp xếp trước, giúp việc truy cập và tính toán song song trở nên cực kỳ hiệu quả.

Ngược lại, các triển khai GBM truyền thống thường xây dựng cây một cách tuần tự, không được thiết kế để khai thác sức mạnh của CPU đa lõi. Ngoài ra, XGBoost còn có các tối ưu hóa khác như “cache-aware access”, giúp giảm thời gian chờ đợi khi truy xuất dữ liệu từ bộ nhớ, góp phần tăng thêm tốc độ xử lý chung của thuật toán.

Xử lý Giá trị bị thiếu (Missing Values)

XGBoost có khả năng tự động xử lý giá trị bị thiếu một cách thông minh nhờ cơ chế “sparsity-awareness”. Điều này trái ngược với GBM truyền thống, vốn yêu cầu người dùng phải tiền xử lý (ví dụ: imputation – điền giá trị) các ô dữ liệu bị thiếu trước khi đưa vào huấn luyện, giúp tiết kiệm đáng kể công sức.

Khi gặp giá trị thiếu, XGBoost không loại bỏ mẫu dữ liệu đó. Thay vào đó, trong quá trình huấn luyện, nó sẽ thử đưa mẫu đó vào cả nhánh trái và nhánh phải của một nút, sau đó “học” xem hướng đi nào (trái hay phải) là tốt nhất cho các giá trị thiếu tại nút đó. Hướng đi mặc định này được lưu lại và áp dụng cho dữ liệu mới.

Đối với GBM, bạn phải tự quyết định cách xử lý missing values: điền giá trị trung bình, trung vị, tạo một giá trị đặc biệt, hay thậm chí bỏ luôn dòng dữ liệu đó. Mỗi cách đều có ưu nhược điểm riêng và đòi hỏi công sức tiền xử lý. Khả năng tự động của XGBoost giúp quy trình làm việc gọn gàng và hiệu quả hơn nhiều.

Ứng dụng của XGBoost hiện nay

XGBoost và cây quyết định được tăng cường theo gradient được sử dụng trong nhiều ứng dụng khoa học dữ liệu, bao gồm:

- Học xếp hạng: Một trong những ứng dụng phổ biến của thuật toán XGBoost là dùng làm bộ xếp hạng. Trong tìm kiếm thông tin, mục tiêu của học xếp hạng là cung cấp nội dung cho người dùng được sắp xếp theo mức độ liên quan. Trong XGBoost, XGBRanker được xây dựng trên thuật toán LambdaMART.

- Dự đoán tỷ lệ nhấp quảng cáo: Các nhà nghiên cứu đã sử dụng mô hình huấn luyện XGBoost để xác định tần suất nhấp chuột vào quảng cáo trực tuyến trong 10 ngày dữ liệu nhấp chuột. Mục tiêu của nghiên cứu là đo lường hiệu quả của quảng cáo trực tuyến và chỉ ra quảng cáo nào hoạt động hiệu quả.

- Dự đoán doanh số cửa hàng: XGBoost có thể được sử dụng cho mô hình dự đoán, như đã được chứng minh trong bài báo này khi doanh số từ 45 cửa hàng Walmart được dự đoán sử dụng mô hình XGBoost.

- Phân loại phần mềm độc hại: Sử dụng bộ phân loại XGBoost, các kỹ sư tại Đại học Kỹ thuật Košice đã có thể phân loại phần mềm độc hại một cách chính xác, như đã trình bày trong bài báo của họ.

- Cuộc thi Kaggle: XGBoost đã là một thuật toán chiến thắng phổ biến trong các cuộc thi Kaggle, như đã được ghi nhận trên trang DMLC (Cộng đồng Học Máy Phân Tán (Deep) Machine Learning) với danh sách các người chiến thắng gần đây trong các cuộc thi Kaggle sử dụng XGBoost cho các bài thi của họ.

XGBoost là một công cụ mạnh mẽ trong lĩnh vực học máy, đặc biệt khi làm việc với các bộ dữ liệu lớn và phức tạp. Mặc dù có một số hạn chế như khả năng bị overfitting hoặc cần tài nguyên tính toán lớn, XGBoost vẫn là sự lựa chọn phổ biến nhờ hiệu suất và khả năng tối ưu hóa cao.

Việc áp dụng XGBoost vào các bài toán thực tế như dự đoán tỷ lệ nhấp quảng cáo, phân loại phần mềm độc hại hay dự đoán doanh số cửa hàng đã chứng minh được hiệu quả vượt trội của nó.

Để huấn luyện và triển khai các mô hình học máy đòi hỏi tài nguyên tính toán như XGBoost một cách hiệu quả, việc sở hữu một hạ tầng mạnh mẽ là rất quan trọng. Nếu bạn đang tìm kiếm giải pháp, việc thuê VPS chất lượng giá rẻ tại InterData có thể là khởi đầu tốt, cung cấp môi trường ổn định với phần cứng thế hệ mới như CPU Intel Xeon Platinum/AMD EPYC và ổ cứng SSD NVMe U.2 tốc độ cao.

Với những tác vụ huấn luyện phức tạp hơn hay cần khả năng mở rộng linh hoạt, dịch vụ thuê Cloud Server giá rẻ tốc độ cao của InterData mang đến hiệu năng vượt trội. Nền tảng này được xây dựng trên phần cứng cao cấp, dung lượng tối ưu, băng thông không giới hạn, đảm bảo tốc độ xử lý nhanh chóng cho các dự án học máy đòi hỏi cấu hình mạnh, tương tự như các gói Hosting giá rẻ tốc độ cao chuyên dụng.

Hãy liên hệ ngay để được tư vấn giải pháp phù hợp với nhu cầu của bạn!

INTERDATA

- Website: Interdata.vn

- Hotline: 1900-636822

- Email: [email protected]

- VPĐD: 240 Nguyễn Đình Chính, P.11. Q. Phú Nhuận, TP. Hồ Chí Minh

- VPGD: Số 211 Đường số 5, KĐT Lakeview City, P. An Phú, TP. Thủ Đức, TP. Hồ Chí Minh