Web scraping là kỹ thuật tự động trích xuất dữ liệu từ website, mang lại nhiều lợi ích nhưng cũng đi kèm những cân nhắc quan trọng. Bài viết này sẽ cung cấp một cái nhìn toàn diện, từ việc giải thích Web Scraping là gì, cách thức hoạt động, đến khám phá các ứng dụng thực tế. Chúng ta cũng sẽ tìm hiểu những lưu ý cần thiết, cách website tự bảo vệ, và làm rõ liệu scraping có phải lúc nào cũng xấu hay không.

Web Scraping là gì?

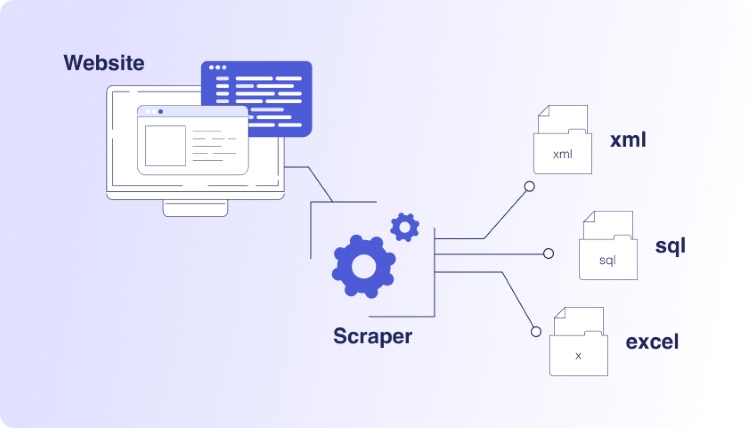

Web scraping (hay cào dữ liệu web) là kỹ thuật sử dụng chương trình máy tính để tự động trích xuất thông tin từ các trang web. Thay vì sao chép dữ liệu thủ công, phương pháp này tự động hóa toàn bộ quy trình lấy dữ liệu cần thiết từ website một cách hiệu quả.

Các chương trình này, thường gọi là bot hoặc scraper, sẽ truy cập vào website mục tiêu. Chúng phân tích cấu trúc mã nguồn của trang, phổ biến nhất là HTML (HyperText Markup Language), để xác định vị trí và lấy ra các phần dữ liệu cụ thể đã được người dùng chỉ định trước.

Mục tiêu chính của web scraping là chuyển đổi dữ liệu trên web, vốn thường ở dạng không có cấu trúc, thành định dạng có cấu trúc. Dữ liệu sau khi trích xuất sẽ được lưu lại (ví dụ: file CSV, JSON, cơ sở dữ liệu) để phục vụ cho việc phân tích và sử dụng dễ dàng hơn.

Ví dụ thực tế, một website so sánh giá sử dụng web scraping để tự động thu thập giá của cùng một sản phẩm từ nhiều trang thương mại điện tử khác nhau. Thông tin này giúp người dùng nhanh chóng tìm thấy nơi bán với mức giá tốt nhất mà không cần truy cập từng trang.

Cần phân biệt rõ web scraping với web crawling. Web scraping tập trung vào việc lấy dữ liệu cụ thể từ các trang web đã biết. Trong khi đó, web crawling (như cách Google hoạt động) lại tập trung vào việc khám phá và lập chỉ mục hàng loạt trang web trên internet.

Web scraping hoạt động như thế nào?

Web scraping hoạt động qua các bước tự động: gửi yêu cầu đến website, nhận và phân tích mã nguồn (thường là HTML), sau đó trích xuất dữ liệu cần thiết. Toàn bộ quá trình này được điều khiển bởi các chương trình máy tính chuyên dụng gọi là scraper hoặc bot.

Bước đầu tiên, scraper gửi một yêu cầu truy cập, thường là yêu cầu HTTP (Hypertext Transfer Protocol), đến địa chỉ URL của website mục tiêu. Yêu cầu này giống hệt cách trình duyệt của bạn “hỏi xin” nội dung trang web từ máy chủ (server) để hiển thị cho bạn xem.

Khi máy chủ phản hồi và gửi về nội dung trang (thường là mã HTML), scraper bắt đầu quá trình phân tích cú pháp (parsing). Nó “đọc” và “hiểu” cấu trúc của mã HTML này, tương tự như việc xác định các chương, mục, đề mục trong một cuốn sách vậy.

Sau khi hiểu cấu trúc, scraper sử dụng các bộ chọn (selectors) như CSS Selectors hoặc XPath. Các bộ chọn này hoạt động như những chỉ dẫn chính xác, giúp scraper tìm đúng vị trí và “nhặt” ra những phần dữ liệu cụ thể bạn muốn lấy từ trong mã HTML.

Cuối cùng, dữ liệu thô vừa được trích xuất sẽ được chương trình xử lý, làm sạch và chuyển đổi thành định dạng có cấu trúc. Dữ liệu này sau đó được lưu trữ lại dưới dạng tệp tin (như CSV, JSON) hoặc trong cơ sở dữ liệu để dễ dàng truy vấn và phân tích sau này.

Hãy tưởng tượng scraper như một trợ lý ảo đọc báo. Bạn giao nhiệm vụ chỉ lấy tên tác giả các bài viết. Trợ lý sẽ nhận tờ báo (HTML), tìm đến mục tên tác giả ở mỗi bài (parsing & selectors), rồi ghi lại danh sách tên tác giả đó cho bạn (extraction & storage).

Đối với các trang web hiện đại, nội dung có thể được tải không đồng bộ bằng JavaScript. Trong trường hợp này, scraper có thể cần kỹ thuật phức tạp hơn, ví dụ như dùng công cụ tự động hóa trình duyệt (như Selenium) để tương tác với trang như một người dùng thực sự.

Web Scraping được dùng để làm gì?

Web scraping có rất nhiều ứng dụng thực tế, giúp tự động thu thập dữ liệu từ website cho nhiều mục đích khác nhau. Kỹ thuật này hỗ trợ doanh nghiệp và cá nhân tổng hợp thông tin nhanh chóng, hiệu quả, từ đó đưa ra quyết định dựa trên dữ liệu chính xác và cập nhật.

Dưới đây là một số ứng dụng phổ biến nhất của web scraping:

- Nghiên cứu thị trường và đối thủ: Tự động lấy thông tin về sản phẩm, giá bán, chiến lược marketing, đánh giá khách hàng từ website đối thủ hoặc các trang thương mại điện tử. Việc này giúp doanh nghiệp hiểu rõ hơn về vị thế cạnh tranh và động thái của thị trường.

- Theo dõi và so sánh giá: Các hệ thống tự động dùng scraping để giám sát giá sản phẩm trên nhiều nền tảng bán lẻ trực tuyến. Doanh nghiệp có thể điều chỉnh giá cạnh tranh, còn người dùng có thể tìm được ưu đãi tốt nhất một cách nhanh chóng.

- Tạo danh sách khách hàng tiềm năng (Lead Generation): Thu thập thông tin liên hệ công khai như email, số điện thoại từ các danh bạ doanh nghiệp, website công ty hoặc mạng xã hội chuyên nghiệp. Dữ liệu này hỗ trợ hoạt động marketing và bán hàng (luôn cần tuân thủ luật bảo vệ dữ liệu cá nhân).

- Tổng hợp tin tức và nội dung: Xây dựng các trang tổng hợp tin tức bằng cách tự động thu thập bài viết mới từ nhiều nguồn báo chí, blog. Người đọc có thể cập nhật thông tin theo chủ đề yêu thích tại một nơi duy nhất, tiết kiệm thời gian tìm kiếm.

- Phân tích cảm xúc của khách hàng: Thu thập bình luận, đánh giá về sản phẩm, dịch vụ hoặc thương hiệu từ mạng xã hội, diễn đàn, trang bán hàng. Dữ liệu này sau đó được phân tích để hiểu rõ hơn về thái độ và ý kiến của công chúng.

- Thu thập dữ liệu tài chính, chứng khoán: Các nhà phân tích, nhà đầu tư sử dụng scraping để lấy dữ liệu lịch sử giá cổ phiếu, báo cáo tài chính công khai, tin tức kinh tế. Thông tin này rất quan trọng cho việc phân tích thị trường và ra quyết định đầu tư.

- Nghiên cứu khoa học và học thuật: Thu thập các bộ dữ liệu lớn từ nguồn công khai trên web như bài báo khoa học, số liệu thống kê, dữ liệu xã hội. Việc này phục vụ cho nhiều dự án nghiên cứu trong các lĩnh vực đa dạng như y tế, xã hội học, ngôn ngữ học.

- Theo dõi và phân tích SEO: Tự động kiểm tra thứ hạng từ khóa trên các công cụ tìm kiếm (như Google), phân tích hồ sơ backlink của website đối thủ, hoặc kiểm tra hàng loạt các yếu tố kỹ thuật SEO trên trang (on-page) một cách hiệu quả.

Những lưu ý khi thực hiện Web Scraping

Khi tiến hành web scraping, bạn cần hết sức lưu ý đến các yếu tố pháp lý, đạo đức và kỹ thuật. Việc thực hiện scraping một cách có trách nhiệm không chỉ giúp bạn tránh được rắc rối pháp lý, bị chặn truy cập mà còn thể hiện sự tôn trọng đối với website và cộng đồng mạng.

Dưới đây là những điểm quan trọng cần cân nhắc:

- Kiểm tra Điều khoản sử dụng (Terms of Service – ToS): Luôn đọc kỹ và tuân thủ ToS của website mục tiêu. Nhiều trang web quy định rõ việc cấm hoặc hạn chế truy cập tự động. Vi phạm ToS có thể dẫn đến việc bị chặn vĩnh viễn hoặc thậm chí là các vấn đề pháp lý.

- Tôn trọng Bản quyền và Quyền riêng tư: Không sử dụng web scraping để thu thập và tái phân phối nội dung có bản quyền một cách trái phép. Đặc biệt cẩn trọng khi xử lý dữ liệu cá nhân, đảm bảo tuân thủ các luật bảo vệ dữ liệu như GDPR hay Nghị định 13/2023/NĐ-CP của Việt Nam.

- Tuân thủ tệp

robots.txt: Đây là chỉ dẫn của website dành cho các bot tự động, nêu rõ các khu vực không được phép truy cập. Mặc dù không hoàn toàn mang tính pháp lý, việc tôn trọngrobots.txtđược coi là một quy tắc ứng xử cơ bản và nên làm. - Tránh làm quá tải máy chủ (Server): Đừng gửi yêu cầu với tần suất quá dày đặc. Hành động này có thể làm chậm hoặc sập website, ảnh hưởng xấu đến người dùng khác. Hãy giới hạn tốc độ scrape hợp lý (rate limiting) và cân nhắc chạy vào giờ thấp điểm.

- Cung cấp thông tin định danh (User-Agent): Sử dụng một chuỗi User-Agent rõ ràng cho scraper của bạn, có thể bao gồm tên dự án hoặc cách liên hệ. Điều này thể hiện sự minh bạch và cho phép quản trị viên website liên hệ nếu cần thiết, thay vì chặn ngay lập tức.

- Chuẩn bị cho sự thay đổi của Website: Cấu trúc HTML và thiết kế website có thể thay đổi bất cứ lúc nào mà không báo trước. Scraper của bạn cần được xây dựng linh hoạt hoặc có kế hoạch bảo trì, cập nhật thường xuyên để thích ứng với những thay đổi này.

- Ưu tiên sử dụng API nếu có: Nếu website cung cấp Giao diện lập trình ứng dụng (API – Application Programming Interface) công khai, đó luôn là cách tốt nhất, ổn định và hợp lệ nhất để lấy dữ liệu. Hãy kiểm tra kỹ khả năng này trước khi quyết định thực hiện scraping.

Cách bảo mật Web Scraping

Để bảo vệ website chống lại các hoạt động web scraping không mong muốn hoặc có hại, các hệ thống bảo mật hiện đại thường triển khai một quy trình gồm nhiều bước. Mục tiêu của quy trình này là phát hiện, xác minh và ngăn chặn các bot scraper tự động truy cập.

Quy trình bảo mật này thường bao gồm các bước cụ thể sau:

- Kiểm tra Dấu hiệu Kỹ thuật số (Fingerprinting): Hệ thống phân tích các thông tin trong header HTTP của yêu cầu truy cập. Dữ liệu này được so sánh với cơ sở dữ liệu lớn chứa hàng triệu biến thể đã biết, nhằm phân biệt giữa truy cập của người thật và bot, đồng thời đánh giá mức độ đáng ngờ.

- Đánh giá Danh tiếng IP (IP Reputation): Bước này tập trung vào việc phân tích địa chỉ IP nguồn của lượt truy cập. Dựa trên lịch sử dữ liệu về các hoạt động đáng ngờ hoặc tấn công từ các IP trước đó, hệ thống sẽ nhận diện và xử lý các IP có “tiếng xấu”.

- Phân tích Hành vi (Behavioral Analysis): Đây là bước quan trọng để phát hiện bot tinh vi. Hệ thống theo dõi và phân tích các kiểu hành vi lướt web, ví dụ như tốc độ click, đường đi chuột, cách điền form. Các hành vi bất thường, không giống người thật sẽ bị đánh dấu.

- Thực hiện các Thử thách Liên tiếp (Challenges): Để tiếp tục xác minh, website có thể yêu cầu trình duyệt thực hiện các thử thách đơn giản. Ví dụ như kiểm tra khả năng hỗ trợ cookie hoặc chạy mã JavaScript cơ bản. Các bot đơn giản thường không vượt qua được bước này.

- Sử dụng CAPTCHA: Nếu các biện pháp trên vẫn chưa đủ để xác định, biện pháp cuối cùng thường là sử dụng CAPTCHA. Đây là bài kiểm tra yêu cầu người dùng thực hiện thao tác (như chọn hình ảnh, gõ lại ký tự) mà bot tự động rất khó thực hiện thành công.

Việc áp dụng kết hợp các biện pháp bảo mật nhiều lớp như trên giúp website giảm thiểu hiệu quả rủi ro từ web scraping. Nó bảo vệ tài nguyên hệ thống, dữ liệu và đảm bảo trải nghiệm tốt hơn cho người dùng thực sự bằng cách ngăn chặn bot độc hại.

Tất cả Web Scraping đều xấu là đúng hay sai?

Quan điểm cho rằng mọi hoạt động web scraping đều xấu là hoàn toàn sai. Bản thân web scraping chỉ là một công cụ, một kỹ thuật tự động hóa. Việc nó tốt hay xấu phụ thuộc hoàn toàn vào cách thức triển khai và mục đích sử dụng trong từng bối cảnh cụ thể.

Web scraping có thể gây ra vấn đề nếu người thực hiện vi phạm luật bản quyền hoặc các Điều khoản sử dụng (Terms of Service) của website. Việc trích xuất dữ liệu bị cấm hoặc không được sự cho phép rõ ràng có thể dẫn đến những hậu quả pháp lý không mong muốn.

Một rủi ro khác là hoạt động scraping thiếu kiểm soát, gửi yêu cầu liên tục với tần suất cao. Điều này có thể gây quá tải nghiêm trọng cho máy chủ (server) của trang web nguồn, làm ảnh hưởng đến tốc độ truy cập và trải nghiệm của những người dùng thông thường khác.

Ngoài ra, việc thu thập dữ liệu cá nhân một cách không phù hợp hoặc không tuân thủ các quy định về bảo vệ quyền riêng tư là cực kỳ nguy hiểm. Hành vi này không chỉ vi phạm pháp luật (như GDPR, Nghị định 13/2023/NĐ-CP) mà còn gây mất an toàn thông tin người dùng.

Tuy nhiên, web scraping cũng có rất nhiều ứng dụng hợp pháp và hữu ích. Ví dụ điển hình là thu thập dữ liệu công khai cho mục đích nghiên cứu thị trường, phân tích đối thủ cạnh tranh, giám sát giá cả hoặc tổng hợp thông tin phục vụ cho các mục đích chính đáng khác.

Do đó, mấu chốt không nằm ở bản thân kỹ thuật scraping, mà nằm ở ý thức và trách nhiệm của người thực hiện. Việc tuân thủ pháp luật, quy định của website và các nguyên tắc đạo đức là điều kiện tiên quyết để đảm bảo hoạt động web scraping là hợp lệ và có ích.

Nhiều dự án web, như web scraping ở các quy mô khác nhau, đều cần một nền tảng hạ tầng ổn định và mạnh mẽ. Bạn có thể bắt đầu với dịch vụ thuê Web Hosting giá rẻ chất lượng cao tại InterData. Khi cần thêm tài nguyên và kiểm soát hệ thống, hãy xem xét dịch vụ thuê VPS giá rẻ uy tín với CPU AMD EPYC và ổ cứng NVMe tốc độ cao.

Với những dự án đòi hỏi hiệu năng cao, khả năng mở rộng linh hoạt như scraping quy mô lớn, dịch vụ thuê Cloud Server giá rẻ là lựa chọn lý tưởng. Tại InterData, hạ tầng dùng phần cứng thế hệ mới, NVMe U.2, băng thông cao và công nghệ ảo hóa tiên tiến, giúp hệ thống của bạn chạy nhanh, ổn định.