TPU (Tensor Processing Unit) là một vi mạch chuyên dụng được Google phát triển để tăng tốc các tác vụ học máy (Machine Learning) và trí tuệ nhân tạo (AI). Với khả năng xử lý các phép toán ma trận và tensor cực kỳ hiệu quả, TPU đã trở thành một công cụ quan trọng trong việc tối ưu hóa hiệu năng cho các mô hình học sâu (Deep Learning).

Bài viết này sẽ giúp bạn hiểu rõ hơn về TPU là gì, cách thức hoạt động của Bộ xử lý Tensor, những ưu nhược điểm khi sử dụng TPU cũng như các ứng dụng thực tế mà TPU có thể mang lại. Đọc ngay!

TPU là gì?

TPU (viết tắt của Tensor Processing Unit – Đơn vị Xử lý Tensor) là một loại vi mạch tích hợp chuyên dụng cho ứng dụng (ASIC – Application-Specific Integrated Circuit). Loại chip này được thiết kế và phát triển độc quyền bởi Google nhằm mục đích tăng tốc phần cứng cho các khối lượng công việc Học máy (Machine Learning).

TPU là một công nghệ phần cứng do Google tự nghiên cứu và phát triển. Ban đầu, chúng được tạo ra để phục vụ và tối ưu hóa hiệu năng cho chính các sản phẩm và dịch vụ dựa trên Trí tuệ nhân tạo (AI) của Google, trước khi được cung cấp rộng rãi hơn ra bên ngoài.

Mục tiêu cốt lõi của TPU là thực hiện cực kỳ hiệu quả các phép toán ma trận và tensor với quy mô lớn. Đây là những phép tính chiếm phần lớn tài nguyên và thời gian xử lý trong quá trình huấn luyện (training) và suy luận (inference) của các mô hình mạng nơ-ron nhân tạo và Học sâu (Deep Learning).

Là một ASIC, bộ xử lý Tensor có kiến trúc phần cứng được thiết kế đặc thù cho một nhiệm vụ duy nhất: tăng tốc tính toán học máy. Sự chuyên môn hóa này cho phép TPU đạt được hiệu suất tính toán (performance) và hiệu quả sử dụng năng lượng (performance-per-watt) vượt trội so với các bộ xử lý đa năng khi thực hiện các tác vụ ML đó.

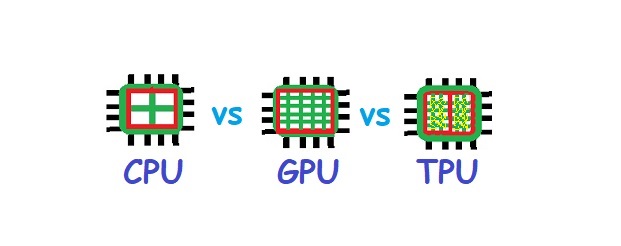

Cần phân biệt rõ công nghệ TPU với các bộ xử lý quen thuộc khác. CPU (Bộ xử lý Trung tâm) là bộ não đa năng xử lý logic tuần tự. GPU (Bộ xử lý Đồ họa) mạnh về xử lý song song hàng loạt. Còn TPU được tối ưu hóa chuyên biệt cho các phép toán ma trận/tensor khổng lồ của AI.

Để hiểu rõ hơn về sự khác biệt giữa CPU – GPU và TPU là gì, hãy tiếp tục tìm hiểu qua bài viết sau.

Tensor Processing Unit hoạt động như thế nào?

TPU cung cấp một số tính năng và chức năng hạn chế trực tiếp hữu ích cho các nhiệm vụ học máy (ML) và trí tuệ nhân tạo (AI), nhưng không nhất thiết phải hữu ích cho việc tính toán hàng ngày trong các tác vụ máy tính tổng quát.

Các mô hình học máy và các nền tảng AI sử dụng chúng, như học sâu và mạng nơ-ron, yêu cầu xử lý toán học phức tạp. Mặc dù có thể thực hiện các tác vụ này trên bộ xử lý trung tâm (CPU) thông thường hoặc các bộ xử lý đồ họa (GPU) tiên tiến hơn, nhưng cả hai đều không tối ưu hóa cho các tác vụ này.

Giống như GPU đã ra đời để tăng tốc xử lý toán học cho các trò chơi và trực quan hóa dữ liệu, TPU hiện nay tăng tốc các tác vụ toán học cho mạng nơ-ron và các mô hình học máy khác. Điều này bao gồm các phép toán nhân và cộng, hay còn gọi là các phép toán tích lũy.

Công nghệ TPU sử dụng một hoặc nhiều mảng các đơn vị logic số học nhân và cộng (ALU) được cấu hình như một ma trận. Xử lý ma trận này giải quyết các tác vụ toán học phức tạp nhanh hơn nhiều và với mức tiêu thụ điện năng thấp hơn rất nhiều so với các loại bộ xử lý truyền thống.

Tóm lại, TPU nhận dữ liệu đầu vào, phân tách dữ liệu thành các tác vụ gọi là vector, thực hiện phép nhân và cộng trên từng vector cùng lúc và song song, rồi sau đó trả kết quả ra mô hình học máy.

Thiết kế TPU gần đây tự động điều chỉnh hiệu suất tùy theo loại ứng dụng được hỗ trợ. Bộ xử lý Tensor cũng xử lý các đồ thị dòng dữ liệu cấp thấp và xử lý các phép toán đồ thị phức tạp mà các CPU và GPU truyền thống gặp khó khăn. TPU hỗ trợ phép toán số học dấu chấm động 16-bit và sử dụng bộ nhớ băng thông cao; các chip TPUv5p mới nhất có băng thông bộ nhớ lên đến 2.765 GB/s.

So sánh TPU với GPU và CPU

Mỗi bộ xử lý đều thực hiện cùng một công việc cơ bản: thực thi một tập hợp các chỉ dẫn để di chuyển và thực hiện các phép toán trên dữ liệu. Việc thực hiện các công việc này trên một chip phần cứng giúp tăng tốc độ. Một bộ xử lý thường thực hiện một tác vụ trong phần cứng trong vòng vài tỷ phần nghìn giây, một công việc nhanh chóng và hiệu quả.

Tuy nhiên, nếu một bộ xử lý không được thiết kế hoặc tối ưu hóa để thực hiện một tác vụ nhất định, thì tác vụ đó trở nên khó khăn, thậm chí là không thể thực hiện.

Thay vào đó, một ứng dụng phần mềm sẽ sử dụng tập hợp chỉ dẫn có sẵn của bộ xử lý để mô phỏng chức năng mà nó cần thực hiện. Tuy nhiên, việc mô phỏng phần mềm hầu như luôn dẫn đến hiệu suất kém hoặc không hiệu quả vì bộ xử lý cần nhiều thời gian hơn để hoàn thành nhiều công việc hơn.

Chẳng hạn, ảo hóa yêu cầu một sự chuyển đổi liên tục giữa các tài nguyên phần cứng vật lý và ảo. Phần mềm ảo hóa ban đầu sử dụng mô phỏng để xử lý các chuyển đổi này, điều này hạn chế nghiêm trọng hiệu suất và số lượng máy ảo (VM) có thể chạy trên một máy tính.

Khi các nhà thiết kế bộ xử lý thêm bộ chỉ dẫn ảo hóa vào thiết kế bộ xử lý hiện đại, hệ thống đã cải thiện đáng kể, cho phép máy tính xử lý nhiều VM cùng lúc với tốc độ gần như của bộ xử lý. Bộ xử lý thường được điều chỉnh và cập nhật theo cách này để giải quyết các vấn đề xử lý mới.

Ngược lại, một bộ xử lý đôi khi được chọn vì tính đơn giản hoặc tính phù hợp của nó. Ví dụ, một máy pha cà phê tự động. Dù có thể lập trình được, nhưng nó thường sử dụng một tập hợp nhỏ các chỉ dẫn của bộ xử lý để hoạt động, tránh một bộ xử lý đa năng tốn kém và lãng phí. ASIC (mạch tích hợp đặc biệt) kết quả là cung cấp một chip xử lý đơn giản hơn, cho phép hiệu suất nhanh hơn nhiều và yêu cầu ít năng lượng hơn.

Cuối cùng, CPU, GPU hay TPU là cái tốt nhất cho vấn đề tính toán đang gặp phải.

CPU

CPU là thiết bị đa năng được thiết kế để hỗ trợ hơn 1.500 chỉ dẫn khác nhau trong phần cứng, hay trên chip. Có thể có nhiều chip hoặc lõi được tích hợp vào cùng một gói bộ xử lý, cắm vào bo mạch chủ của máy tính.

CPU xử lý các chỉ dẫn và dữ liệu một lần mỗi lần qua một đường ống nội bộ. Điều này tăng tốc các quá trình riêng lẻ nhưng giới hạn số lượng phép toán đồng thời. CPU có thể hỗ trợ nhiều mô hình học máy và được áp dụng tốt nhất khi mô hình có các đặc điểm sau:

- Cần tính linh hoạt cao hoặc dự kiến sẽ thay đổi, điều này thường thấy trong các mô hình thử nghiệm.

- Không yêu cầu thời gian huấn luyện đáng kể.

- Có kích thước nhỏ và sử dụng các lô huấn luyện nhỏ.

- Sử dụng đầu vào/ra hệ thống (I/O) và băng thông mạng hạn chế.

GPU

GPU cung cấp khả năng xử lý song song cao và hỗ trợ các tác vụ toán học chi tiết mà CPU đa năng không thể xử lý mà không có mô phỏng. Những đặc điểm này thường hữu ích cho các ứng dụng trực quan hóa, bao gồm trò chơi điện tử, phần mềm ứng dụng toán học, và các công cụ render 3D và các công cụ khác, như AutoCAD. Vì thường không có các chỉ dẫn cơ bản, GPU thường được kết hợp với CPU trong cùng một hệ thống máy tính.

Tuy nhiên, GPU không đơn giản chỉ là một CPU với nhiều chỉ dẫn hơn. Thay vào đó, nó là một cách tiếp cận hoàn toàn khác để giải quyết các vấn đề tính toán cụ thể.

Số lượng chức năng hạn chế mà GPU thực hiện có nghĩa là mỗi lõi nhỏ hơn rất nhiều, nhưng kiến trúc song song cao cho phép hàng nghìn lõi xử lý các tác vụ tính toán song song khổng lồ và thông lượng dữ liệu cao. Tuy nhiên, GPU không thể đa nhiệm tốt và thường có khả năng truy cập bộ nhớ hạn chế.

GPU rất phù hợp với nhiều mô hình học máy đòi hỏi nhiều tài nguyên và được áp dụng tốt nhất khi mô hình có các đặc điểm sau:

- Không linh hoạt hoặc ít thay đổi đáng kể.

- Sử dụng các phép toán đặc biệt cho GPU.

- Có kích thước vừa và lớn và yêu cầu các kích thước lô huấn luyện lớn, trong đó tính song song cao là có lợi.

TPU

TPU gần như là một ASIC, cung cấp một số chức năng toán học hạn chế, chủ yếu là xử lý ma trận, đặc biệt dành cho các tác vụ học máy. TPU nổi bật với thông lượng cao và khả năng song song mà thường thấy ở GPU, nhưng được thiết kế ở mức độ cực đoan.

Các chip TPU điển hình chứa một hoặc nhiều TensorCores. Mỗi TensorCore sử dụng các đơn vị nhân ma trận (MXU), một đơn vị vector và một đơn vị vô hướng. Mỗi MXU bao gồm một mảng ALU nhân-cộng 128 x 128, và mỗi MXU thực hiện 16.000 phép nhân-cộng mỗi chu kỳ đồng hồ sử dụng toán học dấu chấm động.

Công nghệ TPU chủ yếu là các chip được xây dựng đặc biệt, lý tưởng cho các mô hình học máy với các đặc điểm sau:

- Phụ thuộc chủ yếu vào xử lý ma trận.

- Không phụ thuộc vào các phép toán phần mềm huấn luyện đặc biệt như TensorFlow.

- Cần thời gian dài – có thể là vài tuần hoặc thậm chí vài tháng – để hoàn thành.

- Sử dụng các kích thước lô lớn, chẳng hạn như mạng nơ-ron tích chập (CNN).

Ưu và nhược điểm của Tensor Processing Unit là gì?

Ưu và nhược điểm của việc sử dụng TPU là gì? Đơn vị xử lý Tensor (TPU) của Google mang lại những lợi thế hiệu năng ấn tượng cho các tác vụ học máy chuyên biệt. Tuy nhiên, như mọi công nghệ phần cứng chuyên dụng, TPU cũng đi kèm với những ưu và nhược điểm riêng mà người dùng cần xem xét cẩn thận.

Ưu điểm của TPU

- Hiệu năng tính toán ML vượt trội: Ưu điểm lớn nhất của TPU là khả năng xử lý cực nhanh các phép toán ma trận và tensor lớn. Điều này giúp rút ngắn đáng kể thời gian huấn luyện các mô hình học sâu phức tạp và tăng tốc độ suy luận so với CPU hay GPU thông thường.

- Hiệu quả năng lượng cao (cho ML): Do được tối ưu hóa ở cấp độ phần cứng cho các phép toán ML, TPU thường tiêu thụ ít điện năng hơn GPU để hoàn thành cùng một khối lượng công việc. Điều này giúp tiết kiệm chi phí vận hành, đặc biệt quan trọng với các trung tâm dữ liệu lớn.

- Tối ưu chi phí cho workload lớn: Đối với các tác vụ huấn luyện hoặc suy luận quy mô lớn, chạy liên tục trên Google Cloud Platform (GCP), việc sử dụng Cloud TPU có thể mang lại hiệu quả chi phí tổng thể (tính trên hiệu năng đạt được) tốt hơn so với việc thuê GPU.

Nhược điểm của TPU

- Tính chuyên dụng cao, kém linh hoạt: TPU được thiết kế riêng cho học máy. Chúng không hiệu quả hoặc không phù hợp cho các tác vụ tính toán đa năng khác mà CPU xử lý tốt, hoặc các tác vụ đồ họa/tính toán song song đa dạng mà GPU đảm nhiệm.

- Phụ thuộc vào hệ sinh thái Google Cloud: Hiện tại, cách phổ biến nhất để truy cập và sử dụng sức mạnh của TPU là thông qua dịch vụ Cloud TPU trên Google Cloud Platform. Điều này hạn chế lựa chọn nhà cung cấp đám mây và khả năng tiếp cận so với GPU.

- Đòi hỏi tối ưu hóa mã nguồn: Để khai thác tối đa hiệu năng của công nghệ TPU, lập trình viên đôi khi cần điều chỉnh cách viết mã hoặc sử dụng các API, thư viện được tối ưu riêng cho TPU (như trong TensorFlow, PyTorch, JAX). Điều này có thể yêu cầu thêm nỗ lực học hỏi.

- Chi phí có thể cao cho nhu cầu nhỏ lẻ: Mặc dù hiệu quả cho quy mô lớn, chi phí thuê Cloud TPU theo giờ có thể là một khoản đầu tư đáng kể đối với các cá nhân, nhóm nhỏ hoặc các dự án không yêu cầu khả năng tính toán cường độ cao liên tục.

Các điểm nổi bật của các thế hệ Tensor Processing Unit

Mỗi thế hệ TPU được giới thiệu đều mang đến những cải tiến và năng lực vượt trội so với trước. Sau đây là tóm tắt các điểm đáng chú ý của từng phiên bản.

- TPUv1: Đây là thế hệ TPU đầu tiên được công bố rộng rãi. Nó được thiết kế như một bộ xử lý chuyên dụng cho phép nhân ma trận 8-bit và chỉ có khả năng xử lý số nguyên.

- TPUv2: Nhận thấy hạn chế về băng thông của TPUv1, các kỹ sư đã cải tiến phiên bản này với băng thông bộ nhớ tăng gấp đôi, đạt 16GB RAM. TPUv2 cũng có khả năng xử lý số thực dấu phẩy động (floating point), làm cho nó hữu dụng cho cả việc huấn luyện (training) và suy luận (inference).

- TPUv3: Ra mắt năm 2018, TPUv3 sở hữu số lượng bộ xử lý gấp đôi và được triển khai với số chip gấp 4 lần so với TPUv2. Những nâng cấp này mang lại cho phiên bản v3 hiệu suất cao gấp 8 lần các thế hệ trước đó.

- TPUv4: Phiên bản này được công bố vào ngày 18 tháng 5 năm 2021, là thế hệ TPU mới nhất tại thời điểm đó. CEO Google đã thông báo rằng TPUv4 cung cấp hiệu suất cao hơn gấp đôi so với thế hệ TPUv3.

- Edge TPU: Đây là phiên bản TPU được thiết kế cho các tác vụ nhỏ hơn, tối ưu hóa để tiêu thụ ít năng lượng hơn các phiên bản TPU khác. Dù chỉ cần 2 watt điện, Edge TPU có thể thực hiện tới 4 nghìn tỷ phép tính mỗi giây (TOPS – Tera Operations Per Second). Edge TPU thường được tích hợp trên các thiết bị nhỏ gọn như điện thoại Pixel 4 của Google.

Các trường hợp sử dụng TPU tốt nhất

Giống như bất kỳ loại bộ xử lý nào, chip TPU sẽ không thể hoạt động nếu không có phần mềm có khả năng sử dụng các chức năng của TPU. Phần mềm TensorFlow cung cấp khung công tác giúp đưa dữ liệu đến TPU và sau đó trả lại kết quả cho các mô hình học máy (ML) liên quan.

Công nghệ TPU được sử dụng trong nhiều nhiệm vụ khác nhau. Các ứng dụng phổ biến nhất bao gồm:

- Học máy. Khả năng xử lý ma trận của TPU giúp tăng tốc nhanh chóng các thuật toán và mô hình ML thường liên quan đến các tác vụ yêu cầu tính toán phức tạp, chẳng hạn như xử lý ngôn ngữ tự nhiên, nhận dạng hình ảnh và nhận dạng giọng nói.

- Phân tích dữ liệu. TPU chủ yếu thích hợp với các tác vụ toán học sử dụng xử lý ma trận. Bất kỳ công việc phân tích dữ liệu hoặc xử lý dữ liệu nào có sử dụng xử lý ma trận, dù có liên quan đến các dự án ML hay AI hay không, đều được hưởng lợi từ TPU.

- Điện toán biên. Điện toán biên trở nên hấp dẫn khi dữ liệu cần được xử lý ngay tại hoặc gần nguồn dữ liệu, chẳng hạn như trong nhà máy hoặc phương tiện tự lái. TPU trở nên hữu ích khi môi trường điện toán biên cần hỗ trợ xử lý ma trận với thông lượng cao, chẳng hạn như huấn luyện hoặc cập nhật các mô hình ML ngay tại hiện trường sử dụng dữ liệu IoT thời gian thực.

- Điện toán đám mây. TPU được sử dụng làm nền tảng cho các dịch vụ TensorFlow trên đám mây của Google, áp dụng cho các khối lượng công việc ML và AI trong Google Cloud Platform (GCP), bao gồm chatbot, công cụ gợi ý, nền tảng tạo mã, hệ thống AI sinh tạo, tạo giọng nói, thị giác máy tính và các dự án ML/AI khác.

TPU đang ngày càng trở thành công nghệ phần cứng không thể thiếu trong các ứng dụng học máy và trí tuệ nhân tạo nhờ vào khả năng xử lý toán học mạnh mẽ và tiết kiệm năng lượng.

Mặc dù TPU có những hạn chế về tính linh hoạt và yêu cầu tối ưu hóa mã nguồn, nhưng với các tác vụ học máy quy mô lớn, TPU vẫn là lựa chọn hàng đầu nhờ vào hiệu suất vượt trội.

Nếu bạn đang tìm kiếm một giải pháp hiệu quả cho các tác vụ học máy và trí tuệ nhân tạo, thuê VPS chất lượng cao tại InterData là lựa chọn lý tưởng. Với phần cứng thế hệ mới như CPU AMD EPYC/Intel Xeon Platinum, SSD NVMe U.2, và băng thông cao, dịch vụ này giúp tối ưu hóa hiệu suất máy chủ với chi phí hợp lý, đảm bảo đáp ứng nhu cầu sử dụng của bạn một cách linh hoạt và ổn định.

Ngoài ra, thuê Cloud Server cấu hình cao tại InterData cũng là giải pháp mạnh mẽ cho các dự án lớn và yêu cầu tốc độ xử lý cao. Với cấu hình mạnh mẽ, dung lượng tối ưu, và băng thông vượt trội, bạn có thể yên tâm khi triển khai các mô hình học máy hoặc ứng dụng AI phức tạp, giúp tăng tốc và tối ưu hóa hiệu quả công việc của mình.

Liên hệ với InterData để được hỗ trợ và tư vấn về dịch vụ!

INTERDATA

- Website: Interdata.vn

- Hotline: 1900-636822

- Email: [email protected]

- VPĐD: 240 Nguyễn Đình Chính, P.11. Q. Phú Nhuận, TP. Hồ Chí Minh

- VPGD: Số 211 Đường số 5, KĐT Lakeview City, P. An Phú, TP. Thủ Đức, TP. Hồ Chí Minh