Trong lĩnh vực trí tuệ nhân tạo (AI) và học máy, Học lý thuyết sai lệch thời gian (Temporal Difference Learning – TD Learning) đã trở thành một phương pháp quan trọng giúp các tác nhân (agents) ra quyết định tối ưu trong các môi trường có phần thưởng bị trì hoãn. Bài viết này sẽ giúp bạn hiểu rõ hơn về Temporal Difference Learning là gì, từ các tham số quan trọng, lợi ích, hạn chế đến ứng dụng thực tiễn của phương pháp này trong nhiều lĩnh vực. Đọc ngay!

Temporal Difference Learning là gì?

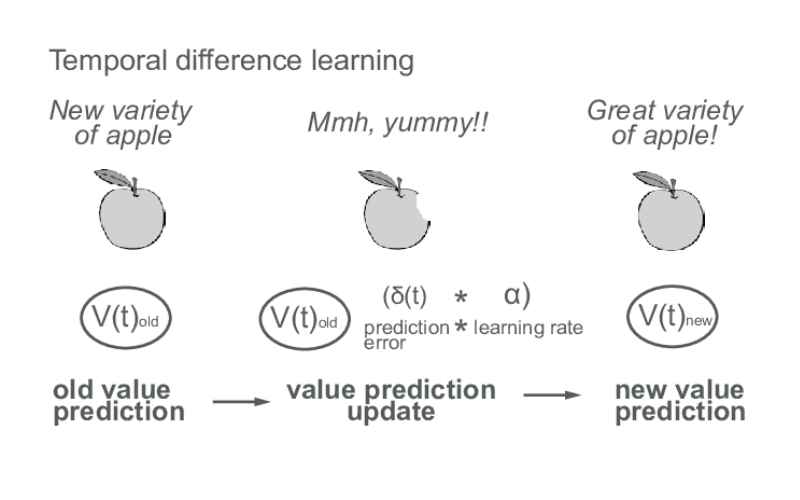

Temporal Difference Learning – Học lý thuyết sai lệch thời gian (TD Learning) là một phương pháp trong học máy tăng cường (reinforcement learning) để huấn luyện các tác nhân (agents) đưa ra các quyết định tối ưu. Phương pháp này hoạt động bằng cách học từ sự khác biệt giữa các dự đoán liên tiếp theo thời gian.

Ví dụ, một robot có thể dự đoán rằng thực hiện một hành động trong một trạng thái cụ thể sẽ mang lại phần thưởng +5. Tuy nhiên, khi thực hiện hành động đó, robot nhận được phần thưởng +10. Sai lệch TD +5 sẽ khiến robot cập nhật lại các dự đoán của mình.

Theo thời gian, bằng cách giảm thiểu sai lệch TD, tác nhân sẽ học cách đưa ra các dự đoán chính xác hơn về phần thưởng lâu dài. Điều này giúp tác nhân xác định các hành động tốt nhất để thực hiện trong các tình huống khác nhau.

Tầm quan trọng của TD Learning trong AI và Học máy

Học lý thuyết sai lệch thời gian (TD Learning) đã trở thành một khái niệm quan trọng trong trí tuệ nhân tạo (AI) và học máy. Phương pháp này là sự kết hợp giữa các ưu điểm của phương pháp Monte Carlo và lập trình động (dynamic programming), giúp cải thiện hiệu quả học tập trong các môi trường có phần thưởng bị trì hoãn.

TD Learning hỗ trợ việc học thích nghi từ các chuỗi không đầy đủ bằng cách cập nhật hàm giá trị dựa trên sự khác biệt giữa các dự đoán trong tương lai. Phương pháp này rất quan trọng đối với các ứng dụng liên quan đến việc ra quyết định trong thời gian thực, bao gồm robot, trò chơi và tài chính.

Bằng cách sử dụng cả phần thưởng quan sát được và phần thưởng kỳ vọng trong tương lai, TD Learning trở thành một trong những phương pháp mạnh mẽ để tạo ra các thuật toán thông minh và thích nghi.

Các tham số cần biết trong Temporal Difference Learning

Trong phần này, chúng ta sẽ khám phá các tham số cụ thể khi nói về Temporal Difference Learning. Tìm hiểu ngay!

- Hàm giá trị trạng thái (State-Value Function): Bạn đã từng nghe đến “trạng thái” trong học máy chưa? Hàm giá trị trạng thái đo lường phần thưởng lâu dài mong đợi từ một trạng thái ban đầu s, dưới chính sách π. Nó giống như một hệ thống đánh giá mức độ tốt hoặc xấu của các trạng thái trong một cuộc phiêu lưu dài.

- Hàm giá trị hành động (Action-Value Function): Hàm giá trị hành động đo lường phần thưởng dài hạn khi thực hiện một hành động cụ thể trong một trạng thái nhất định. Hãy tưởng tượng nó giống như việc kiểm tra lợi ích bạn sẽ nhận được khi thực hiện một động thái trong trò chơi bàn cờ yêu thích!

- Hệ số chiết khấu (Discount Factor): Trong học lý thuyết sai lệch thời gian, hệ số chiết khấu là yếu tố giúp đảm bảo tổng phần thưởng luôn có giá trị hữu hạn. Nó là một chỉ số từ 0 đến 1 và xác định tầm quan trọng của các phần thưởng trong tương lai. Hệ số chiết khấu càng lớn, ta càng chú trọng đến phần thưởng trong tương lai. Nó giống như việc chọn giữa việc ăn một miếng bánh nhỏ ngay bây giờ hoặc chờ đợi để có một miếng bánh lớn hơn sau!

- Tốc độ học (Learning Rate): Cuối cùng, là “tốc độ học”. Thường được ký hiệu là α, tốc độ học cho biết mức độ mà thông tin mới sẽ thay thế thông tin cũ. Ví dụ, đây giống như việc bạn phải quyết định nghe một tin đồn mới hay giữ lại những tin cũ đã biết.

- Sai lệch TD (TD Error): Để quá trình học trở nên chính xác hơn, chúng ta có sai lệch TD. Đây là chỉ số đo lường sự khác biệt giữa giá trị ước tính của một cặp trạng thái-hành động và phần thưởng quan sát được. Nếu các tin đồn (thông tin mới) chính xác, sai lệch TD sẽ bằng 0!

Lợi ích của Temporal Difference Learning mang lại

Trong phần này, cùng khám phá các lợi ích của TD Learning là gì, và tại sao nó lại là một phần không thể thiếu trong học máy tăng cường.

- Học tập hiệu quả: Bằng cách cập nhật các ước tính giá trị thông qua sự khác biệt giữa các bước thời gian, Temporal Difference Learning giúp quá trình học tập trở nên nhanh chóng và hiệu quả hơn. Kết quả là, học máy trở nên hiệu quả nhờ vào sức mạnh của phương pháp này.

- Tăng cường tính linh hoạt: TD Learning là một phương pháp thích nghi tuyệt vời. Nó giúp các tác nhân học và thích ứng với môi trường thay đổi nhờ khả năng học trực tuyến, giúp phản ứng tốt hơn với các phần thưởng và trạng thái thay đổi.

- Cân Bằng Khám Phá và Tận Dụng: Cân bằng tốt giữa việc khám phá (exploration) và tận dụng (exploitation) là yếu tố thiết yếu trong học máy tăng cường. Các kỹ thuật học lý thuyết sai lệch thời gian như SARSA giúp học và tinh chỉnh các chính sách sao cho hài hòa giữa khám phá và tận dụng.

- Khả Năng Học Trực Tuyến: Một trong những ưu điểm lớn của TD Learning là khả năng học trực tuyến theo thời gian thực. Nó không yêu cầu biết trước đầy đủ chi tiết của một tập (episode), trái ngược với phương pháp Monte Carlo, tạo thêm sự linh hoạt trong các ứng dụng thực tế.

- Ứng Dụng Trong Nhiều Lĩnh Vực: Phạm vi ứng dụng của Temporal Difference Learning trên nhiều lĩnh vực là rất rộng lớn. Từ robot học và hệ thống điều khiển đến trí tuệ nhân tạo và trò chơi điện tử, lợi ích của phương pháp học này là vô cùng lớn.

Hạn chế của Temporal Difference Learning cần chú ý

Mặc dù học lý thuyết sai lệch thời gian mang lại nhiều lợi ích, nhưng nó cũng có một số hạn chế, bao gồm:

- Phụ thuộc vào ước tính ban đầu: Học lý thuyết sai lệch thời gian rất phụ thuộc vào các ước tính ban đầu. Điều này có thể giống như một trò chơi ném phi tiêu, khi mà cú ném đầu tiên sẽ quyết định rất nhiều. Nếu ước tính ban đầu sai lệch quá nhiều, chúng ta có thể vô tình luyện tập sai hướng.

- Hội tụ chậm: Hãy nhớ đến trò chơi thời thơ ấu, khi bạn bị bịt mắt và phải hướng bạn bè đến mục tiêu? Hội tụ trong TD learning cũng giống như vậy, thường sẽ diễn ra chậm trong các vòng lặp, như thể bạn đang ra chỉ dẫn cho người bạn bị bịt mắt di chuyển với những điều chỉnh rất nhỏ từng bước.

- Overfitting: Overfitting giống như vị khách bữa tối phiền phức mà nhiều mô hình học máy không thể tránh khỏi. Học lý thuyết sai lệch thời gian cũng dễ bị overfitting, đặc biệt là khi độ phức tạp của mô hình tăng lên. Điều này giống như việc ghi nhớ câu trả lời cho các câu hỏi đố – rất hữu ích cho những câu hỏi chính xác đó, nhưng không tốt cho những câu hỏi tương tự nhưng khác một chút.

- Nhạy cảm với tốc độ học: Học lý thuyết sai lệch thời gian giống như việc cô bé Goldilocks tìm một bát cháo hoàn hảo – nó rất nhạy cảm với tốc độ học. Nếu tốc độ học quá cao hoặc quá thấp, chúng ta sẽ gặp phải các vấn đề như học không ổn định và hội tụ chậm.

- Khó hiểu: Cuối cùng, Temporal Difference Learning có thể là một thử thách khó khăn. Nó đòi hỏi hiểu biết về các khái niệm kỹ thuật như Quy Trình Quyết Định Markov (Markov Decision Processes) và cấu trúc phần thưởng. Nó giống như học một ngôn ngữ mới với các quy tắc, ngữ pháp và thành ngữ riêng biệt.

Ứng dụng của TD Learning

Học lý thuyết sai lệch thời gian có ứng dụng rộng rãi trong nhiều lĩnh vực, bao gồm:

- Hiểu về các tình trạng như bệnh tâm thần phân liệt: TD Learning được sử dụng để nghiên cứu và hiểu các tình trạng như bệnh tâm thần phân liệt, trong đó có sự suy giảm trong quá trình học hỏi và ra quyết định.

- Can thiệp dược lý đối với Dopamine: Phương pháp này giúp nghiên cứu tác động của các can thiệp dược lý lên quá trình học hỏi thông qua việc điều chỉnh hệ thống dopamine.

- Học máy: Học lý thuyết sai lệch thời gian được ứng dụng rộng rãi trong các thuật toán học máy, đặc biệt là trong các nhiệm vụ học tăng cường, nhờ vào hiệu quả và tính năng vượt trội của nó.

Sự khác biệt giữa Q-Learning và Temporal Difference Learning là gì?

Q-Learning là một thuật toán cụ thể trong nhóm các thuật toán Học Lý Thuyết Sai Lệch Thời Gian. Mục tiêu của nó là học hàm Q, đại diện cho phần thưởng kỳ vọng khi thực hiện một hành động cụ thể trong một trạng thái nhất định.

Trong khi đó, Temporal Difference Learning bao gồm một phạm vi rộng hơn các thuật toán có thể học cả hàm V và hàm Q. Dưới đây là một sự so sánh chi tiết giữa hai phương pháp này.

Khung cơ bản

TD Learning là một khung phương pháp sử dụng sự khác biệt giữa giá trị ước tính của hai trạng thái liên tiếp để cập nhật các ước tính giá trị.

Ngược lại, Q-Learning là một thuật toán hoạt động trong khung này, nó đặc biệt học chất lượng của các hành động để quyết định hành động nào cần thực hiện.

Phương pháp học

Về phương pháp học, TD Learning học từ các trạng thái liên tiếp trong môi trường để dự đoán các phần thưởng trong tương lai.

Q-Learning, tuy nhiên, có một chút khác biệt. Nó sử dụng các cập nhật trong hàm giá trị hành động để tối đa hóa phần thưởng kỳ vọng.

Chính sách

Một điểm khác biệt quan trọng nữa là cách tiếp cận chính sách. TD Learning cho phép cả việc học theo chính sách (on-policy) như SARSA, cũng như học không theo chính sách (off-policy) như Q-Learning.

Tuy nhiên, Q-Learning là một dạng học không theo chính sách, ước tính chính sách tối ưu mà không quan tâm đến chính sách mà tác nhân đang theo đuổi.

Sai lệch và phương sai

Về sai lệch và phương sai, Temporal Difference Learningcố gắng cân bằng giữa hai yếu tố này trong các thuật toán của nó.

Q-Learning, mặt khác, đôi khi có thể bị thiên lệch khi ước tính phần thưởng trong tương lai do thao tác “max”, điều này tạo ra một chút sai lệch trong ước tính giá trị hành động.

Trường hợp sử dụng

Cuối cùng, Temporal Difference Learning thường được sử dụng làm nền tảng cho nhiều thuật toán học khác, như Q-Learning và SARSA, để kể tên một vài ví dụ.

Q-Learning, với thiết kế cụ thể của nó, được sử dụng rộng rãi khi tác nhân cần học một chính sách tối ưu trong khi khám phá môi trường.

Các thuật toán khác trong Temporal Difference Learning

Trong phần này, chúng ta sẽ khám phá các thuật toán chính được sử dụng trong học lý thuyết sai lệch thời gian.

Thuật Toán Sarsa

Thuật toán Sarsa hoạt động bằng cách ước tính giá trị của cặp trạng thái-hành động hiện tại dựa trên phần thưởng và ước tính của cặp trạng thái-hành động tiếp theo. Điều này cho phép nó liên tục cập nhật và điều chỉnh để có chính sách tốt hơn.

Q-Learning

Khác với Sarsa, Q-Learning trực tiếp ước tính chính sách tối ưu, ngay cả khi các hành động được thực hiện theo chính sách khám phá hoặc ngẫu nhiên hơn. Q-Learning hoạt động bằng cách cập nhật giá trị của một hành động trong một trạng thái mà không xem xét hành động tiếp theo.

TD-Lambda

TD-Lambda kết hợp lợi ích của phương pháp Monte Carlo và Temporal Difference Learning, sử dụng tham số 𝜆 để cân bằng hai phương pháp này. Nó sử dụng dấu vết đủ điều kiện (eligibility traces) để lưu lại các trạng thái, trả lại một phần của phần thưởng cho các trạng thái vừa được viếng thăm.

Sarsa-Lambda

Sarsa-Lambda là một mở rộng của thuật toán Sarsa, thêm dấu vết đủ điều kiện để “nhìn lại” hiệu quả các cặp trạng thái-hành động trước đó. Điều này giúp tăng hiệu quả bằng cách phân bổ phần thưởng cho tất cả các trạng thái trước đó.

Double Q-Learning

Double Q-Learning giải quyết sự thiên lệch trong ước tính của Q-Learning truyền thống bằng cách duy trì hai ước tính giá trị Q độc lập. Việc chọn giá trị Q nào để cập nhật là ngẫu nhiên, giúp cung cấp một ước tính ít thiên lệch hơn.

Tổng kết lại, Temporal Difference Learning là một phương pháp mạnh mẽ trong học máy, đặc biệt hữu ích trong các ứng dụng đòi hỏi ra quyết định trong thời gian thực như robot, trò chơi điện tử và tài chính.

Mặc dù phương pháp này có một số hạn chế nhưng những lợi ích mà nó mang lại, đặc biệt là khả năng học thích nghi và tối ưu hóa phần thưởng lâu dài, khiến TD Learning trở thành một công cụ không thể thiếu trong việc phát triển các thuật toán thông minh.

Hy vọng bài viết của InterData sẽ có ích cho bạn.

INTERDATA

- Website: Interdata.vn

- Hotline: 1900-636822

- Email: [email protected]

- VPĐD: 240 Nguyễn Đình Chính, P.11. Q. Phú Nhuận, TP. Hồ Chí Minh

- VPGD: Số 211 Đường số 5, KĐT Lakeview City, P. An Phú, TP. Thủ Đức, TP. Hồ Chí Minh

![Node trong n8n là gì? Cách hoạt động và các loại Node [2025] 9 Node trong n8n là gì](https://interdata.vn/blog/wp-content/uploads/2025/05/Node-trong-n8n-la-gi-120x86.jpg)