Trong học máy, overfitting (quá khớp) là một vấn đề phổ biến mà các mô hình học máy phải đối mặt, khi chúng học quá kỹ dữ liệu huấn luyện đến mức không thể tổng quát tốt cho dữ liệu mới. Hiện tượng này khiến mô hình trở nên kém hiệu quả khi áp dụng vào thực tế, dẫn đến kết quả không chính xác.

Vậy overfitting là gì, và làm thế nào để tránh hiện tượng này? Trong bài viết này, InterData sẽ giúp bạn hiểu rõ về overfitting trong học máy, các nguyên nhân dẫn đến nó và các phương pháp phòng tránh hiệu quả, giúp bạn cải thiện chất lượng mô hình học máy của mình.

Overfitting là gì?

Trong học máy, overfitting (quá khớp) xảy ra khi một thuật toán khớp quá chặt chẽ, thậm chí chính xác với dữ liệu huấn luyện, dẫn đến việc mô hình không thể đưa ra các dự đoán chính xác hoặc kết luận từ bất kỳ dữ liệu nào ngoài dữ liệu huấn luyện.

Overfitting làm mất đi mục đích của mô hình học máy. Việc tổng quát hóa của một mô hình đối với dữ liệu mới là điều cho phép chúng ta sử dụng các thuật toán học máy hàng ngày để đưa ra dự đoán và phân loại dữ liệu.

Khi các thuật toán học máy được xây dựng, chúng sử dụng một bộ dữ liệu mẫu để huấn luyện mô hình. Tuy nhiên, khi mô hình huấn luyện quá lâu trên dữ liệu mẫu hoặc khi mô hình quá phức tạp, nó có thể bắt đầu học “nhiễu”, hay những thông tin không liên quan trong bộ dữ liệu.

Khi mô hình ghi nhớ nhiễu và khớp quá chặt với bộ dữ liệu huấn luyện, mô hình trở nên “overfitted” và không thể tổng quát tốt với dữ liệu mới. Nếu một mô hình không thể tổng quát tốt với dữ liệu mới, nó sẽ không thể thực hiện tốt các tác vụ phân loại hay dự đoán mà nó được tạo ra.

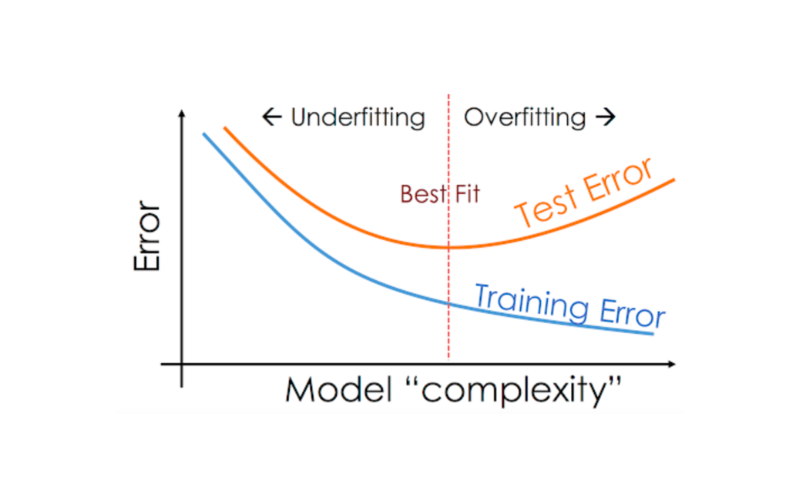

Các chỉ số quan trọng để phát hiện overfitting là tỷ lệ lỗi thấp và độ biến thiên cao. Để ngăn chặn hiện tượng này, một phần của bộ dữ liệu huấn luyện thường được tách ra làm “dữ liệu kiểm tra” để kiểm tra hiện tượng overfitting. Nếu mô hình có tỷ lệ lỗi thấp trên dữ liệu huấn luyện và tỷ lệ lỗi cao trên dữ liệu kiểm tra, thì đó là dấu hiệu của overfitting.

Các nguyên nhân gây ra overfitting:

- Mô hình phức tạp. Sử dụng mô hình quá phức tạp cho một tác vụ đơn giản có thể dẫn đến overfitting. Ví dụ, sử dụng một hồi quy đa thức bậc cao cho dữ liệu có tính chất tuyến tính.

- Dữ liệu không đủ. Nếu không có đủ dữ liệu, mô hình có thể tìm ra những mẫu không thực sự tồn tại.

- Dữ liệu nhiễu. Nếu dữ liệu huấn luyện chứa lỗi hoặc sự dao động ngẫu nhiên, mô hình overfitted sẽ coi những điều này là các mẫu.

Tác động của overfitting là rất lớn. Mặc dù một mô hình overfitted có thể đạt độ chính xác cao trên dữ liệu huấn luyện, nhưng nó sẽ hoạt động kém trên dữ liệu mới chưa thấy vì nó không đủ tính tổng quát.

Overfitting so với underfitting

Nếu quá trình huấn luyện hoặc độ phức tạp của mô hình dẫn đến overfitting, cách phản ứng hợp lý là dừng huấn luyện sớm, gọi là “early stopping”, hoặc giảm độ phức tạp của mô hình bằng cách loại bỏ những đầu vào ít quan trọng. Tuy nhiên, nếu bạn dừng huấn luyện quá sớm hoặc loại bỏ quá nhiều đặc trưng quan trọng, bạn có thể gặp phải vấn đề ngược lại, đó là underfitting.

Underfitting xảy ra khi mô hình chưa được huấn luyện đủ lâu hoặc các biến đầu vào không đủ quan trọng để xác định mối quan hệ có ý nghĩa giữa các biến đầu vào và đầu ra.

Cả hai trường hợp, overfitting và underfitting đều khiến mô hình không thể xác định được xu hướng chủ đạo trong bộ dữ liệu huấn luyện. Do đó, underfitting cũng không thể tổng quát tốt với dữ liệu chưa thấy.

Tuy nhiên, khác với overfitting, mô hình underfitted có độ chệch (bias) cao và độ biến thiên (variance) thấp trong dự đoán. Điều này thể hiện sự cân bằng giữa độ chệch và độ biến thiên, hay còn gọi là tradeoff giữa bias và variance. Khi mô hình học, độ chệch giảm, nhưng độ biến thiên có thể tăng lên và dẫn đến overfitting.

Mục tiêu khi huấn luyện một mô hình là tìm ra “điểm ngọt” giữa overfitting và underfitting, để mô hình có thể xác định được xu hướng chủ đạo và áp dụng rộng rãi với các bộ dữ liệu mới.

Cách phát hiện Overfitting

Việc phát hiện overfitting là một bước quan trọng trong quá trình học máy. Dưới đây là một số cách để bạn nhận diện hiện tượng này:

- Tập xác nhận: Chia dữ liệu của bạn thành hai tập: tập huấn luyện và tập xác nhận. Nếu mô hình hoạt động tốt trên tập huấn luyện nhưng kém trên tập xác nhận, thì có khả năng là overfitting.

- Đường học: Vẽ đồ thị thể hiện hiệu suất của mô hình trên cả tập huấn luyện và tập xác nhận theo thời gian. Nếu hai đường bắt đầu tách xa nhau, đó là dấu hiệu của overfitting.

- Kỹ thuật kiểm tra chéo (Cross-validation): Sử dụng kiểm tra chéo, trong đó dữ liệu huấn luyện được chia thành nhiều phần và mô hình được đánh giá trên từng phần.

Khi nào bạn cần đặc biệt kiểm tra overfitting:

- Bạn đang sử dụng mô hình phức tạp.

- Bạn có một lượng dữ liệu nhỏ.

- Những tình huống có mức độ quan trọng cao, chẳng hạn như trong chẩn đoán y khoa.

Cách ngăn ngừa hiện tượng Overfitting trong Machine Learning

Một cách để giải quyết vấn đề quá khớp là làm phong phú và tăng kích thước tập dữ liệu huấn luyện. Việc này giúp mô hình tiếp xúc với nhiều mẫu dữ liệu đa dạng hơn, từ đó học được các đặc trưng tổng quát hơn thay vì ghi nhớ dữ liệu huấn luyện.

Ngoài việc cải thiện tập dữ liệu, bạn có thể áp dụng các kỹ thuật khoa học dữ liệu khác, bao gồm:

Dừng sớm (Early Stopping)

Phương pháp này theo dõi hiệu suất của mô hình trên một tập dữ liệu kiểm tra (validation set) riêng biệt trong quá trình huấn luyện. Khi hiệu suất trên tập kiểm tra bắt đầu giảm, quá trình huấn luyện sẽ được dừng lại, ngay cả khi hiệu suất trên tập huấn luyện vẫn đang tăng. Điều quan trọng là phải xác định thời điểm dừng thích hợp để tránh mô hình chưa học đủ (underfitting).

Học kết hợp (Ensemble Methods)

Thay vì chỉ sử dụng một mô hình duy nhất, phương pháp học kết hợp sử dụng nhiều mô hình (thường được gọi là “weak learners” vì chúng có thể không chính xác khi đứng riêng lẻ) và kết hợp các dự đoán của chúng. Có hai phương pháp chính:

- Bagging (Bootstrap Aggregating): Huấn luyện các mô hình một cách độc lập trên các tập con dữ liệu khác nhau (được lấy mẫu có thay thế từ tập dữ liệu gốc) và kết hợp dự đoán bằng cách lấy trung bình hoặc bỏ phiếu.

- Boosting: Huấn luyện các mô hình một cách tuần tự, trong đó mỗi mô hình sau cố gắng sửa chữa lỗi của mô hình trước.

Tăng cường dữ liệu (Data Augmentation)

Kỹ thuật này tạo ra các biến thể của dữ liệu huấn luyện hiện có bằng cách áp dụng các phép biến đổi nhỏ. Mục đích là làm cho tập dữ liệu huấn luyện trở nên đa dạng hơn, ngăn mô hình học thuộc lòng các mẫu dữ liệu cụ thể.

Ví dụ, đối với dữ liệu hình ảnh, ta có thể áp dụng các phép biến đổi như xoay, lật, thay đổi độ sáng, hoặc thêm nhiễu. Quan trọng là các phép biến đổi phải được thực hiện một cách hợp lý để không làm thay đổi bản chất của dữ liệu.

Huấn luyện với nhiều dữ liệu hơn

Khi lượng dữ liệu huấn luyện tăng lên, các đặc trưng quan trọng sẽ trở nên rõ ràng hơn. Mô hình có thể nhận diện được mối quan hệ giữa các thuộc tính đầu vào và biến đầu ra. Điều kiện duy nhất trong phương pháp này là dữ liệu đưa vào mô hình phải sạch; nếu không, nó sẽ làm trầm trọng thêm vấn đề overfitting.

Tăng cường dữ liệu (Data augmentation)

Một phương pháp thay thế việc huấn luyện với nhiều dữ liệu hơn là tăng cường dữ liệu, phương pháp này ít tốn kém và an toàn hơn so với phương pháp trước. Tăng cường dữ liệu làm cho mẫu dữ liệu trông có vẻ khác nhau một chút mỗi khi mô hình xử lý.

Thêm nhiễu vào dữ liệu đầu vào

Một phương pháp tương tự như tăng cường dữ liệu là thêm nhiễu vào dữ liệu đầu vào và đầu ra. Thêm nhiễu vào dữ liệu đầu vào giúp mô hình ổn định mà không làm ảnh hưởng đến chất lượng và tính bảo mật của dữ liệu, trong khi thêm nhiễu vào đầu ra giúp làm đa dạng hóa dữ liệu.

Tuy nhiên, việc thêm nhiễu phải được thực hiện trong giới hạn để không làm dữ liệu bị sai lệch hoặc khác biệt quá nhiều.

Chọn lựa đặc trưng (Feature selection)

Mỗi mô hình có nhiều tham số hoặc đặc trưng tùy thuộc vào số lớp, số nơ-ron, v.v. Mô hình có thể phát hiện ra nhiều đặc trưng dư thừa hoặc những đặc trưng có thể xác định từ các đặc trưng khác, dẫn đến độ phức tạp không cần thiết. Chúng ta biết rằng mô hình càng phức tạp, khả năng overfit càng cao.

Kiểm tra chéo (Cross-validation)

Kiểm tra chéo là một phương pháp mạnh mẽ để ngăn chặn overfitting. Dữ liệu đầy đủ được chia thành các phần. Trong phương pháp K-fold cross-validation, chúng ta cần chia dữ liệu thành k phần. Sau đó, mô hình được huấn luyện trên k-1 phần và sử dụng phần còn lại làm bộ kiểm tra.

Phương pháp trên giúp chúng ta tinh chỉnh các siêu tham số của mô hình học máy và kiểm tra với dữ liệu hoàn toàn chưa thấy.

Đơn giản hóa dữ liệu

Đến nay, chúng ta đã biết rằng độ phức tạp của mô hình là một trong những nguyên nhân hàng đầu gây ra overfitting. Phương pháp đơn giản hóa dữ liệu được sử dụng để giảm overfitting bằng cách giảm độ phức tạp của mô hình sao cho mô hình không bị overfit.

Một số phương pháp bao gồm cắt tỉa cây quyết định, giảm số lượng tham số trong mạng nơ-ron và sử dụng dropout trong mạng nơ-ron.

Regularization (Chuẩn hóa)

Nếu overfitting xảy ra khi mô hình quá phức tạp, việc giảm số lượng đặc trưng là hợp lý. Các phương pháp chuẩn hóa như Lasso, L1 có thể có lợi khi chúng ta không biết nên loại bỏ đặc trưng nào khỏi mô hình. Regularization áp dụng “hình phạt” đối với các tham số đầu vào có hệ số lớn, từ đó hạn chế độ biến thiên của mô hình.

Ensembling (Hợp nhất mô hình)

Ensembling là một kỹ thuật học máy kết hợp nhiều mô hình cơ bản để tạo ra một mô hình dự đoán tối ưu. Trong học máy hợp nhất, các dự đoán được tổng hợp lại để xác định kết quả phổ biến nhất.

Các phương pháp hợp nhất nổi tiếng bao gồm bagging và boosting, giúp ngăn ngừa overfitting vì mô hình hợp nhất được tạo ra từ việc tổng hợp nhiều mô hình.

Thêm lớp dropout

Các trọng số lớn trong mạng nơ-ron biểu thị một mạng lưới phức tạp hơn. Phương pháp loại bỏ nút ngẫu nhiên trong mạng là một cách đơn giản và hiệu quả để ngăn chặn overfitting. Trong regularization, một số đầu ra của lớp được bỏ qua ngẫu nhiên hoặc “dropout” để giảm độ phức tạp của mô hình.

Nếu bạn có hai mô hình với hiệu suất gần như tương đương, nhưng một mô hình phức tạp hơn mô hình kia, bạn nên chọn mô hình ít phức tạp hơn. Trong khoa học dữ liệu, có một quy tắc chung là bạn luôn bắt đầu với mô hình ít phức tạp và tăng độ phức tạp dần theo thời gian.

Với những kỹ thuật và phương pháp phòng ngừa overfitting đã được đề cập, bạn sẽ có cái nhìn rõ ràng hơn về cách tối ưu hóa mô hình học máy của mình. Việc hiểu và kiểm soát được vấn đề quá khớp sẽ giúp bạn xây dựng các mô hình không chỉ chính xác trên dữ liệu huấn luyện mà còn có khả năng tổng quát tốt trên dữ liệu mới.

Trong quá trình xây dựng và tối ưu mô hình học máy, việc kiểm soát overfitting đòi hỏi tài nguyên tính toán đáng kể, đặc biệt khi bạn cần thử nghiệm với nhiều mô hình, tinh chỉnh siêu tham số, hoặc thực hiện kiểm tra chéo (cross-validation). InterData mang đến giải pháp thuê VPS giá rẻ chất lượng cao nhưng vẫn đảm bảo hiệu năng vượt trội, giúp bạn tăng tốc quá trình phát triển mô hình học máy. Với phần cứng thế hệ mới, bao gồm CPU AMD EPYC mạnh mẽ và ổ cứng SSD NVMe U.2 siêu tốc, bạn có thể thoải mái huấn luyện các mô hình phức tạp mà không lo về giới hạn tài nguyên.

Chỉ từ 90.000 VNĐ/tháng, bạn đã sở hữu một VPS với cấu hình mạnh, băng thông lớn và tốc độ cao, đáp ứng mọi nhu cầu từ thử nghiệm đơn giản đến triển khai các dự án học máy quy mô lớn. Hơn nữa, InterData là nhà cung cấp uy tín, cam kết mang đến dịch vụ ổn định và chất lượng.

Hãy liên hệ với InterData ngay hôm nay để được tư vấn và trải nghiệm dịch vụ VPS vượt trội!

INTERDATA

- Website: Interdata.vn

- Hotline: 1900-636822

- Email: [email protected]

- VPĐD: 240 Nguyễn Đình Chính, P.11. Q. Phú Nhuận, TP. Hồ Chí Minh

- VPGD: Số 211 Đường số 5, KĐT Lakeview City, P. An Phú, TP. Thủ Đức, TP. Hồ Chí Minh