Ngày nay, Dataset là yếu tố không thể thiếu trong các lĩnh vực như Machine Learning, trí tuệ nhân tạo và phân tích dữ liệu. Dataset không chỉ đơn thuần là tập hợp thông tin mà còn là nguồn dữ liệu quan trọng giúp các thuật toán AI học hỏi, phân tích và đưa ra dự đoán chính xác. Vậy Dataset là gì, có những loại dataset nào quan trọng trong Machine Learning và Dataset được ứng dụng như thế nào? Hãy cùng tìm hiểu chi tiết trong bài viết này!

Dataset là gì?

Dataset, hay tập dữ liệu, là một tập hợp các dữ liệu được tổ chức theo một cấu trúc nhất định. Thông thường, dataset được trình bày dưới dạng bảng (tương tự như bảng cơ sở dữ liệu) hoặc ma trận. Mỗi cột trong bảng biểu diễn một thuộc tính (attribute) hoặc biến số (variable), còn mỗi hàng chứa thông tin về một đối tượng (object) hoặc mẫu (sample) cụ thể.

Trong các dự án Machine Learning (học máy), dataset đóng vai trò là dữ liệu đầu vào để huấn luyện mô hình. Đây là tập dữ liệu thực tế được sử dụng để “dạy” cho mô hình cách thực hiện các tác vụ khác nhau. Sự ra đời của dataset là một bước tiến quan trọng trong việc nghiên cứu và phát triển các phần mềm, hệ thống cơ sở dữ liệu đa nền tảng.

Tầm quan trọng của Dataset trong Machine Learning

Dữ liệu đóng vai trò cốt lõi trong machine learning. Trí tuệ nhân tạo (AI) không thể học nếu thiếu dữ liệu. Đây chính là yếu tố then chốt để việc huấn luyện thuật toán trở thành hiện thực. Dù cho đội ngũ AI có tài năng đến đâu, hay quy mô tập dữ liệu có lớn thế nào, dự án AI vẫn sẽ thất bại nếu chất lượng của tập dữ liệu không đủ tốt.

Trong suốt quá trình phát triển AI, dữ liệu luôn là nền tảng. Chúng ta sử dụng ba loại tập dữ liệu khác nhau cho các giai đoạn: huấn luyện (training set), kiểm định (validation set), và thử nghiệm (testing set). Trong đó, tập dữ liệu kiểm định (validation set) đóng vai trò quan trọng trong việc lựa chọn và tinh chỉnh mô hình machine learning cuối cùng.

Thu thập dữ liệu mới chỉ là bước khởi đầu. Thực tế, trong các dự án AI, phần lớn thời gian được dành cho việc phân loại và gắn nhãn dữ liệu, đặc biệt là để đảm bảo các tập dữ liệu này phản ánh chính xác thực tế thị trường hoặc thế giới. Điều này rất quan trọng.

Các loại Dataset được dùng trong Machine Learning

Trong Machine Learning, để xây dựng và đánh giá một mô hình, người ta thường chia dữ liệu thành ba tập con:

Bộ dữ liệu huấn luyện (Training Set)

Training set là tập dữ liệu được sử dụng để “dạy” cho mô hình (model) cách nhận biết và xử lý thông tin. Nó bao gồm cả dữ liệu đầu vào (input) và đầu ra (output) mong muốn, giúp thuật toán học được mối quan hệ giữa chúng.

Tập huấn luyện thường chiếm phần lớn dữ liệu, khoảng 60%. Trong quá trình huấn luyện, mô hình sẽ điều chỉnh các tham số (weights) của nó để khớp với dữ liệu trong training set.

Bộ dữ liệu xác thực (Validation Set)

Validation set được sử dụng để đánh giá và tinh chỉnh mô hình trong quá trình huấn luyện. Nó giúp theo dõi hiệu suất của mô hình và ngăn chặn hiện tượng quá khớp (overfitting) – khi mô hình học quá tốt trên tập huấn luyện nhưng lại kém hiệu quả trên dữ liệu mới.

Tập xác thực thường chiếm khoảng 20% dữ liệu. Dựa trên kết quả đánh giá trên validation set, người ta có thể điều chỉnh các siêu tham số (hyperparameters) của mô hình để cải thiện hiệu suất.

Bộ dữ liệu kiểm thử (Testing Set)

Testing set được sử dụng để đánh giá cuối cùng về hiệu suất của mô hình đã được huấn luyện và tinh chỉnh. Nó cung cấp một thước đo khách quan về khả năng tổng quát hóa (generalization) của mô hình trên dữ liệu mới, chưa từng thấy.

Tập kiểm thử thường chiếm khoảng 20% dữ liệu. Điều quan trọng là testing set phải hoàn toàn độc lập với training set và validation set để đảm bảo kết quả đánh giá là chính xác và không thiên vị. Nếu sử dụng training set để kiểm thử, mô hình có thể “học thuộc” dữ liệu và cho kết quả giả tạo.

Các nguồn Dataset dành cho Machine Learning

Các nguồn dataset dành cho học máy

Để phục vụ cho lĩnh vực học máy, có rất nhiều nguồn cung cấp tập dữ liệu (dataset). Dưới đây là một số nguồn dataset hàng đầu:

Kaggle

Kaggle là một thư viện dữ liệu trực tuyến thuộc top lớn nhất thế giới, được cập nhật liên tục mỗi ngày bởi cộng đồng những người thực hành và nghiên cứu trong lĩnh vực học máy và trí tuệ nhân tạo (AI).

Nhờ hoạt động dựa trên cộng đồng, Kaggle sở hữu một nền tảng machine learning đa dạng. Trên website này, người dùng có thể tìm thấy vô số hướng dẫn và hàng trăm bài toán thực tế về machine learning thuộc nhiều lĩnh vực khác nhau.

Điểm cần lưu ý là chất lượng của các tập dữ liệu trên Kaggle không đồng đều, do đó người dùng cần tự đánh giá.

Một ưu điểm lớn là tất cả dữ liệu trên Kaggle đều miễn phí và ai cũng có thể đóng góp tập dữ liệu của mình lên nền tảng này.

Papers With Code

Papers With Code là một nguồn tài nguyên giá trị, Papers With Code cung cấp các bài nghiên cứu về những xu hướng học máy mới nhất, đi kèm với mã code (code) để triển khai. Trang web này do Robert Stojnic, Giám đốc điều hành của Atlas ML, xây dựng.

Papers With Code cho phép người dùng dễ dàng so sánh các bài báo khoa học về máy học trên arXiv với mã code tương ứng trên GitHub, từ đó có cái nhìn đa chiều và trực quan hơn về nội dung.

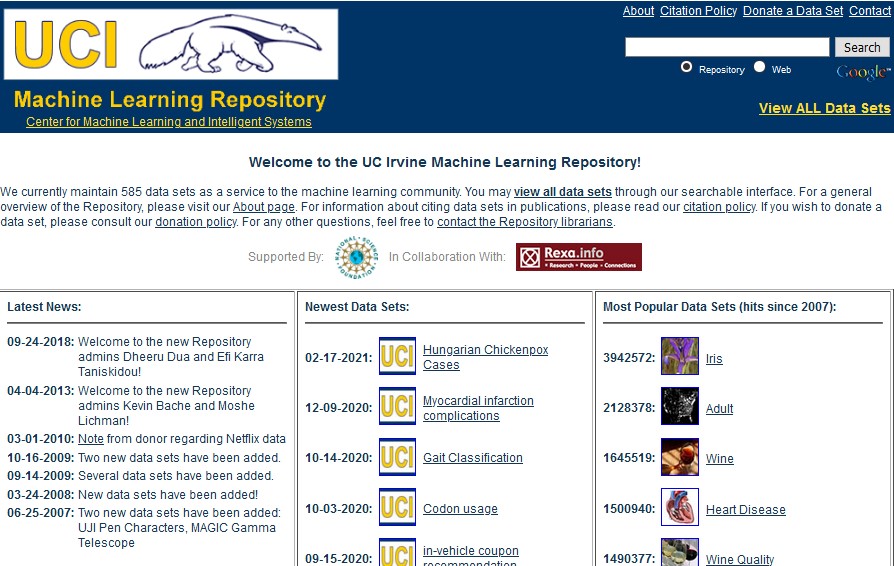

UCI Machine Learning Repository

Kho lưu trữ học máy UCI (UCI Machine Learning Repository) là một trong những nguồn tập dữ liệu có lịch sử lâu đời nhất trên internet. Đây thường là điểm đến đầu tiên và rất hữu ích cho những ai đang tìm kiếm các tập dữ liệu.

Vì các tập dữ liệu ở đây do nhiều người dùng đóng góp, nên mức độ “sạch” của chúng có thể khác nhau. Tuy nhiên, phần lớn các tập dữ liệu đều có chất lượng tốt. Người dùng có thể tải trực tiếp các tập dữ liệu từ kho UCI mà không cần tài khoản.

Registry of Open Data on AWS

Registry of Open Data on AWS (Số đăng ký dữ liệu mở trên AWS) là nơi mọi người có thể chia sẻ hoặc tìm kiếm các tập dữ liệu cần thiết. Với các công cụ hỗ trợ phân tích dữ liệu, người dùng có thể tiến hành nghiên cứu dựa trên những thông tin mà họ tìm thấy.

Google Dataset Search

Được Google ra mắt vào ngày 5/9/2018, Google Dataset Search Engine (Công cụ tìm kiếm các tập tin dữ liệu của Google) là một công cụ giúp các nhà nghiên cứu dễ dàng tìm thấy các tập dữ liệu trực tuyến miễn phí, có sẵn trên một nền tảng chung để sử dụng theo nhu cầu của họ.

Microsoft Datasets

Microsoft cung cấp một kho dữ liệu mở đa dạng, bao gồm nhiều lĩnh vực như xử lý ngôn ngữ tự nhiên (Natural Language Processing – NLP), thị giác máy tính (Computer Vision), và các ngành khoa học khác. Bạn có thể tải dữ liệu về máy hoặc sử dụng trực tiếp trên nền tảng đám mây của Microsoft.

Một dịch vụ khác của Microsoft là Azure Open Datasets, cung cấp các bộ dữ liệu được cập nhật thường xuyên, bao gồm dữ liệu từ Chính phủ Mỹ, dữ liệu thống kê, và dữ liệu dịch vụ trực tuyến của Microsoft.

Reddit Datasets

Subreddit datasets (và các subreddit liên quan khác) là nơi cộng đồng chia sẻ các bộ dữ liệu mã nguồn mở. Bạn có thể tìm kiếm dataset theo chủ đề hoặc đóng góp dataset của riêng mình. Tuy nhiên, cũng nên cẩn trọng về nguồn gốc và chất lượng của dataset.

CMU Libraries

Thư viện Đại học Carnegie Mellon (CMU) cung cấp một bộ sưu tập dữ liệu công khai, đặc biệt mạnh về các lĩnh vực văn hóa, âm nhạc và lịch sử Hoa Kỳ. Đây là nguồn tài nguyên quý giá cho các nhà nghiên cứu trong các lĩnh vực này.

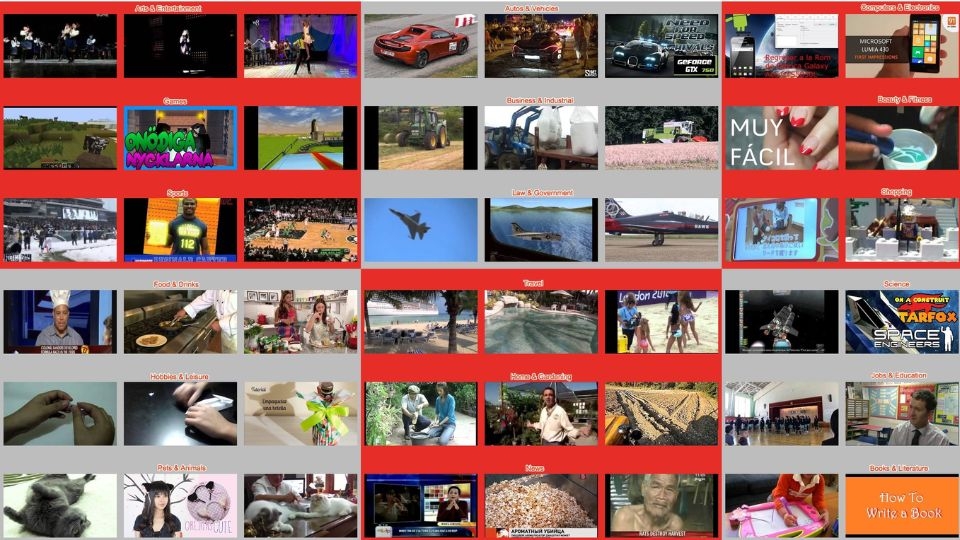

YouTube Dataset

YouTube cung cấp một tập dữ liệu video lớn (hơn 7 triệu video), được phân loại thành 24 chủ đề (ví dụ: giải trí, nghệ thuật, thể thao, trò chơi, nấu ăn…).

Dataset này được chia thành ba phần: tập huấn luyện (training set), tập xác thực (validation set), và tập kiểm tra (testing set), rất hữu ích cho các dự án Machine Learning liên quan đến video. Các video đã được gán nhãn, giúp cho việc huấn luyện, kiểm thử, đánh giá trở nên dễ dàng, thuận tiện.

Các thuộc tính quan trọng của Dataset

Các thuộc tính của tập dữ liệu là những yếu tố quan trọng giúp xác định cấu trúc của dữ liệu. Các thuộc tính này ảnh hưởng đến khả năng triển khai mô hình và dự đoán kết quả của các điểm dữ liệu mới được thêm vào tập dữ liệu.

Một số thuộc tính phổ biến của tập dữ liệu bao gồm:

- Thuộc tính số (Numerical Features): Gồm các giá trị số như chiều cao, cân nặng, điểm số, v.v. Chúng có thể là biến liên tục hoặc rời rạc.

- Thuộc tính phân loại (Categorical Features): Gồm nhiều danh mục như giới tính, màu sắc, loại sản phẩm, v.v.

- Siêu dữ liệu (Metadata): Cung cấp mô tả tổng quan về tập dữ liệu, giúp tiết kiệm thời gian và nâng cao hiệu quả khi dữ liệu được chuyển giao cho một nhà phát triển mới.

- Kích thước dữ liệu (Size of Data): Chỉ số lượng bản ghi và thuộc tính có trong tập dữ liệu.

- Định dạng dữ liệu (Formatting of Data): Các tập dữ liệu có thể được lưu trữ dưới nhiều định dạng khác nhau như JSON, CSV, XML, DataFrame hoặc Excel (.xlsx, .xlsm). Các tập dữ liệu lớn, đặc biệt là dữ liệu hình ảnh dùng trong nhận diện bệnh tật, thường được nén dưới dạng tập tin zip và cần giải nén để sử dụng.

- Biến mục tiêu (Target Variable): Đây là biến mà các giá trị hoặc thuộc tính của nó được sử dụng để dự đoán kết quả thông qua các thuật toán máy học.

- Dữ liệu đầu vào (Data Entries): Các giá trị dữ liệu cụ thể trong tập dữ liệu, đóng vai trò quan trọng trong quá trình phân tích dữ liệu.

Ứng dụng của Dataset hiện nay

Từ việc thúc đẩy trí tuệ nhân tạo (AI) đến hỗ trợ phân tích dữ liệu, tập dữ liệu (dataset) đóng vai trò nền tảng trong nhiều sáng kiến quan trọng về kinh doanh và công nghệ.

Một số ứng dụng phổ biến của tập dữ liệu bao gồm:

- Trí tuệ nhân tạo (AI) và máy học (ML)

- Phân tích dữ liệu và khai thác thông tin

- Trí tuệ doanh nghiệp (BI)

Trí tuệ nhân tạo (AI) và học máy (ML)

Trí tuệ nhân tạo (AI) đang trở thành yếu tố khác biệt quan trọng đối với nhiều tổ chức.

Theo Viện Giá trị Doanh nghiệp của IBM, 72% CEO hàng đầu tin rằng lợi thế cạnh tranh của họ phụ thuộc vào việc sở hữu các hệ thống AI tiên tiến nhất. Những hệ thống này hoạt động dựa trên các tập dữ liệu khổng lồ – cả có gán nhãn và không có gán nhãn để huấn luyện mô hình hiệu quả.

Với dữ liệu huấn luyện toàn diện, doanh nghiệp có thể phát triển các hệ thống AI có khả năng thực hiện những nhiệm vụ phức tạp như:

- Xử lý ngôn ngữ tự nhiên (NLP): Các mô hình NLP sử dụng tập dữ liệu ngôn ngữ tiếng Anh và đa ngôn ngữ để hiểu ngôn ngữ con người và hỗ trợ các ứng dụng như mô hình ngôn ngữ lớn (LLMs), chatbot, dịch thuật và phân tích văn bản. Ví dụ, một chatbot chăm sóc khách hàng có thể sử dụng NLP để phân tích các tập dữ liệu cuộc hội thoại hỗ trợ trước đây nhằm học cách trả lời các câu hỏi phổ biến.

- Thị giác máy tính (Computer Vision): AI có thể học cách nhận diện đối tượng, khuôn mặt và mẫu hình trực quan thông qua các tập dữ liệu hình ảnh có gán nhãn. Thị giác máy tính thúc đẩy các cải tiến trong xe tự hành, phân tích hình ảnh y tế và nhiều lĩnh vực khác. Ví dụ, hệ thống AI trong y tế có thể phân tích tập dữ liệu chụp X-quang để phát hiện sớm dấu hiệu bệnh với độ chính xác cao.

- Phân tích dự đoán (Predictive Analytics): Các mô hình dự đoán dựa trên tập dữ liệu có cấu trúc để dự báo các kết quả trong thế giới thực, như giá nhà ở hoặc nhu cầu tiêu dùng. Các mô hình hồi quy sử dụng dữ liệu lịch sử để đưa ra dự đoán chính xác, chẳng hạn như phân tích dữ liệu bán hàng qua nhiều năm để dự báo nhu cầu theo mùa và tối ưu hóa mức tồn kho.

- Nghiên cứu (Research): AI có thể xử lý khối lượng lớn tập dữ liệu nghiên cứu để tìm ra những hiểu biết mới và đẩy nhanh quá trình đổi mới. Ví dụ, các công ty dược phẩm có thể sử dụng AI để phân tích tập dữ liệu phân tử nhằm xác định các ứng viên thuốc tiềm năng nhanh hơn so với phương pháp truyền thống.

Phân tích dữ liệu và khai thác thông tin

Các nhà khoa học dữ liệu và chuyên gia phân tích sử dụng tập dữ liệu để trích xuất thông tin giá trị và thúc đẩy phát hiện trong nhiều lĩnh vực. Khi doanh nghiệp thu thập dữ liệu ngày càng nhiều, việc phân tích dữ liệu trở thành yếu tố quan trọng để kiểm chứng giả thuyết, xác định xu hướng và phát hiện mối quan hệ nhằm hỗ trợ các quyết định chiến lược.

Một số cách phổ biến mà tập dữ liệu hỗ trợ phân tích dữ liệu bao gồm:

- Nhận diện mẫu (Pattern Recognition): Phân tích nâng cao các tập dữ liệu lớn có thể giúp phát hiện xu hướng ẩn, mối tương quan và các điểm bất thường, giúp doanh nghiệp nhận diện cơ hội và giảm thiểu rủi ro. Ví dụ, các công ty bán lẻ có thể phân tích dữ liệu giao dịch để phát hiện xu hướng mua sắm trong mùa lễ hội.

- Trực quan hóa dữ liệu (Data Visualization): Các công cụ trực quan hóa giúp biến các tập dữ liệu phức tạp thành thông tin rõ ràng và có thể hành động bằng cách sử dụng biểu đồ, đồ thị và bảng điều khiển (dashboard). Ví dụ, một công ty có thể sử dụng bảng điều khiển tương tác để hiển thị xu hướng doanh số và doanh thu, giúp các lãnh đạo nhanh chóng nắm bắt hiệu suất kinh doanh và đưa ra quyết định chính xác.

- Phân tích thống kê (Statistical Analysis): Bằng cách sử dụng các phương pháp thống kê chặt chẽ, các nhà khoa học dữ liệu có thể biến dữ liệu thô thành thông tin định lượng để đo lường mức độ quan trọng và kiểm chứng kết quả. Ví dụ, các nhà phân tích tài chính có thể tính toán các chỉ số quan trọng từ tập dữ liệu để đánh giá hiệu suất thị trường.

- Kiểm định giả thuyết (Hypothesis Testing): Các nhà khoa học dữ liệu có thể sử dụng tập dữ liệu thử nghiệm để kiểm chứng lý thuyết và đánh giá các giải pháp tiềm năng, cung cấp bằng chứng hỗ trợ cho các quyết định kinh doanh và nghiên cứu. Ví dụ, một công ty dược phẩm có thể phân tích tập dữ liệu thử nghiệm lâm sàng để đánh giá hiệu quả của một loại thuốc mới.

Trí tuệ doanh nghiệp (BI)

Các tổ chức sử dụng trí tuệ doanh nghiệp (BI) để khám phá thông tin từ tập dữ liệu và hỗ trợ ra quyết định theo thời gian thực.

Các công cụ BI có thể phân tích nhiều loại dữ liệu khác nhau để xác định xu hướng, theo dõi hiệu suất và phát hiện cơ hội kinh doanh. Một số ứng dụng phổ biến của BI bao gồm:

- Giám sát theo thời gian thực (Real-time Monitoring): Với tập dữ liệu về chỉ số hiệu suất chính (KPIs), doanh nghiệp có thể theo dõi liên tục hiệu suất hoạt động và hệ thống. Ví dụ, các công ty logistics sử dụng giám sát thời gian thực trong mùa cao điểm để theo dõi thời gian giao hàng và nhanh chóng xử lý các tình huống trì hoãn.

- Phân tích hành vi khách hàng (Customer Behavior Analysis): Tập dữ liệu giao dịch và tương tác có thể giúp khám phá xu hướng mua sắm và sở thích của khách hàng. Doanh nghiệp có thể sử dụng những thông tin này để phát triển chiến lược marketing phù hợp và cải thiện trải nghiệm khách hàng.

- Phân tích chuỗi thời gian (Time Series Analysis): Nhờ các tập dữ liệu lịch sử và tuần tự, doanh nghiệp có thể theo dõi xu hướng và mẫu hình theo thời gian. Ví dụ, các nhà cung cấp năng lượng có thể phân tích dữ liệu chuỗi thời gian để dự báo nhu cầu điện vào giờ cao điểm, giúp tối ưu hóa lưới điện và cải thiện dịch vụ khách hàng.

- Tối ưu hóa chuỗi cung ứng (Supply Chain Optimization): Các tập dữ liệu tích hợp giúp doanh nghiệp cải thiện quản lý logistics và nhà cung cấp. Ví dụ, các nhà bán lẻ có thể phân tích mức tồn kho, dữ liệu vận chuyển và hiệu suất nhà cung cấp để tối ưu hóa kế hoạch nhập hàng và giảm chi phí vận chuyển.

Dataset đóng vai trò quan trọng trong nhiều lĩnh vực, từ trí tuệ nhân tạo, phân tích dữ liệu, đến trí tuệ doanh nghiệp. Khi được khai thác đúng cách, tập dữ liệu giúp doanh nghiệp đưa ra quyết định chính xác, tối ưu hóa vận hành và phát triển các sản phẩm, dịch vụ tốt hơn. Việc hiểu rõ cách sử dụng tập dữ liệu hiệu quả sẽ mang lại lợi thế cạnh tranh đáng kể trong thế giới kinh doanh và công nghệ hiện đại.

Việc hiểu rõ Dataset là gì, biết được các loại dataset và ứng dụng thực tế của Dataset thông qua bài viết của InterData có thể giúp doanh nghiệp khai thác tối đa giá trị dữ liệu, cải thiện hiệu suất hoạt động và tạo ra những giải pháp đột phá. Nếu biết cách thu thập, xử lý và sử dụng dataset đúng cách, bạn có thể tối ưu hóa hệ thống AI, cải thiện chiến lược kinh doanh và tận dụng sức mạnh của dữ liệu để đạt lợi thế cạnh tranh bền vững.

INTERDATA

- Website: Interdata.vn

- Hotline: 1900-636822

- Email: [email protected]

- VPĐD: 240 Nguyễn Đình Chính, P.11. Q. Phú Nhuận, TP. Hồ Chí Minh

- VPGD: Số 211 Đường số 5, KĐT Lakeview City, P. An Phú, TP. Thủ Đức, TP. Hồ Chí Minh