Làm thế nào để tăng tính ổn định cho các mô hình học máy của bạn? Bagging, viết tắt của Bootstrap Aggregating, là một kỹ thuật Ensemble Learning mạnh mẽ được thiết kế chính cho mục đích này. Bằng cách tạo ra nhiều tập dữ liệu huấn luyện con và tổng hợp kết quả dự đoán, Bagging giúp cải thiện hiệu suất đáng kể.

Bài viết này sẽ đi sâu giải thích Bagging là gì, cách thức hoạt động chi tiết, lợi ích và thách thức chính, cùng những ứng dụng thực tế phổ biến của kỹ thuật Bagging. Đọc ngay nhé!

Bagging là gì?

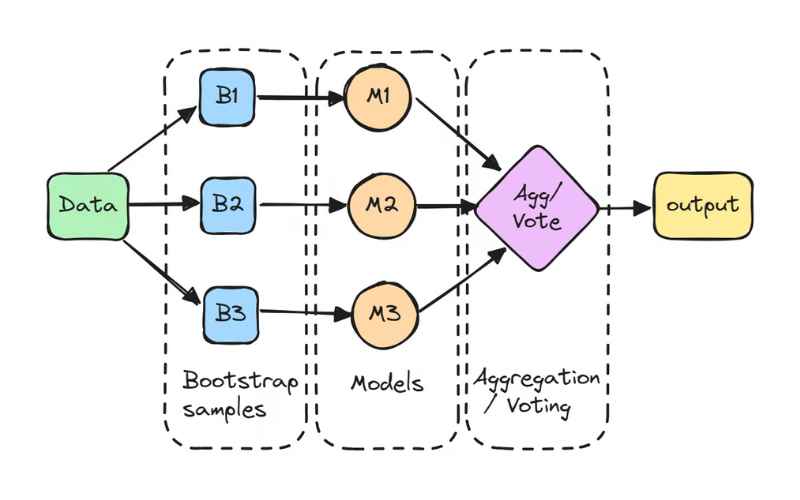

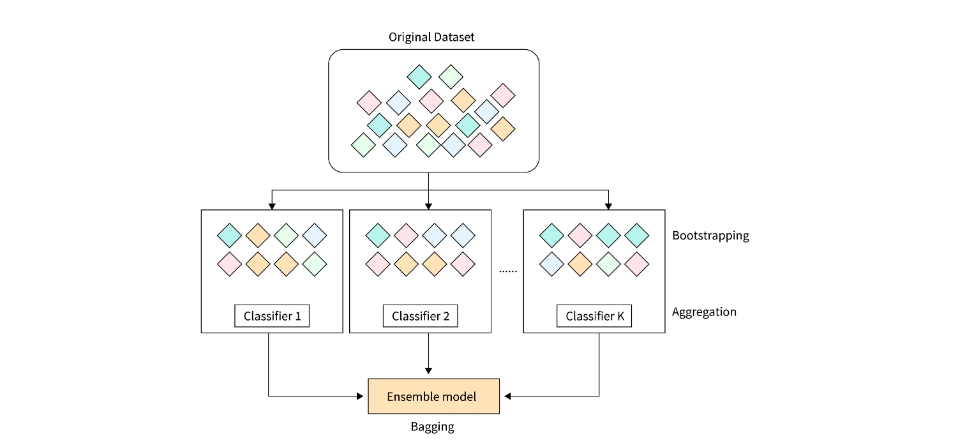

Bagging (viết tắt của Bootstrap Aggregating) là một chiến lược tổ hợp trong học máy, nhằm nâng cao độ tin cậy và độ chính xác của các mô hình dự đoán. Phương pháp này bao gồm việc tạo ra nhiều tập con từ dữ liệu huấn luyện thông qua lấy mẫu ngẫu nhiên có hoàn lại (random sampling with replacement).

Các tập con này sau đó được dùng để huấn luyện nhiều mô hình cơ sở (base learners), chẳng hạn như cây quyết định (decision tree), mạng nơ-ron (neural network), hoặc các mô hình khác.

Trong quá trình dự đoán, kết quả từ các mô hình cơ sở được kết hợp lại – thường là trung bình hóa (với các bài toán hồi quy) hoặc bỏ phiếu đa số (với các bài toán phân loại) – để tạo ra dự đoán cuối cùng.

Bagging giúp giảm thiểu hiện tượng quá khớp (overfitting) bằng cách tạo ra sự đa dạng giữa các mô hình và cải thiện hiệu suất tổng thể thông qua việc giảm phương sai và tăng độ ổn định của hệ thống.

Cách hoạt động của Bagging

Để triển khai bagging, bạn cần thực hiện các bước sau:

- Chuẩn bị dữ liệu: Làm sạch và tiền xử lý dữ liệu. Sau đó chia dữ liệu thành tập huấn luyện và tập kiểm tra (test).

- Lấy mẫu Bootstrap: Thực hiện lấy mẫu ngẫu nhiên có hoàn lại từ tập huấn luyện để tạo ra nhiều tập mẫu bootstrap. Mỗi tập mẫu nên có kích thước bằng tập dữ liệu gốc, nhưng các điểm dữ liệu có thể bị lặp lại hoặc bị loại bỏ.

- Huấn luyện mô hình: Huấn luyện một mô hình cơ sở (ví dụ: cây quyết định, mạng nơ-ron,…) trên mỗi tập mẫu bootstrap. Mỗi mô hình được huấn luyện độc lập với các mô hình còn lại.

- Tạo dự đoán: Sử dụng từng mô hình đã huấn luyện để dự đoán trên tập kiểm tra.

- Kết hợp dự đoán: Kết hợp các dự đoán từ tất cả mô hình. Đối với bài toán phân loại, sử dụng bỏ phiếu đa số; còn với bài toán hồi quy, sử dụng trung bình dự đoán.

- Đánh giá hiệu suất: Đánh giá hiệu quả của mô hình tổ hợp trên tập kiểm tra bằng các chỉ số phù hợp như độ chính xác (accuracy), điểm F1 (F1 score), sai số bình phương trung bình (mean squared error),…

- Tinh chỉnh siêu tham số (hyperparameter tuning): Nếu cần, hãy tinh chỉnh siêu tham số của từng mô hình cơ sở hoặc của toàn bộ hệ thống bagging bằng cách sử dụng các kỹ thuật như cross-validation.

- Triển khai mô hình: Khi mô hình tổ hợp đạt hiệu suất mong muốn, bạn có thể triển khai để dự đoán trên các dữ liệu mới.

Lợi ích nổi bật của Bagging trong học máy

Bagging mang lại nhiều lợi ích trong học máy, tiêu biểu như:

- Giảm phương sai (variance): Bagging huấn luyện nhiều mô hình cơ sở trên các tập dữ liệu khác nhau, nhờ đó tạo ra sự đa dạng giữa các mô hình. Khi kết hợp lại, sai số giữa các mô hình có thể triệt tiêu lẫn nhau, giúp dự đoán trở nên ổn định và đáng tin cậy hơn.

- Hạn chế quá khớp: Do các mô hình được huấn luyện trên những phiên bản dữ liệu khác nhau, chúng tập trung vào những khía cạnh khác nhau của dữ liệu. Điều này giúp hệ thống tổ hợp khái quát hóa tốt hơn trên dữ liệu mới.

- Kháng nhiễu và giá trị ngoại lệ: Nhờ huấn luyện trên nhiều tập con khác nhau, hệ thống tổ hợp ít bị ảnh hưởng bởi dữ liệu nhiễu và các điểm ngoại lệ.

- Có thể huấn luyện song song: Các mô hình trong bagging được huấn luyện độc lập, do đó có thể thực hiện huấn luyện song song. Điều này giúp tiết kiệm thời gian khi xử lý các tập dữ liệu lớn hoặc mô hình phức tạp.

- Linh hoạt: Bagging có thể áp dụng cho nhiều loại mô hình như cây quyết định, mạng nơ-ron, máy vector hỗ trợ (SVM),… Điều này cho phép người dùng tận dụng ưu điểm của các thuật toán khác nhau trong một hệ thống tổ hợp.

- Dễ triển khai: So với các kỹ thuật tổ hợp khác như boosting hay stacking, bagging dễ hiểu và dễ thực hiện hơn. Ý tưởng cơ bản là lấy mẫu ngẫu nhiên có hoàn lại và kết hợp dự đoán – rất trực quan và thân thiện với người mới bắt đầu.

Những thách thức chính của Bagging

Bagging (Bootstrap Aggregating) tuy mang lại nhiều lợi ích, nhưng cũng đi kèm một số thách thức đáng chú ý. Dưới đây, cùng InterData tìm hiểu xem những hạn chế của Bagging là gì.

- Mất tính diễn giải: Do kết quả dự đoán là trung bình từ nhiều mô hình nên việc rút ra các hiểu biết chi tiết cho mục đích kinh doanh trở nên khó khăn hơn. Mặc dù đầu ra có độ chính xác cao hơn so với một mô hình đơn lẻ, nhưng một tập dữ liệu đầy đủ và chính xác hơn đôi khi có thể mang lại kết quả chi tiết hơn trong một mô hình phân loại hoặc hồi quy cụ thể.

- Tốn nhiều tài nguyên tính toán: Khi số lượng mô hình tăng lên, thời gian xử lý sẽ chậm lại và yêu cầu tính toán tăng cao. Vì vậy, bagging không phù hợp với các ứng dụng yêu cầu phản hồi thời gian thực. Các hệ thống tính toán phân tán hoặc các cụm máy chủ với nhiều lõi xử lý là lựa chọn lý tưởng để triển khai bagging trên các tập dữ liệu lớn.

- Ít linh hoạt hơn: Bagging phát huy hiệu quả tốt nhất với các thuật toán không ổn định. Với các mô hình ổn định hoặc có xu hướng sai lệch cao (bias), bagging thường không mang lại nhiều cải thiện vì các mô hình này ít tạo ra sự khác biệt giữa các tập dữ liệu. Như được đề cập trong Hands-On Guide to Machine Learning, sử dụng bagging với mô hình hồi quy tuyến tính thường chỉ trả lại các dự đoán gốc nếu kích thước tập dữ liệu đủ lớn.

So sánh giữa Bagging và Boosting

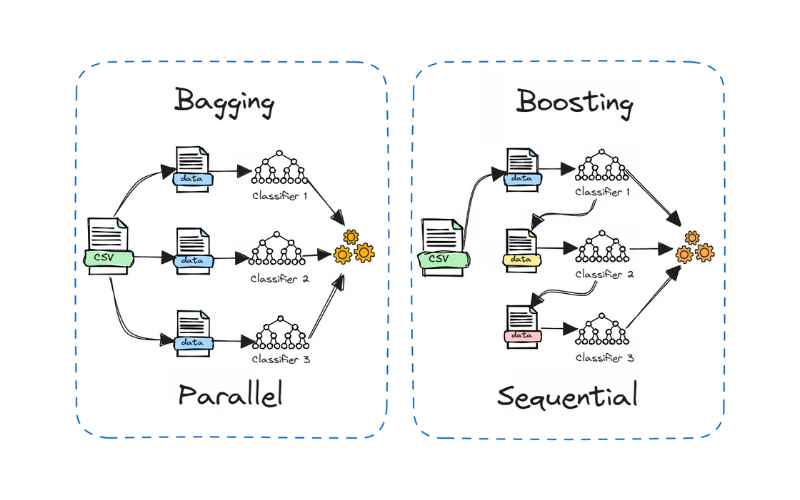

Boosting là một phương pháp tổ hợp phổ biến khác, thường được so sánh với Bagging. Sự khác biệt chính nằm ở cách huấn luyện các mô hình thành phần.

- Trong Bagging, các mô hình được huấn luyện độc lập và song song trên các tập dữ liệu ngẫu nhiên khác nhau.

- Trong Boosting, các mô hình được huấn luyện tuần tự, mỗi mô hình học từ những sai sót của mô hình trước đó.

Ngoài ra:

- Bagging thường kết hợp dự đoán thông qua trung bình hóa hoặc bỏ phiếu, trong khi Boosting gán trọng số cho các mô hình dựa trên độ chính xác.

- Bagging giảm phương sai, còn Boosting giảm sai lệch (bias).

- Bagging phù hợp với các mô hình không ổn định (như cây quyết định), trong khi Boosting hoạt động hiệu quả hơn với các mô hình ổn định (như hồi quy tuyến tính).

Cả hai phương pháp đều có điểm mạnh và điểm yếu riêng. Bagging dễ triển khai song song, còn Boosting thường cho kết quả mạnh mẽ và chính xác hơn. Trong thực tế, nên thử cả hai cách tiếp cận để đánh giá phương pháp nào phù hợp nhất với bài toán cụ thể.

Ứng dụng thực tế của Bagging

Bagging được ứng dụng rộng rãi trong nhiều ngành công nghiệp, không chỉ mang lại giá trị thực tiễn mà còn mở ra những góc nhìn thú vị. Một số ứng dụng tiêu biểu gồm:

- Y tế: Bagging được sử dụng để xây dựng các mô hình dự đoán trong lĩnh vực y khoa. Các nghiên cứu cho thấy phương pháp tổ hợp đã được áp dụng cho nhiều bài toán trong sinh tin học (bioinformatics), như chọn lọc gen hoặc protein để xác định một đặc điểm sinh học cụ thể. Cụ thể hơn, bagging được sử dụng để dự đoán khả năng khởi phát bệnh tiểu đường dựa trên các yếu tố nguy cơ.

- Công nghệ thông tin: Bagging giúp cải thiện độ chính xác trong các hệ thống CNTT, chẳng hạn như hệ thống phát hiện xâm nhập mạng (network intrusion detection). Một số nghiên cứu chỉ ra rằng bagging không chỉ nâng cao độ chính xác mà còn giúp giảm tỷ lệ báo động sai (false positives) trong các hệ thống này.

- Môi trường: Trong lĩnh vực viễn thám, các phương pháp tổ hợp như bagging được sử dụng để phân tích và lập bản đồ các loại đất ngập nước trong cảnh quan ven biển – giúp nâng cao độ chính xác trong phân loại.

- Tài chính: Bagging được tích hợp vào các mô hình học sâu trong ngành tài chính để tự động hóa các tác vụ quan trọng như phát hiện gian lận, đánh giá rủi ro tín dụng và định giá quyền chọn. Một số nghiên cứu đã chứng minh bagging, cùng với các kỹ thuật học máy khác, hỗ trợ hiệu quả trong việc đánh giá rủi ro vỡ nợ. Bên cạnh đó, bagging còn giúp giảm thiểu rủi ro bằng cách ngăn chặn gian lận thẻ tín dụng trong các tổ chức tài chính và ngân hàng.

- Phân loại và hồi quy: Bagging được sử dụng rộng rãi trong các bài toán phân loại và hồi quy. Trong phân loại, bagging giúp tăng độ chính xác bằng cách kết hợp đầu ra từ nhiều mô hình được huấn luyện trên các tập dữ liệu khác nhau. Với bài toán hồi quy, bagging giúp tăng độ ổn định và độ chính xác bằng cách trung bình hóa dự đoán từ nhiều mô hình.

- Phát hiện bất thường (anomaly detection): Bagging có thể được dùng để phát hiện các điểm bất thường trong dữ liệu bằng cách huấn luyện nhiều mô hình trên các tập dữ liệu con khác nhau. Phương pháp này làm tăng khả năng phát hiện chính xác và khả năng chống nhiễu, đồng thời hạn chế ảnh hưởng của các giá trị ngoại lệ.

- Lựa chọn đặc trưng (feature selection): Ngoài việc cải thiện độ chính xác, bagging còn hỗ trợ hiệu quả trong việc lựa chọn đặc trưng phù hợp cho mô hình. Bằng cách huấn luyện nhiều mô hình trên các tập đặc trưng khác nhau và đánh giá hiệu suất, bagging giúp xác định các đặc trưng quan trọng nhất, đồng thời giảm nguy cơ quá khớp.

- Dữ liệu mất cân bằng: Khi dữ liệu huấn luyện có sự mất cân bằng giữa các lớp (ví dụ: số lượng mẫu của một lớp quá ít), bagging giúp cân bằng tỷ lệ lớp trong từng tập con, từ đó cải thiện độ chính xác trong việc dự đoán lớp thiểu số.

- Tổ hợp học (Ensemble Learning): Bagging là thành phần cốt lõi của nhiều kỹ thuật tổ hợp phức tạp như Random Forest và Stacking. Trong Random Forest, bagging được dùng để huấn luyện nhiều cây quyết định. Trong Stacking, bagging tạo ra các tập dữ liệu đa dạng để huấn luyện nhiều mô hình cơ sở.

- Dự báo chuỗi thời gian (Time-series forecasting): Bagging có thể được ứng dụng trong các bài toán dự báo chuỗi thời gian nhằm cải thiện độ chính xác và ổn định. Bằng cách huấn luyện nhiều mô hình dự báo trên các tập dữ liệu lịch sử khác nhau, bagging giúp nắm bắt được nhiều xu hướng và mẫu biến động trong dữ liệu.

- Phân cụm (Clustering): Bagging cũng có thể được dùng trong các bài toán phân cụm, với mục tiêu nhóm các điểm dữ liệu tương đồng. Bằng cách huấn luyện nhiều mô hình phân cụm trên các tập con khác nhau, bagging giúp xác định các cụm ổn định và đáng tin cậy hơn, đặc biệt là trong dữ liệu có nhiễu hoặc có số chiều lớn.

Qua bài viết, hy vọng bạn đã nắm vững Bagging là gì và vai trò quan trọng của nó trong việc cải thiện hiệu suất mô hình học máy. Với những lợi ích nổi bật về tính ổn định, các thách thức cần lưu ý và các ứng dụng thực tế đa dạng càng khẳng định giá trị của Bagging.

Việc hiểu và áp dụng thành thạo Bagging chắc chắn sẽ giúp bạn xây dựng được những hệ thống dự đoán mạnh mẽ và đáng tin cậy hơn.

Trong quá trình triển khai các mô hình học máy như Bagging, đặc biệt khi làm việc với tập dữ liệu lớn hoặc cần huấn luyện nhiều mô hình song song, hạ tầng tính toán mạnh mẽ là yếu tố không thể thiếu. Dịch vụ thuê VPS giá rẻ chất lượng tại InterData đáp ứng nhu cầu này với cấu hình mạnh mẽ từ CPU AMD EPYC hoặc Intel Xeon Platinum, ổ cứng SSD NVMe U.2 tốc độ cao, băng thông lớn và dung lượng tối ưu, giúp xử lý mô hình hiệu quả và tiết kiệm chi phí.

Nếu bạn đang cần một giải pháp tính toán ổn định, hiệu năng cao để chạy các tác vụ AI phức tạp, mô hình học sâu hoặc xử lý dữ liệu chuyên sâu, thì dịch vụ thuê Cloud Server tốc độ cao giá rẻ tại InterData là lựa chọn đáng cân nhắc. Với hạ tầng phần cứng thế hệ mới, khả năng mở rộng linh hoạt, độ ổn định cao và mức giá hợp lý, đây là nền tảng phù hợp để triển khai các ứng dụng học máy chuyên nghiệp.

INTERDATA

- Website: Interdata.vn

- Hotline: 1900-636822

- Email: [email protected]

- VPĐD: 240 Nguyễn Đình Chính, P.11. Q. Phú Nhuận, TP. Hồ Chí Minh

- VPGD: Số 211 Đường số 5, KĐT Lakeview City, P. An Phú, TP. Thủ Đức, TP. Hồ Chí Minh