Adam Optimizer (Adaptive Moment Estimation) là một thuật toán tối ưu hóa phổ biến trong học máy, đặc biệt là trong học sâu, nhờ vào khả năng cải thiện tốc độ hội tụ và tối ưu hóa mô hình nhanh chóng. Bài viết này sẽ giúp bạn có cái nhìn tổng quan về Adam Optimizer là gì trong học sâu, cách thức hoạt động của nó, lợi ích, thách thức khi sử dụng và những ứng dụng thực tế trong các lĩnh vực hiện đại. Tìm hiểu ngay!

Adam Optimizer là gì?

Adam, viết tắt của Adaptive Moment Estimation, là một thuật toán tối ưu hóa phổ biến được sử dụng trong học máy và đặc biệt là trong học sâu. Adam kết hợp các ý tưởng chính từ hai kỹ thuật tối ưu mạnh mẽ khác là momentum và RMSprop. Thuật toán này được gọi là “thích ứng” vì nó điều chỉnh tỷ lệ học cho mỗi tham số.

Adam giúp mô hình học hiệu quả hơn bằng cách điều chỉnh liên tục tỷ lệ học của từng tham số và do đó, nó hội tụ nhanh hơn rất nhiều so với gradient descent ngẫu nhiên tiêu chuẩn. Vì vậy, trong nhiều ứng dụng học sâu, tối ưu hóa Adam thường là lựa chọn mặc định mạnh mẽ.

Cách thức hoạt động của Adam Optimizer

Adam optimizer giống như một trợ lý thông minh trong việc huấn luyện mạng nơ-ron. Nó giúp điều chỉnh các thiết lập (tham số) của mạng để mạng làm việc hiệu quả hơn, như nhận dạng hình ảnh hoặc hiểu văn bản.

Dưới đây là các bước hoạt động của Adam Optimizer:

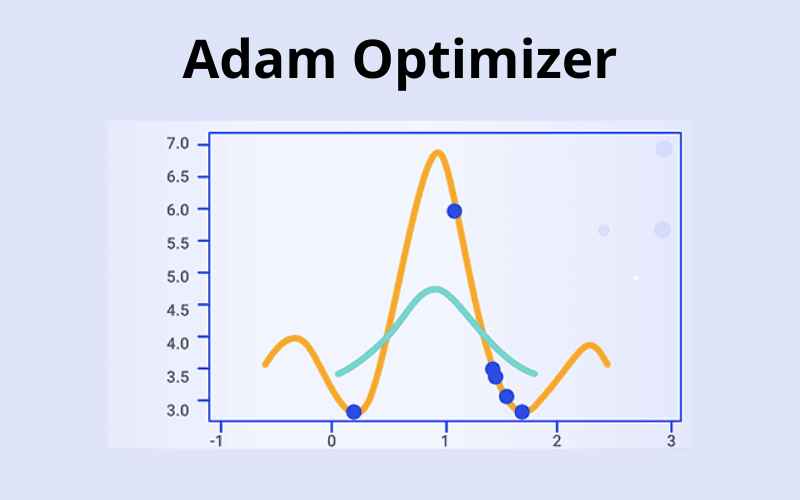

- Bắt đầu: Đầu tiên, Adam thiết lập hai giá trị để theo dõi quá trình huấn luyện của mạng. Một giá trị để theo dõi trung bình độ dốc (moment đầu tiên) khi mạng đang cố gắng cải thiện. Giá trị còn lại là trung bình tốc độ thay đổi độ dốc (moment thứ hai). Cả hai giá trị này đều bắt đầu từ số không.

- Nhìn vào độ dốc: Trong quá trình huấn luyện, Adam kiểm tra độ dốc bằng cách nhìn vào sự khác biệt giữa dự đoán của mạng và các kết quả đúng.

- Cập nhật Moment đầu tiên: Adam tính toán trung bình độ dốc theo thời gian. Điều này giống như việc ghi nhớ độ dốc của dốc núi trong quá khứ.

- Cập nhật Moment thứ hai: Adam cũng tính toán trung bình tốc độ thay đổi của độ dốc theo thời gian. Điều này giúp hiểu xem độ dốc có trở nên dốc hơn hay nhẹ nhàng hơn.

- Sửa lỗi thiên vị: Vì các giá trị trung bình bắt đầu từ số không, chúng có thể không chính xác ngay từ đầu. Vì vậy, Adam thực hiện một số điều chỉnh để làm chúng chính xác hơn.

- Điều chỉnh các tham số: Cuối cùng, Adam sử dụng các giá trị trung bình này để điều chỉnh một chút các tham số của mạng. Đây giống như việc nhẹ nhàng đẩy mạng về phía đúng để cải thiện hiệu suất.

Bằng cách làm tất cả những điều trên, tối ưu hóa Adam giúp mạng nơ-ron học hiệu quả hơn và nhanh chóng. Nó giống như có một huấn luyện viên giỏi, người hướng dẫn mạng trở nên tốt hơn trong công việc của mình.

Các tính năng chính của Adam Optimizer

Tỷ lệ học thích ứng (Adaptive Learning Rates)

Thuật toán Adam điều chỉnh tỷ lệ học cho từng tham số một cách riêng biệt. Nó tính toán trung bình động của moment đầu tiên (gradient trung bình) và moment thứ hai (phương sai không căn trung của gradient) để điều chỉnh tỷ lệ học một cách thích ứng. Điều này giúp Adam phù hợp với các bài toán có gradient thưa thớt hoặc dữ liệu nhiễu.

Sửa lỗi thiên vị (Bias Correction)

Để khắc phục thiên vị khởi tạo trong các moment đầu, Adam áp dụng phương pháp sửa lỗi trong giai đoạn huấn luyện đầu tiên. Điều này giúp quá trình hội tụ nhanh hơn và làm ổn định quá trình huấn luyện.

Yêu cầu bộ nhớ thấp (ow Memory Requirements)

Khác với một số thuật toán tối ưu khác yêu cầu lưu trữ toàn bộ lịch sử gradient cho mỗi tham số, Adam chỉ cần duy trì hai trung bình động cho mỗi tham số. Điều này giúp Adam tiết kiệm bộ nhớ, đặc biệt với các mạng nơ-ron lớn.

Lợi ích của nổi bật Adam Optimizer là gì?

Thuật toán Adam mang lại nhiều ưu điểm so với các thuật toán tối ưu hóa khác:

- Tỷ lệ học thích ứng: Adam điều chỉnh tỷ lệ học cho mỗi tham số dựa trên các moment đầu tiên và thứ hai của gradient. Điều này giúp nó tự động điều chỉnh kích thước bước cho mỗi tham số, làm cho Adam phù hợp với dữ liệu thưa thớt và nhiễu.

- Hội tụ nhanh hơn: Adam kết hợp các lợi ích của các thuật toán Adagrad và RMSprop bằng cách sử dụng tỷ lệ học thích ứng và động lượng. Điều này thường dẫn đến hội tụ nhanh hơn và hiệu suất tốt hơn so với các thuật toán tối ưu hóa khác.

- Chống lại sự nhạy cảm với siêu tham số: Thuật toán Adam ít nhạy cảm hơn khi sử dụng các siêu tham số như tỷ lệ học và động lượng, giúp dễ dàng áp dụng cho các loại dữ liệu và kiến trúc khác nhau.

- Phù hợp với bộ dữ liệu lớn: Adam rất phù hợp với các bộ dữ liệu lớn và không gian tham số có chiều cao, vì nó tính toán và lưu trữ hiệu quả các moment đầu tiên và thứ hai của gradient.

- Sử dụng rộng rãi và hỗ trợ: Adam là thuật toán tối ưu hóa phổ biến, được sử dụng rộng rãi và duy trì trong các framework học sâu nổi tiếng như TensorFlow và PyTorch.

Nhìn chung, Adam là một thuật toán tối ưu mạnh mẽ với nhiều ưu điểm so với các thuật toán tối ưu khác, khiến nó trở thành lựa chọn phổ biến trong các ứng dụng học sâu. Tuy nhiên, việc điều chỉnh cẩn thận các siêu tham số và theo dõi quá trình huấn luyện là rất quan trọng để đạt được kết quả tốt nhất.

Thách thức cần lưu ý của Adam Optimizer là gì?

Mặc dù tối ưu hóa Adam có nhiều lợi ích đáng kể, nhưng cũng có một số thách thức cần lưu ý:

- Yêu cầu bộ nhớ: Adam yêu cầu lưu trữ các moment đầu tiên và thứ hai của gradient cho mỗi tham số, điều này có thể tốn bộ nhớ cho các mô hình lớn với nhiều tham số.

- Nhạy cảm với nhiễu: Tỷ lệ học thích ứng của Adam có thể khiến nó nhạy cảm với nhiễu trong ước tính gradient, đặc biệt là đối với dữ liệu thưa thớt. Điều này có thể dẫn đến hội tụ không tối ưu hoặc thậm chí phân kỳ trong một số trường hợp.

- Ước tính thiên lệch: Các ước tính moment đầu tiên và thứ hai của Adam có xu hướng thiên lệch về phía không, đặc biệt trong giai đoạn đầu của quá trình huấn luyện. Điều này có thể ảnh hưởng đến quá trình hội tụ và có thể yêu cầu thêm nhiều vòng lặp để đạt được giải pháp tối ưu.

- Nhạy cảm với siêu tham số: Mặc dù Adam ít nhạy cảm với sự chọn lựa siêu tham số so với các thuật toán tối ưu khác, nhưng nó vẫn cần phải điều chỉnh cẩn thận các tham số như tỷ lệ học, các tham số beta và epsilon để đảm bảo hiệu suất tối ưu.

- Không đảm bảo hội tụ: Giống như các thuật toán tối ưu khác, Adam không đảm bảo hội tụ đến tối ưu toàn cục và có thể bị mắc kẹt trong các cực tiểu cục bộ hoặc điểm yên ngựa.

Cần nhớ rằng nhiều vấn đề có thể được khắc phục hoặc giảm thiểu bằng cách điều chỉnh các siêu tham số của thuật toán tối ưu, theo dõi quá trình huấn luyện và lựa chọn cẩn thận lịch trình tỷ lệ học.

Tóm lại, thuật toán Adam vẫn là một thuật toán tối ưu mạnh mẽ và được sử dụng rộng rãi trong các ứng dụng học sâu. Tuy nhiên, bạn vẫn có thể thắc mắc liệu còn có những thuật toán tối ưu nào khác mà bạn có thể sử dụng.

Ứng dụng thực tế của Adam Optimizer

Dưới đây là một số lĩnh vực chính và ứng dụng nơi thuật toán Adam tối ưu hóa nổi bật trong việc huấn luyện các mô hình học sâu:

- Thị giác Máy tính – Adam được sử dụng rộng rãi trong huấn luyện các mạng nơ-ron tích chập (CNN) cho các nhiệm vụ như phân loại hình ảnh, phát hiện vật thể, phân đoạn và các tác vụ khác trong thị giác máy tính.

- Xử lý Ngôn ngữ Tự Nhiên (NLP) – Adam được sử dụng trong huấn luyện các mạng nơ-ron hồi quy như LSTM và transformers cho các tác vụ như mô hình ngôn ngữ, dịch máy và tạo văn bản.

- Mô hình Sinh Tạo – Adam là bộ tối ưu hóa mặc định trong huấn luyện các mạng đối kháng sinh tạo (GANs) và bộ giải mã tự biến thiên (VAE).

- Học Củng Cố – Các thuật toán như deep Q-learning sử dụng Adam để huấn luyện các mạng nơ-ron biểu diễn chính sách và hàm giá trị.

- Dự báo Chuỗi Thời gian – Adam giúp tăng tốc huấn luyện các mô hình chuỗi như RNNs trong các nhiệm vụ dự báo.

- Hệ thống Đề xuất – Adam rất hữu ích trong huấn luyện các lớp nhúng và mô hình lọc cộng tác thần kinh cho các hệ thống gợi ý.

- Robot học – Kết hợp với các phương pháp gradient chính sách, Adam có thể huấn luyện các chính sách điều khiển cho robot.

- Giao dịch Tài chính – Adam được sử dụng với học củng cố sâu trong các hệ thống giao dịch tự động.

- Học Máy Sâu – Adam được sử dụng rộng rãi trong tất cả các lĩnh vực học sâu nhờ vào khả năng hội tụ nhanh đối với các mô hình tham số cao chiều.

Adam có mặt ở hầu hết các lĩnh vực học sâu nhờ vào khả năng hội tụ huấn luyện nhanh cho các mô hình có tham số cao chiều.

Adam Optimizer là một công cụ tối ưu mạnh mẽ, được ứng dụng rộng rãi trong nhiều lĩnh vực học sâu nhờ vào tính hiệu quả và khả năng hội tụ nhanh chóng. Tuy nhiên, việc điều chỉnh các siêu tham số và hiểu rõ các thách thức trong quá trình huấn luyện là rất quan trọng để đạt được kết quả tối ưu.

Với các ưu điểm nổi bật, tối ưu hóa Adam là một thuật toán ngày càng trở thành sự lựa chọn hàng đầu cho các ứng dụng học máy phức tạp, từ xử lý ngôn ngữ tự nhiên đến nhận diện hình ảnh.

Khi triển khai các mô hình học sâu như Adam Optimizer, việc sử dụng hạ tầng mạnh mẽ là vô cùng quan trọng. Tại InterData, dịch vụ thuê VPS chất lượng giá rẻ cung cấp phần cứng thế hệ mới với CPU AMD EPYC/Intel Xeon Platinum và SSD NVMe U.2, giúp bạn tối ưu hiệu suất huấn luyện mà không lo về chi phí.

Nếu bạn cần hiệu suất vượt trội, thuê Cloud Server tốc độ cao tại InterData là lựa chọn tuyệt vời. Với dung lượng tối ưu và băng thông cao, các máy chủ đám mây này đáp ứng các yêu cầu khắt khe về tốc độ và tính ổn định, giúp bạn triển khai mô hình học sâu hiệu quả hơn. Liên hệ ngay để được hỗ trợ chi tiết!

INTERDATA

- Website: Interdata.vn

- Hotline: 1900-636822

- Email: [email protected]

- VPĐD: 240 Nguyễn Đình Chính, P.11. Q. Phú Nhuận, TP. Hồ Chí Minh

- VPGD: Số 211 Đường số 5, KĐT Lakeview City, P. An Phú, TP. Thủ Đức, TP. Hồ Chí Minh