Trong quá trình xây dựng mô hình Machine Learning (Học máy), việc lựa chọn đặc trưng (Feature Selection) đóng vai trò vô cùng quan trọng giúp cải thiện hiệu suất và độ chính xác của mô hình. Feature Selection giúp giảm bớt số lượng đặc trưng đầu vào, loại bỏ những đặc trưng không liên quan hoặc dư thừa, từ đó giúp mô hình trở nên gọn nhẹ và dễ hiểu hơn.

Bài viết này sẽ đi sâu vào tìm hiểu Feature Selection là gì, tìm hiểu các phương pháp Feature Selection có giám sát và không giám sát, cùng những ưu điểm khi sử dụng phương pháp này trong quy trình học máy. Đọc ngay!

Feature Selection là gì?

Feature Selection (hay Lựa chọn đặc trưng, Chọn lọc đặc trưng) là quá trình tự động hoặc thủ công nhằm chọn ra một tập hợp con (subset) các đặc trưng (features) quan trọng và phù hợp nhất từ tập dữ liệu gốc để xây dựng mô hình Machine Learning (Học máy) hiệu quả.

Nó không tạo ra đặc trưng mới hay biến đổi đặc trưng hiện có. Thay vào đó, Feature Selection tập trung vào việc giảm số lượng đặc trưng đầu vào bằng cách xác định và loại bỏ những đặc trưng không liên quan (irrelevant) hoặc dư thừa (redundant), chỉ giữ lại những thông tin cốt lõi.

Hãy tưởng tượng bạn có một bộ sưu tập công cụ lớn với nhiều món đồ. Feature Selection giống như việc bạn chỉ chọn ra những công cụ thực sự cần thiết và hữu ích nhất cho công việc cụ thể sắp tới, giúp bạn làm việc hiệu quả hơn.

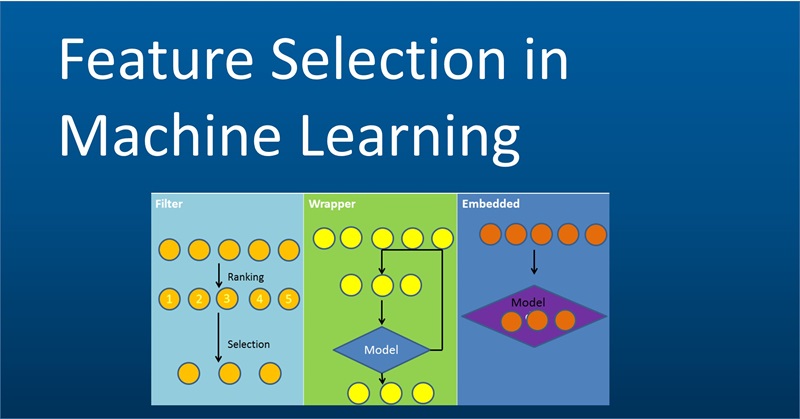

Các phương pháp Feature Selection có giám sát

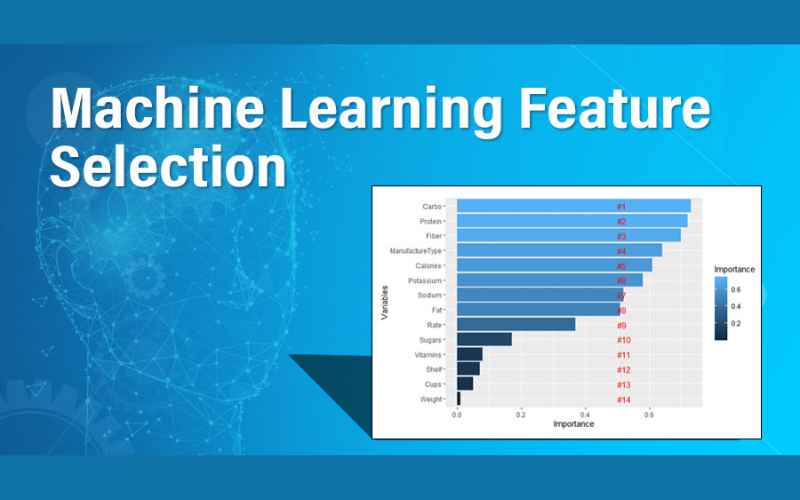

Lựa chọn đặc trưng có giám sát sử dụng biến mục tiêu để xác định các đặc trưng quan trọng nhất. Vì các đặc trưng dữ liệu đã được xác định, nhiệm vụ là xác định biến đầu vào nào ảnh hưởng trực tiếp nhất đến biến mục tiêu. Tương quan là tiêu chí chính khi đánh giá các đặc trưng quan trọng nhất.

Các phương pháp lựa chọn đặc trưng có giám sát bao gồm:

- Phương pháp lọc

- Phương pháp bao bọc

- Phương pháp nhúng

- Phương pháp kết hợp, kết hợp hai hoặc nhiều phương pháp lựa chọn đặc trưng có giám sát.

Phương pháp lọc

Phương pháp lọc là nhóm các kỹ thuật lựa chọn đặc trưng chỉ quan tâm đến dữ liệu và không trực tiếp xem xét tối ưu hóa hiệu suất mô hình. Các biến đầu vào được đánh giá độc lập so với biến mục tiêu để xác định biến nào có tương quan cao nhất. Các phương pháp kiểm tra từng đặc trưng một được gọi là phương pháp lựa chọn đặc trưng đơn biến.

Thường được sử dụng như một công cụ tiền xử lý dữ liệu, phương pháp lọc là các thuật toán lựa chọn đặc trưng nhanh chóng và hiệu quả, xuất sắc trong việc giảm sự dư thừa và loại bỏ các đặc trưng không liên quan khỏi bộ dữ liệu. Các phép kiểm tra thống kê khác nhau được sử dụng để tính điểm cho mỗi biến đầu vào về tương quan. Tuy nhiên, các phương pháp khác tốt hơn trong việc dự đoán hiệu suất mô hình.

Các phương pháp lọc phổ biến có sẵn trong các thư viện học máy như Scikit-Learn (Sklearn) bao gồm:

- Tăng thông tin (Information gain): Đo lường mức độ quan trọng của sự có mặt hoặc vắng mặt của một đặc trưng trong việc xác định biến mục tiêu bằng cách giảm mức độ entropy.

- Thông tin tương hỗ (Mutual information): Đánh giá sự phụ thuộc giữa các biến bằng cách đo lường thông tin thu được về một biến từ một biến khác.

- Kiểm định Chi-square (Chi-square test): Đánh giá mối quan hệ giữa hai biến phân loại bằng cách so sánh giá trị quan sát được với giá trị kỳ vọng.

- Điểm Fisher (Fisher’s score): Sử dụng đạo hàm để tính toán mức độ quan trọng tương đối của mỗi đặc trưng trong việc phân loại dữ liệu. Điểm cao hơn chỉ ra ảnh hưởng lớn hơn.

- Hệ số tương quan Pearson (Pearson’s correlation coefficient): Đo lường mối quan hệ giữa hai biến liên tục với điểm số từ -1 đến 1.

- Ngưỡng phương sai (Variance threshold): Loại bỏ tất cả các đặc trưng có phương sai dưới một mức tối thiểu vì các đặc trưng có phương sai lớn hơn có khả năng chứa nhiều thông tin hữu ích.

- Tỷ lệ giá trị thiếu (Missing value ratio): Tính toán tỷ lệ phần trăm các trường hợp trong bộ dữ liệu mà một đặc trưng nhất định bị thiếu hoặc có giá trị null.

- Tỷ lệ phân tán (Dispersion ratio): Tỷ lệ giữa phương sai và giá trị trung bình cho một đặc trưng. Sự phân tán cao hơn cho thấy nhiều thông tin hơn.

- ANOVA (Analysis of Variance): Xác định liệu các giá trị khác nhau của đặc trưng có ảnh hưởng đến giá trị của biến mục tiêu hay không.

Phương pháp bao bọc

Phương pháp bao bọc huấn luyện thuật toán học máy với các tập hợp con khác nhau của các đặc trưng, thêm hoặc loại bỏ các đặc trưng và kiểm tra kết quả tại mỗi vòng lặp. Mục tiêu của tất cả các phương pháp bao bọc là tìm ra bộ đặc trưng giúp tối ưu hóa hiệu suất mô hình.

Phương pháp bao bọc kiểm tra tất cả các kết hợp đặc trưng có thể có được gọi là thuật toán tham lam (greedy algorithms). Việc tìm kiếm bộ đặc trưng tốt nhất toàn diện này yêu cầu tính toán tốn kém và mất thời gian, vì vậy nó thích hợp nhất với các bộ dữ liệu có không gian đặc trưng nhỏ hơn.

Các nhà khoa học dữ liệu có thể cài đặt thuật toán để dừng lại khi hiệu suất mô hình giảm hoặc khi số lượng mục tiêu của các đặc trưng được đưa vào.

Các phương pháp bao bọc bao gồm:

- Lựa chọn tiến (Forward selection): Bắt đầu với một bộ đặc trưng rỗng và dần dần thêm các đặc trưng mới cho đến khi tìm ra bộ đặc trưng tối ưu. Lựa chọn mô hình diễn ra khi hiệu suất của thuật toán không cải thiện sau bất kỳ vòng lặp cụ thể nào.

- Lựa chọn lùi (Backward selection): Huấn luyện mô hình với tất cả các đặc trưng ban đầu và loại bỏ dần các đặc trưng ít quan trọng nhất khỏi bộ đặc trưng.

- Lựa chọn đặc trưng toàn diện (Exhaustive feature selection): Kiểm tra mọi kết hợp có thể của các đặc trưng để tìm ra bộ đặc trưng tối ưu bằng cách tối ưu hóa một chỉ số hiệu suất đã định.

- Loại bỏ đặc trưng đệ quy (Recursive Feature Elimination – RFE): Một loại lựa chọn lùi bắt đầu với không gian đặc trưng ban đầu và loại bỏ hoặc thêm các đặc trưng sau mỗi vòng lặp dựa trên mức độ quan trọng tương đối của chúng.

- Loại bỏ đặc trưng đệ quy với kiểm tra chéo (Recursive Feature Elimination with Cross-Validation – RFE-CV): Một biến thể của loại bỏ đệ quy sử dụng kiểm tra chéo, thử nghiệm mô hình trên dữ liệu chưa thấy, để chọn bộ đặc trưng có hiệu suất tốt nhất.

Phương pháp nhúng

Phương pháp nhúng tích hợp lựa chọn đặc trưng vào quá trình huấn luyện mô hình. Khi mô hình trải qua quá trình huấn luyện, nó sử dụng các cơ chế khác nhau để phát hiện các đặc trưng hoạt động kém và loại bỏ chúng khỏi các vòng lặp tiếp theo.

Nhiều phương pháp nhúng xoay quanh việc điều chuẩn (regularization), hình phạt đối với các đặc trưng dựa trên ngưỡng hệ số đã định. Các mô hình đánh đổi độ chính xác để đạt được độ chính xác cao hơn. Kết quả là các mô hình hoạt động hơi kém hơn trong huấn luyện, nhưng trở nên tổng quát hơn bằng cách giảm hiện tượng overfitting.

Các phương pháp nhúng bao gồm:

- Hồi quy LASSO (L1 regression): Thêm một hình phạt vào hàm mất mát đối với các hệ số tương quan có giá trị cao, đẩy chúng về giá trị 0. Các hệ số có giá trị 0 sẽ bị loại bỏ.

- Tính quan trọng của rừng ngẫu nhiên (Random forest importance): Xây dựng hàng trăm cây quyết định, mỗi cây sử dụng một tập hợp ngẫu nhiên các điểm dữ liệu và đặc trưng.

- Tăng cường gradient (Gradient boosting): Thêm các trình dự đoán vào một bộ hợp nhất, mỗi vòng lặp sửa chữa các lỗi của vòng trước.

Các phương pháp Feature Selection không giám sát

Với học không giám sát, các mô hình tự phát hiện các đặc trưng, mẫu và mối quan hệ trong dữ liệu. Không thể điều chỉnh các biến đầu vào cho một biến mục tiêu đã biết. Các phương pháp lựa chọn đặc trưng không giám sát sử dụng các kỹ thuật khác để đơn giản hóa và tinh chỉnh không gian đặc trưng.

Một phương pháp lựa chọn đặc trưng không giám sát là phân tích thành phần chính (PCA). PCA giảm độ phức tạp của các bộ dữ liệu lớn bằng cách biến đổi các biến có thể có tương quan thành một bộ các biến nhỏ hơn. Các thành phần chính này giữ lại hầu hết thông tin chứa trong bộ dữ liệu ban đầu. PCA giúp chống lại hiện tượng “lời nguyền chiều không gian” và giảm overfitting.

Các phương pháp khác bao gồm phân tích thành phần độc lập (ICA) và mã hóa tự động (autoencoders).

Lợi ích khi sử dụng Feature Selection

Sử dụng Feature Selection (Lựa chọn đặc trưng) trong quy trình học máy mang lại nhiều lợi ích thiết thực. Các ưu điểm chính bao gồm việc đơn giản hóa mô hình, tăng khả năng diễn giải, cải thiện hiệu suất dự đoán, giảm đáng kể thời gian huấn luyện và giảm nguy cơ quá khớp (overfitting).

Đơn giản hóa mô hình và tăng khả năng diễn giải

Việc loại bỏ các đặc trưng không cần thiết hoặc dư thừa giúp cấu trúc mô hình trở nên gọn gàng và đơn giản hơn. Mô hình đơn giản thường dễ triển khai, cập nhật và gỡ lỗi hơn trong các hệ thống thực tế, giảm chi phí bảo trì.

Với một số lượng ít đặc trưng hơn, đặc biệt là những đặc trưng có ý nghĩa nghiệp vụ rõ ràng, chúng ta có thể dễ dàng hiểu được cách mô hình đưa ra quyết định. Khả năng diễn giải (interpretability) này giúp tăng cường sự tin tưởng vào mô hình từ phía người dùng và các bên liên quan.

Cải thiện hiệu suất dự đoán

Loại bỏ các đặc trưng gây nhiễu, không liên quan đến biến mục tiêu giúp mô hình tập trung vào các tín hiệu thực sự quan trọng trong dữ liệu. Điều này thường dẫn đến việc cải thiện độ chính xác (accuracy) và các chỉ số đánh giá hiệu suất khác của mô hình.

Các đặc trưng dư thừa (redundant features) – những đặc trưng cung cấp thông tin tương tự nhau – cũng có thể bị loại bỏ. Việc này giúp mô hình hoạt động ổn định hơn và tránh phụ thuộc quá nhiều vào một nhóm thông tin cụ thể nào đó trong dữ liệu.

Giảm thời gian huấn luyện và chi phí tính toán

Huấn luyện một mô hình Machine Learning trên tập dữ liệu có số lượng đặc trưng ít hơn sẽ yêu cầu ít phép tính toán hơn. Điều này làm giảm đáng kể thời gian cần thiết để huấn luyện mô hình, giúp đẩy nhanh quá trình thử nghiệm và phát triển.

Việc giảm số chiều dữ liệu cũng giúp tiết kiệm tài nguyên phần cứng như bộ nhớ RAM và dung lượng lưu trữ. Ưu điểm này trở nên đặc biệt quan trọng khi phải xử lý các tập dữ liệu có quy mô rất lớn (Big Data).

Giảm nguy cơ quá khớp (Overfitting)

Hiện tượng quá khớp (Overfitting) xảy ra khi mô hình quá phức tạp và học thuộc lòng cả nhiễu trong dữ liệu huấn luyện, dẫn đến khả năng dự đoán kém trên dữ liệu mới. Feature Selection giúp giảm độ phức tạp của mô hình bằng cách giảm số lượng tham số.

Mô hình đơn giản hơn với ít đặc trưng hơn thường có khả năng khái quát hóa tốt hơn, tức là chúng học được quy luật tổng quát từ dữ liệu thay vì chỉ ghi nhớ các điểm dữ liệu cụ thể. Điều này làm giảm nguy cơ overfitting một cách hiệu quả.

Ưu điểm này đặc biệt phát huy tác dụng khi làm việc với dữ liệu có số chiều cao (high-dimensional data), nơi “lời nguyền chiều không gian” (Curse of Dimensionality) làm tăng nguy cơ overfitting. Feature Selection là một công cụ hữu hiệu để đối phó với thách thức này.

Cách chọn phương pháp Feature Selection

Việc chọn phương pháp Feature Selection tốt nhất phụ thuộc vào đầu vào và đầu ra cần xem xét:

- Đầu vào số, Đầu ra số: Vấn đề lựa chọn đặc trưng trong hồi quy với các biến đầu vào số – sử dụng hệ số tương quan, như hệ số tương quan Pearson (cho lựa chọn đặc trưng hồi quy tuyến tính) hoặc hệ số tương quan Spearman (cho hồi quy phi tuyến).

- Đầu vào số, Đầu ra phân loại: Vấn đề lựa chọn đặc trưng trong phân loại với các biến đầu vào số – sử dụng hệ số tương quan, xem xét mục tiêu phân loại, như hệ số tương quan ANOVA (cho tuyến tính) hoặc hệ số tương quan Kendall (cho phi tuyến).

- Đầu vào phân loại, Đầu ra số: Vấn đề mô hình hồi quy với các biến đầu vào phân loại (hiếm gặp) – sử dụng hệ số tương quan, như hệ số tương quan ANOVA (cho tuyến tính) hoặc hệ số tương quan Kendall (cho phi tuyến), nhưng theo chiều ngược lại.

- Đầu vào phân loại, Đầu ra phân loại: Vấn đề mô hình phân loại với các biến đầu vào phân loại – sử dụng hệ số tương quan, như kiểm định Chi-Squared (bảng phụ thuộc) hoặc Thông tin tương hỗ, đây là phương pháp mạnh mẽ không phụ thuộc vào kiểu dữ liệu.

Feature Selection không chỉ giúp tối ưu hóa hiệu suất mô hình mà còn mang lại nhiều lợi ích quan trọng như giảm thời gian huấn luyện, giảm nguy cơ quá khớp và tăng khả năng diễn giải của mô hình.

Việc hiểu được phương pháp Feature Selection là gì và lựa chọn phương pháp phù hợp sẽ phụ thuộc vào đặc điểm của dữ liệu và mục tiêu của bài toán. Nếu biết cách áp dụng đúng các phương pháp lựa chọn đặc trưng, bạn sẽ có thể cải thiện đáng kể hiệu quả của mô hình Machine Learning, đặc biệt khi làm việc với các bộ dữ liệu phức tạp hoặc có chiều cao.

Khi triển khai các mô hình học máy, việc sử dụng một môi trường ổn định và mạnh mẽ là vô cùng quan trọng. Dịch vụ thuê VPS chất lượng giá rẻ tại InterData cung cấp phần cứng thế hệ mới với CPU AMD EPYC và Intel Xeon Platinum, SSD NVMe U.2, giúp bạn xử lý dữ liệu nhanh chóng và hiệu quả với chi phí hợp lý.

Nếu bạn cần một giải pháp linh hoạt và mạnh mẽ hơn, dịch vụ thuê Cloud Server giá rẻ tốc độ cao của InterData là lựa chọn lý tưởng. Với cấu hình tối ưu và băng thông cao, dịch vụ này mang đến hiệu suất ổn định cho các dự án học máy, giúp bạn tối ưu hóa thời gian và chi phí trong quá trình phát triển mô hình.

INTERDATA

- Website: Interdata.vn

- Hotline: 1900-636822

- Email: [email protected]

- VPĐD: 240 Nguyễn Đình Chính, P.11. Q. Phú Nhuận, TP. Hồ Chí Minh

- VPGD: Số 211 Đường số 5, KĐT Lakeview City, P. An Phú, TP. Thủ Đức, TP. Hồ Chí Minh