Feature Engineering là một trong những bước quan trọng nhất trong quá trình phát triển mô hình Machine Learning (Học máy). Nó giúp chuyển đổi dữ liệu thô thành các đặc trưng (features) có giá trị, từ đó cải thiện hiệu suất và độ chính xác của mô hình. Bài viết này sẽ giúp bạn hiểu rõ Feature Engineering là gì, vai trò của nó trong Machine Learning, các kỹ thuật phổ biến, đồng thời đưa ra các trường hợp sử dụng thực tế của kỹ thuật này trong các lĩnh vực khác nhau. Đọc ngay!

Feature Engineering là gì?

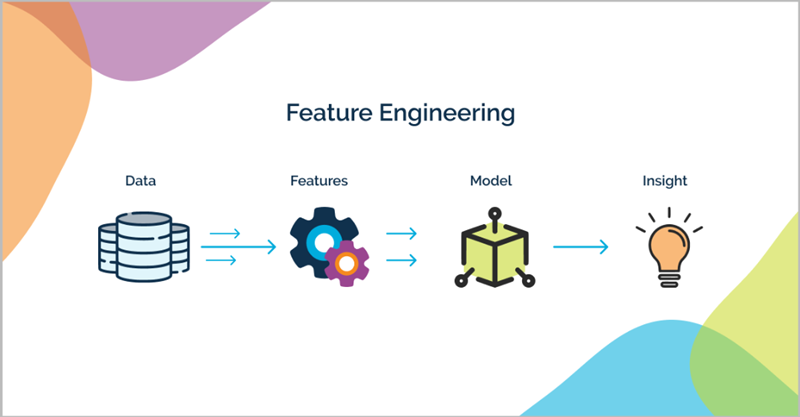

Feature Engineering (hay Kỹ thuật tạo đặc trưng) là quá trình sử dụng kiến thức chuyên môn để lựa chọn, biến đổi và tạo ra các đặc trưng (features) từ dữ liệu thô. Mục đích là làm cho dữ liệu phù hợp hơn, giúp mô hình Machine Learning (Học máy) hoạt động hiệu quả và chính xác hơn.

Đây là bước cực kỳ quan trọng trong mọi dự án Machine Learning. Chất lượng của các đặc trưng được tạo ra ảnh hưởng trực tiếp đến khả năng học hỏi và dự đoán của mô hình. Dữ liệu đầu vào tốt quyết định phần lớn thành công của mô hình cuối cùng.

Hãy hình dung dữ liệu thô như những nguyên liệu chưa qua chế biến. Feature Engineering giống như việc người đầu bếp tài năng (Data Scientist/ML Engineer) chế biến chúng thành những thành phần tinh túy, giúp món ăn (mô hình ML) trở nên ngon và hấp dẫn hơn rất nhiều.

Vai trò của Feature Engineering trong Machine Learning

Tại sao kỹ thuật feature engineering lại quan trọng trong ML? Feature Engineering đóng vai trò then chốt trong việc xây dựng các mô hình Machine Learning thành công. Nó giúp nâng cao hiệu suất mô hình, làm dữ liệu phù hợp hơn với thuật toán, giảm độ phức tạp tính toán và tăng khả năng diễn giải kết quả dự đoán cuối cùng.

Cải thiện hiệu suất và độ chính xác của mô hình

Vai trò quan trọng nhất của Feature Engineering là cải thiện đáng kể hiệu suất dự đoán của mô hình. Các đặc trưng chất lượng cao, chứa thông tin liên quan, giúp thuật toán học máy nhận diện các mẫu và mối quan hệ trong dữ liệu tốt hơn, dẫn đến độ chính xác cao hơn.

Ví dụ, trong bài toán dự đoán giá nhà, thay vì chỉ dùng ‘ngày xây dựng’, việc tạo ra đặc trưng ‘tuổi của ngôi nhà’ (năm hiện tại – năm xây dựng) thường cung cấp thông tin hữu ích hơn nhiều cho mô hình, giúp dự đoán giá chính xác hơn.

Nhiều chuyên gia giàu kinh nghiệm khẳng định rằng, việc đầu tư thời gian và công sức vào Feature Engineering thường mang lại sự cải thiện hiệu suất lớn hơn việc chỉ tập trung tinh chỉnh các tham số của thuật toán phức tạp trên những đặc trưng kém chất lượng.

Tăng cường sự phù hợp của dữ liệu với thuật toán

Feature Engineering đảm bảo dữ liệu đầu vào tương thích với yêu cầu của các thuật toán Machine Learning được lựa chọn. Đa số thuật toán không thể xử lý trực tiếp dữ liệu thô, đặc biệt là dữ liệu dạng văn bản (text) hay dữ liệu phân loại (categorical).

Ví dụ, kỹ thuật mã hóa như One-Hot Encoding biến đổi một đặc trưng phân loại (ví dụ: ‘màu sắc’ với các giá trị ‘đỏ’, ‘xanh’, ‘vàng’) thành các cột nhị phân (0/1). Điều này giúp các thuật toán như hồi quy tuyến tính hoặc mạng nơ-ron có thể sử dụng thông tin này.

Tương tự, các kỹ thuật chuẩn hóa (Scaling) như Min-Max Scaling hoặc Standardization đưa các đặc trưng số về cùng một thang đo. Việc này rất quan trọng đối với các thuật toán nhạy cảm với sự khác biệt về độ lớn giữa các đặc trưng, ví dụ như K-Nearest Neighbors (KNN) hay Support Vector Machines (SVM).

Giảm độ phức tạp và thời gian huấn luyện

Thông qua việc tạo ra các đặc trưng cô đọng thông tin hơn hoặc kết hợp với Feature Selection (Lựa chọn đặc trưng) để loại bỏ các đặc trưng không liên quan, Feature Engineering có thể giúp giảm số chiều (dimensionality) của dữ liệu một cách hiệu quả.

Việc giảm số chiều giúp đơn giản hóa mô hình, giảm nguy cơ quá khớp (overfitting) – tình trạng mô hình học quá tốt trên dữ liệu huấn luyện nhưng lại dự đoán kém trên dữ liệu mới. Mô hình đơn giản hơn thường dễ hiểu và dễ triển khai hơn.

Dữ liệu với ít chiều hơn và cấu trúc tốt hơn cũng giúp giảm đáng kể thời gian cần thiết để huấn luyện mô hình. Lợi ích này càng rõ rệt khi làm việc với các tập dữ liệu lớn (Big Data), tiết kiệm tài nguyên tính toán đáng kể.

Tăng khả năng diễn giải và hiểu mô hình

Khi các đặc trưng được tạo ra có ý nghĩa rõ ràng trong bối cảnh của bài toán (ví dụ: ‘tỷ lệ nhấp chuột’, ‘số ngày kể từ lần mua cuối’), chúng ta có thể dễ dàng hiểu và giải thích tại sao mô hình lại đưa ra một quyết định hay dự đoán cụ thể.

Khả năng diễn giải (Interpretability) này cực kỳ quan trọng trong các lĩnh vực yêu cầu tính minh bạch và trách nhiệm giải trình cao như tài chính (đánh giá tín dụng), y tế (chẩn đoán bệnh). Nó giúp xây dựng lòng tin vào các hệ thống dựa trên Machine Learning.

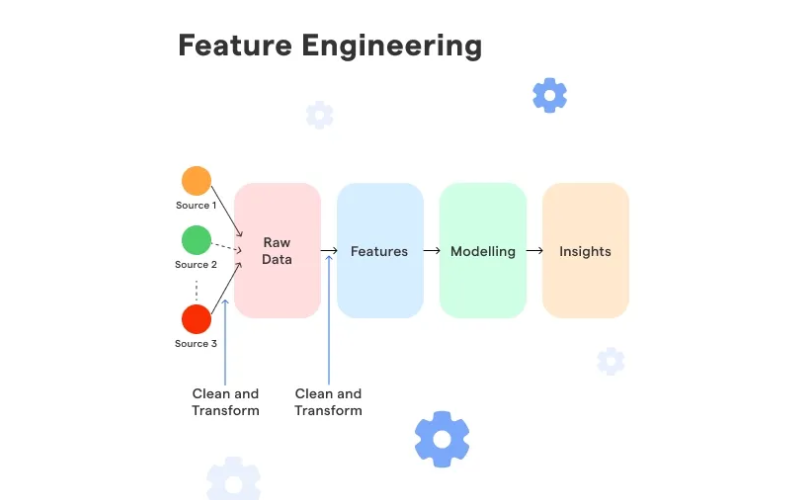

Cách thức hoạt động của kỹ thuật đặc trưng – Feature Engineering

Quá trình kỹ thuật đặc trưng có thể diễn ra theo các bước sau:

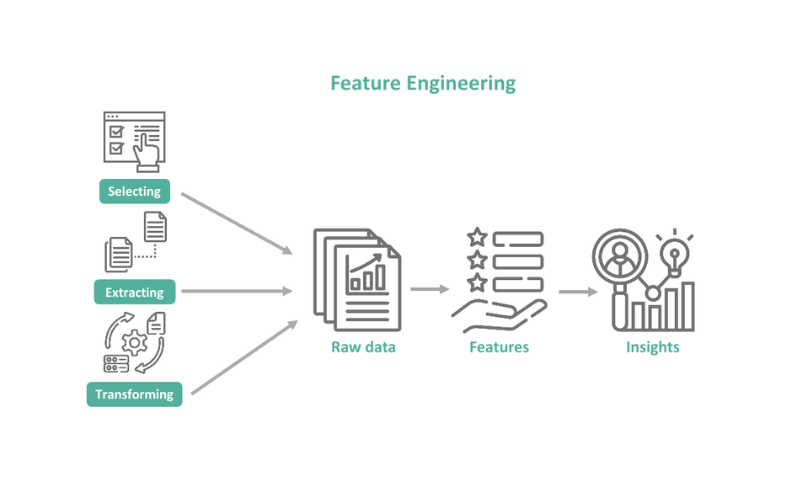

- Tạo ra các đặc trưng – Xem xét rất nhiều dữ liệu, phân tích kỹ thuật đặc trưng trong các vấn đề khác và xác định những gì có thể sử dụng từ chúng.

- Định nghĩa các đặc trưng – Bao gồm hai quy trình: rút trích đặc trưng, quy trình xác định và rút trích một bộ các đặc trưng đại diện cho dữ liệu quan trọng đối với phân tích; và xây dựng đặc trưng, quy trình chuyển đổi một bộ đặc trưng đầu vào cụ thể thành một bộ đặc trưng mới, hiệu quả hơn có thể sử dụng cho dự đoán. Tùy thuộc vào vấn đề, người dùng có thể chọn sử dụng phương pháp rút trích đặc trưng tự động, xây dựng đặc trưng thủ công hoặc kết hợp cả hai.

- Lựa chọn các đặc trưng – Khi người dùng đã biết một số thông tin về dữ liệu và đã định nghĩa các đặc trưng tiềm năng, bước tiếp theo là chọn các đặc trưng phù hợp. Điều này bao gồm hai yếu tố: lựa chọn đặc trưng, quy trình chọn một tập con của các đặc trưng có liên quan nhất đối với một nhiệm vụ cụ thể; và đánh giá đặc trưng, quá trình đánh giá mức độ hữu ích của một đặc trưng đối với dự đoán.

- Đánh giá mô hình – Đánh giá các đặc trưng bằng cách đánh giá độ chính xác của mô hình trên dữ liệu chưa thấy trước đó bằng cách sử dụng các đặc trưng đã chọn.

Kỹ thuật Feature Engineering

Các kỹ thuật Feature Engineering bao gồm:

- Điền giá trị thiếu (Imputation) – Một vấn đề phổ biến trong học máy là sự thiếu giá trị trong bộ dữ liệu, điều này ảnh hưởng đến cách các thuật toán học máy hoạt động. Điền giá trị thiếu là quá trình thay thế dữ liệu thiếu bằng các ước lượng thống kê của giá trị bị thiếu, tạo ra một bộ dữ liệu hoàn chỉnh để sử dụng trong việc huấn luyện các mô hình học máy.

- Mã hóa one-hot (One-hot encoding) – Là quá trình chuyển đổi dữ liệu phân loại thành một dạng mà thuật toán học máy có thể hiểu được để đưa ra dự đoán chính xác hơn.

- Bao bì từ (Bag of words) – Là thuật toán đếm số lần một từ xuất hiện trong một tài liệu. Nó có thể được sử dụng để xác định sự tương đồng và khác biệt trong các tài liệu, phục vụ cho các ứng dụng như tìm kiếm và phân loại tài liệu.

- Kỹ thuật đặc trưng tự động (Automated feature engineering) – Kỹ thuật này giúp rút ra các đặc trưng hữu ích và có ý nghĩa bằng một khuôn khổ có thể áp dụng cho bất kỳ vấn đề nào. Kỹ thuật đặc trưng tự động giúp các nhà khoa học dữ liệu làm việc hiệu quả hơn, vì họ có thể dành nhiều thời gian hơn cho các thành phần khác trong học máy. Kỹ thuật này cũng cho phép các nhà khoa học dữ liệu công dân thực hiện kỹ thuật đặc trưng bằng cách sử dụng phương pháp dựa trên khuôn khổ.

- Phân nhóm (Binning) – Phân nhóm, hay nhóm dữ liệu, là yếu tố quan trọng trong việc chuẩn bị dữ liệu số cho học máy. Kỹ thuật này có thể được sử dụng để thay thế một cột số bằng các giá trị phân loại đại diện cho các khoảng giá trị cụ thể.

- N-gram – Giúp dự đoán mục tiếp theo trong một chuỗi. Trong phân tích cảm xúc, mô hình n-gram giúp phân tích cảm xúc của văn bản hoặc tài liệu.

- Kết hợp đặc trưng (Feature crosses) – Là cách kết hợp hai hoặc nhiều đặc trưng phân loại thành một đặc trưng. Kỹ thuật này đặc biệt hữu ích khi một số đặc trưng kết hợp lại thể hiện tốt hơn một thuộc tính nào đó so với khi chúng riêng lẻ.

Một số thư viện mã nguồn mở Python hỗ trợ các kỹ thuật Feature Engineering, bao gồm thư viện Featuretools để tự động tạo ra các đặc trưng từ một bộ các bảng liên quan bằng cách sử dụng tổng hợp đặc trưng sâu (deep feature synthesis), một thuật toán tự động tạo ra các đặc trưng cho các bộ dữ liệu quan hệ.

Các thuật ngữ phổ biến liên quan đến Feature Engineering

Trong Feature Engineering và lĩnh vực Machine Learning nói chung, có nhiều thuật ngữ quan trọng bạn cần hiểu rõ. Bao gồm Feature, Raw Data, Feature Selection, Feature Extraction, Encoding, Scaling, Imputation, và Binning. Nắm vững các khái niệm này sẽ giúp bạn thực hiện quy trình hiệu quả hơn.

Feature (Đặc trưng)

Feature, hay đặc trưng, là một thuộc tính hoặc biến số riêng lẻ, có thể đo lường được, được sử dụng làm đầu vào cho mô hình Machine Learning. Nó đại diện cho một khía cạnh cụ thể của dữ liệu thô đã được xử lý hoặc lựa chọn cẩn thận.

Raw Data (Dữ liệu thô)

Raw Data là dữ liệu ở trạng thái ban đầu, ngay sau khi được thu thập và trước khi trải qua bất kỳ quá trình xử lý, làm sạch hay biến đổi nào đáng kể. Dữ liệu này thường chứa lỗi, giá trị thiếu, định dạng không nhất quán và nhiễu.

Feature Engineering chính là cầu nối quan trọng, biến đổi Raw Data lộn xộn này thành các Features có cấu trúc, sạch sẽ và ý nghĩa. Quá trình này trích xuất thông tin giá trị tiềm ẩn trong dữ liệu thô để mô hình có thể học được.

Feature Selection (Lựa chọn đặc trưng)

Feature Selection là quá trình tự động hoặc thủ công nhằm chọn ra một tập hợp con các features phù hợp nhất từ tập features ban đầu hoặc đã được tạo ra. Mục tiêu là loại bỏ những features không liên quan, dư thừa hoặc ít thông tin.

Hoạt động này khác biệt với Feature Engineering – vốn tập trung vào việc tạo mới hoặc biến đổi features. Feature Selection chỉ đơn thuần là “chọn lọc” từ những gì đã có, thường diễn ra sau hoặc song song với Feature Engineering để tối ưu hóa mô hình cuối cùng.

Feature Extraction (Trích xuất đặc trưng)

Feature Extraction là kỹ thuật tạo ra các features mới từ các features ban đầu thông qua các phép biến đổi toán học. Các features mới này thường có số chiều thấp hơn và có thể không giữ nguyên ý nghĩa vật lý ban đầu của dữ liệu.

Encoding (Mã hóa)

Encoding là quá trình chuyển đổi dữ liệu từ dạng phân loại (categorical), ví dụ như văn bản hoặc nhãn (‘Nam’/’Nữ’, ‘Thành phố A’/’Thành phố B’), sang dạng số mà các thuật toán Machine Learning có thể hiểu và xử lý được.

Kỹ thuật One-Hot Encoding rất phổ biến, nó tạo ra các cột nhị phân mới (chỉ chứa giá trị 0 hoặc 1) cho mỗi giá trị duy nhất của feature phân loại gốc. Ví dụ, feature ‘Phương tiện’ có giá trị [‘Xe máy’, ‘Ô tô’] sẽ thành 2 cột mới.

Scaling/Normalization (Chuẩn hóa/Quy về thang đo)

Scaling (hay Normalization) là việc điều chỉnh phạm vi giá trị của các features dạng số (numerical) về một thang đo chung, ví dụ như từ 0 đến 1 hoặc có trung bình 0 và độ lệch chuẩn 1. Việc này rất quan trọng cho nhiều thuật toán.

Nó giúp đảm bảo rằng các features có đơn vị đo hoặc khoảng giá trị khác nhau (ví dụ: ‘tuổi’ từ 0-100 và ‘thu nhập’ hàng triệu) có tầm ảnh hưởng tương đương lên mô hình, tránh việc feature có giá trị lớn hơn lấn át các feature khác.

Imputation (Gán giá trị thiếu)

Imputation là tên gọi chung cho các kỹ thuật xử lý giá trị bị thiếu (missing values hay NaN) trong tập dữ liệu. Thay vì loại bỏ các hàng hoặc cột chứa giá trị thiếu (có thể làm mất thông tin), imputation cố gắng điền vào các khoảng trống đó.

Các phương pháp imputation phổ biến bao gồm thay thế giá trị thiếu bằng giá trị trung bình (mean), trung vị (median), hoặc giá trị xuất hiện nhiều nhất (mode) của cột đó. Các kỹ thuật phức tạp hơn có thể dùng mô hình khác để dự đoán giá trị thiếu.

Binning/Discretization (Rời rạc hóa)

Binning (hay Discretization) là quá trình chia một feature số liên tục (ví dụ: ‘tuổi’, ‘thu nhập’) thành một số lượng hữu hạn các khoảng (bins) hoặc nhóm rời rạc. Mỗi khoảng này được xem như một category.

Một số thách thức của Feature Engineering

Những thách thức khi thực hiện feature engineering là gì? Mặc dù đóng vai trò cực kỳ quan trọng, quy trình Feature Engineering cũng đối mặt với không ít thách thức đáng kể. Các khó khăn chính bao gồm yêu cầu kiến thức chuyên môn sâu, tốn nhiều thời gian, tiềm ẩn nguy cơ rò rỉ dữ liệu và đôi khi mang tính ‘nghệ thuật’ khó hệ thống hóa.

Yêu cầu kiến thức chuyên môn (Domain Knowledge)

Để tạo ra các features thực sự có giá trị và ý nghĩa, người thực hiện cần hiểu biết sâu sắc về lĩnh vực của dữ liệu (domain knowledge). Nếu không hiểu rõ bối cảnh nghiệp vụ, rất khó để biết nên kết hợp, biến đổi hay tạo ra thông tin nào từ dữ liệu gốc.

Ví dụ, trong lĩnh vực tài chính ngân hàng, việc tạo ra feature ‘tỷ lệ nợ trên thu nhập’ từ các cột dữ liệu gốc đòi hỏi sự am hiểu về các chỉ số tài chính quan trọng, chứ không chỉ đơn thuần là các phép tính toán học trên dữ liệu.

Sự thiếu hụt kiến thức chuyên môn có thể dẫn đến việc tạo ra các features không liên quan, sai lệch hoặc bỏ lỡ những thông tin quan trọng ẩn giấu trong dữ liệu, làm giảm hiệu quả của mô hình cuối cùng một cách đáng tiếc.

Tốn nhiều thời gian và công sức

Feature Engineering không phải là công việc làm một lần là xong. Nó là một quá trình lặp đi lặp lại, đòi hỏi sự thử nghiệm liên tục các ý tưởng khác nhau, đánh giá cẩn thận kết quả và tinh chỉnh không ngừng. Quá trình này tiêu tốn rất nhiều thời gian và nguồn lực.

Các nhà khoa học dữ liệu (Data Scientists) có thể phải dành phần lớn thời gian của dự án chỉ để chuẩn bị và tạo đặc trưng cho dữ liệu. Việc thử nghiệm hàng chục, thậm chí hàng trăm giả thuyết về feature mới là điều khá phổ biến trong các dự án thực tế.

Tính “Nghệ thuật” và khó hệ thống hóa

Không có một công thức hay quy trình chuẩn mực duy nhất nào đảm bảo tạo ra được các features tốt nhất cho mọi bài toán. Feature Engineering thường đòi hỏi sự sáng tạo, trực giác và kinh nghiệm thực tế, đôi khi giống một “nghệ thuật” hơn là khoa học thuần túy.

Chính vì yếu tố “nghệ thuật” này, việc hệ thống hóa hay tự động hóa hoàn toàn quy trình Feature Engineering trở nên rất thách thức. Mặc dù các công cụ AutoML (Automated Machine Learning) đang cố gắng giải quyết vấn đề này, vai trò của con người vẫn còn rất lớn.

Nguy cơ rò rỉ dữ liệu (Data Leakage)

Đây là một trong những cạm bẫy nguy hiểm và dễ mắc phải nhất trong Feature Engineering. Data Leakage xảy ra khi thông tin từ bên ngoài tập huấn luyện (ví dụ: từ tập kiểm tra hoặc từ chính biến mục tiêu) vô tình bị rò rỉ vào quá trình tạo feature cho tập huấn luyện.

Hậu quả là mô hình đạt được hiệu suất cao một cách giả tạo trong quá trình đánh giá (validation) nhưng lại hoạt động rất kém khi triển khai trên dữ liệu thực tế chưa từng thấy. Cần hết sức cẩn trọng trong từng bước biến đổi dữ liệu để tránh lỗi này.

Ví dụ phổ biến của Data Leakage là việc tính toán các giá trị thống kê (như mean, median, min, max) để scaling hoặc imputation trên toàn bộ tập dữ liệu trước khi chia thành tập huấn luyện (train) và tập kiểm tra (test).

Lời nguyền chiều không gian (Curse of Dimensionality)

Việc tạo ra quá nhiều features mới, đặc biệt thông qua các kỹ thuật như One-Hot Encoding trên các biến có nhiều giá trị duy nhất hoặc tạo Polynomial Features bậc cao, có thể dẫn đến hiện tượng “lời nguyền chiều không gian”.

Khi số lượng features (chiều dữ liệu) tăng lên quá lớn so với số lượng mẫu dữ liệu, không gian trở nên cực kỳ thưa thớt. Điều này làm cho các thuật toán dựa trên khoảng cách (như KNN) hoạt động kém hiệu quả, mô hình dễ bị quá khớp (overfitting) hơn.

Các trường hợp sử dụng Feature Engineering

Feature Engineering là một kỹ thuật nền tảng và được áp dụng rộng rãi trong hầu hết các bài toán và lĩnh vực của Machine Learning. Nó được sử dụng để xử lý nhiều loại dữ liệu khác nhau, từ dạng bảng truyền thống đến văn bản, hình ảnh và chuỗi thời gian.

Xử lý dữ liệu dạng bảng (Tabular Data)

Đây là lĩnh vực ứng dụng phổ biến và cơ bản nhất của Feature Engineering. Với dữ liệu được tổ chức dưới dạng hàng và cột trong bảng, kỹ thuật này giúp xử lý giá trị thiếu, mã hóa các biến phân loại, và chuẩn hóa các biến số liên tục.

Ví dụ, trong bài toán dự đoán khả năng khách hàng rời bỏ dịch vụ (customer churn), chúng ta có thể tạo các features mới như ‘thời gian khách hàng đã sử dụng dịch vụ’, ‘tỷ lệ giữa số cuộc gọi ban ngày và ban đêm’, hoặc ‘số ngày kể từ lần cuối cùng liên hệ hỗ trợ’.

Các kỹ thuật như tạo biến tương tác (interaction features – ví dụ: nhân giá trị hai cột với nhau) hay biến đa thức (polynomial features) cũng thường được áp dụng trên dữ liệu bảng để mô hình nắm bắt được các mối quan hệ phức tạp hơn giữa các biến.

Xử lý dữ liệu văn bản (Text Data) trong NLP

Trong lĩnh vực Xử lý Ngôn ngữ Tự nhiên (NLP – Natural Language Processing), Feature Engineering đóng vai trò cốt lõi để biến đổi văn bản phi cấu trúc thành dạng dữ liệu số mà các thuật toán Machine Learning có thể hiểu và xử lý được một cách hiệu quả.

Các kỹ thuật phổ biến bao gồm Bag-of-Words (BoW) – đếm tần suất xuất hiện của từ, TF-IDF (Term Frequency-Inverse Document Frequency) – đánh giá tầm quan trọng của từ trong một tài liệu so với toàn bộ kho văn bản, hoặc tạo N-grams để nắm bắt các cụm từ.

Ngoài ra, việc tạo các features như ‘độ dài của văn bản’, ‘số lượng câu’, ‘tỷ lệ từ viết hoa’, hay sử dụng các kỹ thuật nhúng từ (Word Embeddings) như Word2Vec, GloVe để biểu diễn ngữ nghĩa của từ cũng là những ứng dụng quan trọng của Feature Engineering trong NLP.

Xử lý dữ liệu hình ảnh (Image Data) trong Computer Vision

Trước khi các mô hình Deep Learning phát triển mạnh mẽ, Feature Engineering thủ công là bước cực kỳ quan trọng trong lĩnh vực Thị giác Máy tính (Computer Vision). Nó tập trung vào việc trích xuất các đặc điểm hình ảnh có ý nghĩa như cạnh, góc, điểm đặc biệt, màu sắc, kết cấu (texture).

Các thuật toán kinh điển như SIFT (Scale-Invariant Feature Transform), SURF (Speeded Up Robust Features), hay HOG (Histogram of Oriented Gradients) được thiết kế để tạo ra các vector đặc trưng (feature vectors) mô tả nội dung của hình ảnh, phục vụ cho các tác vụ như nhận dạng vật thể, phân loại ảnh.

Mặc dù các mạng nơ-ron tích chập (CNN – Convolutional Neural Networks) hiện nay có khả năng tự động học các đặc trưng (Feature Learning) hiệu quả, việc hiểu các nguyên tắc Feature Engineering truyền thống vẫn rất hữu ích để phân tích, gỡ lỗi và cải thiện mô hình Deep Learning.

Xử lý dữ liệu chuỗi thời gian (Time Series Data)

Đối với dữ liệu có yếu tố thời gian (ví dụ: giá cổ phiếu, dữ liệu cảm biến, dự báo thời tiết), Feature Engineering giúp tạo ra các đặc trưng nắm bắt được tính xu hướng (trend), tính mùa vụ (seasonality), và sự phụ thuộc vào các giá trị trong quá khứ (lagged features).

Các kỹ thuật thường dùng bao gồm tính toán các giá trị thống kê trượt (ví dụ: trung bình trượt – moving average, độ lệch chuẩn trượt), tạo các biến độ trễ (ví dụ: giá trị của ngày hôm qua, tuần trước), hoặc phân rã thành phần thời gian (năm, quý, tháng, thứ trong tuần).

Các ứng dụng khác

Ngoài các lĩnh vực trên, kỹ thuật Feature Engineering còn được ứng dụng rộng rãi trong nhiều bài toán khác như: hệ thống gợi ý (tạo đặc trưng người dùng, đặc trưng sản phẩm), phát hiện gian lận (tạo đặc trưng hành vi bất thường), phân tích dữ liệu không gian địa lý (tạo đặc trưng khoảng cách, vùng lân cận).

Tóm lại, bất cứ nơi nào có dữ liệu và mong muốn xây dựng mô hình Machine Learning hiệu quả, Feature Engineering đều đóng một vai trò không thể thiếu. Nó giúp khai phá tối đa giá trị từ dữ liệu thô, tạo nền tảng vững chắc cho các bước mô hình hóa tiếp theo.

Khi triển khai các mô hình Machine Learning, việc chọn một môi trường ổn định và hiệu quả là rất quan trọng. Dịch vụ thuê VPS chất lượng giá rẻ tại InterData sử dụng phần cứng thế hệ mới với CPU AMD EPYC hoặc Intel Xeon Platinum, SSD NVMe U.2 và băng thông cao, giúp bạn chạy các tác vụ tính toán mà không gặp phải sự cố về hiệu suất.

Nếu bạn cần một hệ thống mạnh mẽ và linh hoạt hơn, dịch vụ thuê Cloud Server giá rẻ tốc độ cao của InterData sẽ là lựa chọn lý tưởng. Với cấu hình tối ưu, dung lượng linh hoạt và tốc độ xử lý vượt trội, dịch vụ này sẽ giúp bạn triển khai các mô hình học máy, phân tích dữ liệu hoặc lưu trữ với hiệu suất ổn định và chi phí hợp lý.

INTERDATA

- Website: Interdata.vn

- Hotline: 1900-636822

- Email: [email protected]

- VPĐD: 240 Nguyễn Đình Chính, P.11. Q. Phú Nhuận, TP. Hồ Chí Minh

- VPGD: Số 211 Đường số 5, KĐT Lakeview City, P. An Phú, TP. Thủ Đức, TP. Hồ Chí Minh