Data Preprocessing (Xử lý dữ liệu) đóng vai trò quan trọng trong việc chuẩn bị dữ liệu cho các tác vụ phân tích và học máy. Quá trình này không chỉ giúp cải thiện chất lượng dữ liệu mà còn đảm bảo các mô hình học máy và AI hoạt động hiệu quả. Bài viết dưới đây sẽ giúp bạn hiểu rõ Data Preprocessing là gì, các bước trong xử lý dữ liệu, các kỹ thuật và công cụ phổ biến, cũng như tầm quan trọng của Data Preprocessing trong học máy và trí tuệ nhân tạo ngày nay. Đọc ngay!

Data Preprocessing là gì?

Data Preprocessing (Xử lý dữ liệu) là một yếu tố quan trọng trong việc chuẩn bị dữ liệu, đề cập đến bất kỳ quy trình nào được áp dụng cho dữ liệu thô để chuẩn bị cho các tác vụ phân tích hoặc xử lý tiếp theo.

Lúc trước, Data Preprocessing đã luôn là một bước sơ bộ quan trọng trong phân tích dữ liệu. Tuy nhiên, gần đây, các kỹ thuật này đã được áp dụng để huấn luyện các mô hình học máy và trí tuệ nhân tạo (AI) và thực hiện suy luận từ chúng.

Do đó, xử lý dữ liệu có thể được định nghĩa là quá trình chuyển đổi dữ liệu thô thành định dạng mà có thể xử lý hiệu quả và chính xác hơn trong các tác vụ như:

- Phân tích dữ liệu

- Học máy

- Khoa học dữ liệu

- Trí tuệ nhân tạo (AI)

Tầm quan trọng của Data Preprocessing

Không lâu trước đây, thiếu dữ liệu là thách thức lớn nhất mà bạn phải đối mặt khi sử dụng phân tích mạnh mẽ để giải quyết các vấn đề kinh doanh. Khi đó, việc kiểm tra lỗi hoặc sự không nhất quán trong một bộ dữ liệu nhỏ là khá dễ dàng.

Hiện nay, chúng ta có quá nhiều dữ liệu đến mức dễ dàng mất kiểm soát về những gì đúng và sai. Ngày càng nhiều công ty phải đối mặt với “dữ liệu bẩn”, điều này có thể làm chậm toàn bộ bộ phận và dẫn đến các lỗi nghiêm trọng.

Các giải pháp như học máy (ML) và trí tuệ nhân tạo (AI) có thể giúp làm sáng tỏ dữ liệu, nhưng chỉ khi chúng nhận được đầu vào chính xác. Trong lĩnh vực học máy, bạn sẽ thường nghe câu nói “garbage in, garbage out”, điều này tóm tắt vấn đề một cách hoàn hảo. Nếu bạn cung cấp thông tin sai cho máy, bạn sẽ nhận được kết quả sai.

Data Preprocessing có thể giúp giải quyết vấn đề này. Dưới đây là cách thức hoạt động.

- Phát hiện giá trị ngoại lệ: Các giá trị ngoại lệ có thể làm sai lệch kết quả nếu bạn không phát hiện kịp thời. Xử lý dữ liệu có thể phát hiện và xử lý những ngoại lệ này, loại bỏ hoặc chuyển đổi chúng.

- Xử lý dữ liệu thiếu: Đôi khi, trong một bộ dữ liệu tưởng chừng hoàn hảo, thông tin quan trọng có thể bị thiếu. Điều này có thể gây ra sự thiên lệch và phân tích sai. Với Data Preprocessing, bạn có thể tìm và sửa dữ liệu thiếu.

- Giảm chiều dữ liệu: Dữ liệu có nhiều chiều yêu cầu tính toán phức tạp và có thể làm chậm hệ thống của bạn. Trong quá trình xử lý dữ liệu, bạn có thể thực hiện giảm chiều, một quá trình giúp giảm số lượng đặc trưng trong dữ liệu mà vẫn giữ lại thông tin quan trọng.

- Cải thiện quyền riêng tư và bảo mật: Đôi khi, để tuân thủ các quy định bảo mật hoặc yêu cầu của người dùng, bạn cần áp dụng các biện pháp như ẩn danh. Trong quá trình xử lý dữ liệu, bạn có thể ẩn danh hoặc xóa các thông tin nhạy cảm để đảm bảo tuân thủ và bảo mật.

- Tăng tốc phân tích: Khi dữ liệu được chuẩn hóa, không có lỗi hay vấn đề nào khác, toàn bộ quá trình phân tích sẽ nhanh hơn.

Lợi ích của Data Preprocessing cho học máy và AI

Cả học máy (ML) và AI đều hoạt động tốt nhất khi chúng có một lượng lớn dữ liệu tốt. Nếu không có Data Preprocessing, các thuật toán này sẽ thất bại sớm hay muộn.

ML và AI học từ dữ liệu chúng nhận được. Nếu chúng nhận thông tin sai, kết luận của chúng sẽ chứa sự thiên lệch và thông tin không chính xác.

Hơn nữa, hầu hết các thuật toán học máy đơn giản sẽ không hoạt động trên dữ liệu thô. Bạn cần phải chuyển đổi dữ liệu sao cho phù hợp với yêu cầu của thuật toán học máy.

Điều tương tự cũng áp dụng với các thuật toán AI. Mỗi thuật toán sẽ yêu cầu một định dạng dữ liệu nhất định. Nếu bạn cung cấp định dạng sai, thuật toán có thể hoạt động nhưng kết quả sẽ không tối ưu. Các thuật toán AI cũng dễ bị thiên lệch. Chúng không thể phân biệt đúng sai, vì vậy đảm bảo độ chính xác của dữ liệu là vô cùng quan trọng.

Ngoài ra, Data Preprocessing cũng mang lại một số lợi ích cho học máy như:

Đảm bảo dữ liệu chất lượng cao

Xử lý dữ liệu ảnh hưởng trực tiếp đến độ chính xác của phân tích. Dữ liệu đã qua xử lý, không có nhiễu và sự không nhất quán, giúp các mô hình nhận diện và học từ các đặc trưng quan trọng, nâng cao độ chính xác trong dự đoán và khả năng ra quyết định.

Quá trình Data Preprocessing bao gồm nhiều hoạt động như làm sạch dữ liệu, xử lý giá trị thiếu, chuẩn hóa hoặc tỷ lệ hóa các đặc trưng, mã hóa các biến phân loại và giảm chiều dữ liệu. Mỗi bước giúp cải thiện bộ dữ liệu sao cho các thuật toán học máy có thể giải thích và xử lý dữ liệu một cách chính xác và hiệu quả. Ví dụ, hiểu cách SVM hoạt động là điều quan trọng khi chọn thuật toán phù hợp cho các tác vụ phân loại.

Chẳng hạn, chuẩn hóa đặc trưng đảm bảo rằng tất cả các đặc trưng đầu vào có trọng số như nhau, ngăn không cho một đặc trưng nào ảnh hưởng quá mức đến kết quả của mô hình. Tương tự, mã hóa các biến phân loại thành dạng số là điều cần thiết đối với một số thuật toán chỉ nhận dữ liệu số làm đầu vào.

Cải thiện độ chính xác và hiệu suất mô hình

Data Preprocessing trong học máy giúp loại bỏ nhiều trở ngại có thể làm giảm hiệu suất của mô hình. Điều này giúp chúng ta đưa ra các dự đoán chính xác, đáng tin cậy và mạnh mẽ hơn.

Xử lý dữ liệu bảo vệ chống lại hiện tượng quá khớp, nơi mô hình có thể coi nhiễu là một phần của tín hiệu, làm suy yếu khả năng tổng quát với dữ liệu mới. Các kỹ thuật như chuẩn hóa và tỷ lệ hóa đặc trưng giúp mô hình dễ dàng thích nghi.

Kỹ thuật đặc trưng, một phần quan trọng trong phát triển mô hình, được hỗ trợ rất tốt bởi xử lý dữ liệu. Nó giúp tạo ra các đặc trưng sáng tạo từ dữ liệu hiện có, cải thiện hiệu suất mô hình.

Chẳng hạn, có một bộ dữ liệu khảo sát y tế với hàng trăm đặc trưng. Thông qua xử lý dữ liệu, đặc biệt là lựa chọn đặc trưng, bạn có thể xác định các đặc trưng quan trọng nhất như tuổi, triệu chứng và lịch sử y tế để dự đoán bệnh. Điều này giúp loại bỏ các chi tiết ít quan trọng hơn, như màu sắc yêu thích của bệnh nhân, nâng cao độ chính xác của mô hình dự đoán mà không thay đổi dữ liệu gốc.

Tăng tốc quá trình học và độ tin cậy của mô hình

Hiệu quả của quá trình huấn luyện cũng được cải thiện rất nhiều nhờ xử lý dữ liệu. Các thuật toán có thể nhận diện mẫu trong dữ liệu sạch nhanh chóng hơn, từ đó giảm thời gian, công sức và năng lượng cần thiết để huấn luyện thuật toán. Đây là những yếu tố quan trọng trong môi trường dữ liệu lớn.

Hơn nữa, độ tin cậy của các thông tin rút ra từ AI và học máy phụ thuộc vào độ chính xác của quá trình xử lý dữ liệu. Nó đảm bảo rằng dữ liệu đầu vào cho mô hình là đáng tin cậy, giúp đưa ra dự đoán đáng tin cậy và có thể hành động.

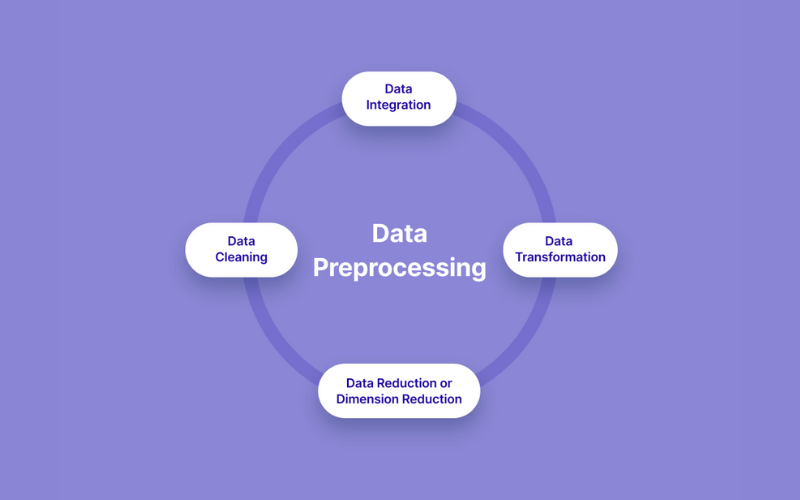

Các bước chính trong Data Preprocessing

Xử lý dữ liệu Data Preprocessing có bốn bước chính:

- Đánh giá chất lượng dữ liệu

- Dọn dẹp dữ liệu

- Chuyển đổi dữ liệu

- Giảm dữ liệu

Hãy cùng tìm hiểu chi tiết từng bước để hiểu hơn Data Preprocessing là gì.

Đánh giá chất lượng dữ liệu

Khi nhìn qua lần đầu, dữ liệu của bạn có thể có vẻ đúng, nhưng thực sự là như thế nào? Trước khi bắt đầu làm việc với dữ liệu và chuẩn bị nó cho các bước tiếp theo, bạn phải thực hiện một đánh giá chất lượng để xác minh rằng dữ liệu thực sự chính xác. Các vấn đề phổ biến thường gặp, đặc biệt khi thu thập thông tin từ nhiều nguồn, bao gồm:

- Dữ liệu không khớp kiểu: Các nguồn khác nhau có thể có dữ liệu ở các định dạng khác nhau, điều này sẽ làm cho máy tính gần như không thể giải thích chính xác mọi thứ.

- Dữ liệu thiếu: Đôi khi dữ liệu không đầy đủ, có thể do lỗi của con người hoặc máy móc. Dù nguyên nhân là gì, nó sẽ làm sai lệch kết quả và cần được xử lý.

- Ngoại lệ: Những giá trị ngoại lệ có thể ảnh hưởng lớn đến phân tích dữ liệu của bạn, đặc biệt nếu bạn đang cố gắng tính toán trung bình hoặc nhận diện xu hướng thống kê. Bạn cần tìm và xử lý chúng trong quá trình đánh giá chất lượng dữ liệu.

- Mô tả giá trị hỗn hợp: Dữ liệu có thể trông đồng nhất, nhưng thực tế không phải vậy. Ví dụ, việc sử dụng các từ đồng nghĩa để chỉ cùng một thứ trong các giá trị dữ liệu khác nhau có thể gây sai lệch kết quả vì máy tính không luôn nhận biết đó là cùng một thứ.

Dọn dẹp dữ liệu

Sau khi thực hiện đánh giá chất lượng, bước tiếp theo là dọn dẹp dữ liệu. Điều này bao gồm việc sửa chữa, loại bỏ hoặc sửa lại bất kỳ dữ liệu không liên quan nào. Quá trình này sẽ thay đổi đôi chút tùy theo vấn đề được xác định trong bước đầu.

- Đối với dữ liệu thiếu, bạn có thể thêm thông tin bị thiếu một cách thủ công hoặc loại bỏ các mục bị ảnh hưởng. Việc loại bỏ dữ liệu chỉ được khuyến nghị đối với các bộ dữ liệu lớn, nếu không sẽ làm sai lệch kết quả.

- Đối với dữ liệu ngoại lệ, dữ liệu không khớp hoặc hỗn hợp – quá trình sửa chữa có thể phức tạp hơn. Một ví dụ là sử dụng hồi quy, giúp bạn chọn dữ liệu cần sử dụng trong phân tích và loại bỏ dữ liệu không cần thiết.

Giảm dữ liệu

Bước này liên quan đến việc giảm kích thước bộ dữ liệu, chỉ sử dụng thông tin liên quan nhất. Một số kỹ thuật phổ biến bao gồm:

- Lựa chọn đặc trưng: Loại bỏ các đặc trưng dư thừa khỏi dữ liệu của bạn.

- Trích xuất đặc trưng: Sử dụng khi dữ liệu ban đầu quá phức tạp và có chiều cao. Kỹ thuật này giúp bạn trích xuất những đặc trưng quan trọng mà không làm mất thông tin thiết yếu.

- Nén: Mục tiêu của nén là giảm kích thước bộ dữ liệu mà không mất thông tin.

Chuyển đổi dữ liệu

Sau khi dữ liệu đã được dọn dẹp và giảm xuống mức cần thiết, bạn có thể chuyển sang quá trình chuyển đổi. Một trong những kỹ thuật phổ biến là tổng hợp, kết hợp dữ liệu trong một định dạng thống nhất.

Một lựa chọn khác là chuẩn hóa, giúp bạn điều chỉnh dữ liệu trong một phạm vi nhất định. Phân biệt hóa cho phép bạn chia dữ liệu thành các khoảng, giảm kích thước dữ liệu và giúp máy tính dễ hiểu hơn.

Các kỹ thuật Data Preprocessing phổ biến

Các kỹ thuật Data Preprocessing giúp bạn tinh chỉnh dữ liệu cho các mô hình học máy hoặc phân tích thống kê. Dưới đây là một số kỹ thuật phổ biến:

Điền dữ liệu thiếu (Data Imputation)

Dữ liệu thiếu có thể làm sai lệch phân tích và dẫn đến các mô hình không chính xác. Các chiến lược xử lý giá trị thiếu bao gồm điền dữ liệu (điền vào các giá trị thiếu bằng các số liệu thống kê như trung bình hoặc trung vị) hoặc sử dụng các thuật toán có thể xử lý dữ liệu thiếu, chẳng hạn như rừng ngẫu nhiên (random forests).

Giảm dữ liệu ồn (Reduce Noisy Data)

Dữ liệu ồn có thể che khuất các mẫu quan trọng. Các kỹ thuật như làm mượt (sử dụng trung bình động) và lọc (áp dụng các thuật toán để loại bỏ nhiễu) giúp làm rõ tín hiệu trong dữ liệu. Ví dụ, trung bình động có thể làm mượt các biến động ngắn hạn và làm nổi bật các xu hướng dài hạn.

Phát hiện và loại bỏ dữ liệu trùng lặp (Identify and Remove Duplicates)

Dữ liệu trùng lặp có thể làm sai lệch phân tích, dẫn đến kết quả thiên lệch. Việc phát hiện có thể đơn giản như tìm kiếm các bản ghi giống nhau hoặc phức tạp hơn như nhận diện các bản sao gần giống thông qua phương pháp so khớp mờ. Việc loại bỏ đảm bảo mỗi điểm dữ liệu là duy nhất, duy trì tính toàn vẹn cho bộ dữ liệu của bạn.

Kỹ thuật đặc trưng (Feature Engineering)

Tạo ra các đặc trưng mới từ dữ liệu hiện có có thể giúp phát hiện những thông tin sâu sắc. Quá trình này có thể bao gồm việc kết hợp hai biến để tạo ra một biến mới, chẳng hạn như tính chỉ số BMI từ cân nặng và chiều cao hoặc trích xuất các phần dữ liệu (như ngày trong tuần) cho phân tích chuỗi thời gian.

Chuẩn hóa hoặc tỷ lệ đặc trưng (Feature Scaling or Normalization)

Việc chuẩn hóa các đặc trưng về một phạm vi đồng nhất giúp đảm bảo không có đặc trưng nào chiếm ưu thế trong mô hình chỉ vì sự khác biệt về tỷ lệ. Các phương pháp bao gồm chuẩn hóa min-max, điều chỉnh lại đặc trưng trong một phạm vi cố định, thường là từ 0 đến 1, hoặc chuẩn hóa, làm trung tâm đặc trưng ở số 0 với độ lệch chuẩn đơn vị.

Giảm chiều dữ liệu (Dimensionality Reduction)

Các kỹ thuật giảm chiều dữ liệu, như Phân Tích Thành Phần Chính (PCA), giúp giảm số lượng các biến cần xem xét, đơn giản hóa mô hình mà không mất thông tin quan trọng. Phương pháp này có thể cải thiện hiệu suất mô hình và giảm độ phức tạp tính toán.

Phân biệt hóa dữ liệu (Discretization)

Chuyển đổi các đặc trưng liên tục thành các nhóm phân biệt có thể giúp dữ liệu dễ quản lý hơn và cải thiện hiệu suất mô hình. Ví dụ, tuổi có thể được phân nhóm thành các hạng mục như “18-25”, “26-35”, v.v., để đơn giản hóa phân tích và làm nổi bật các xu hướng theo thế hệ.

Mã hóa đặc trưng (Feature Encoding)

Các phương pháp mã hóa dữ liệu phân loại, chẳng hạn như mã hóa one-hot hoặc mã hóa nhãn, chuyển các biến phân loại thành dạng số cho việc huấn luyện mô hình. Mã hóa là điều cần thiết cho các thuật toán yêu cầu đầu vào số.

Các công cụ xử lý dữ liệu – Data Preprocessing

Các công cụ xử lý dữ liệu giúp đơn giản hóa cách bạn tương tác với dữ liệu lớn, làm cho việc hình thành và làm sạch dữ liệu phức tạp trở nên dễ dàng hơn. Một số công cụ xử lý dữ liệu giúp thực hiện quá trình này bao gồm:

- Pandas: Thư viện Python này cung cấp một loạt các chức năng để xử lý dữ liệu, giúp việc làm sạch, lọc và tổng hợp dữ liệu lớn trở nên lý tưởng.

- Scikit-learn: Scikit-learn được trang bị đầy đủ để xử lý mọi thứ từ chuẩn hóa đặc trưng đến mã hóa các biến phân loại, đảm bảo dữ liệu của bạn ở trạng thái tốt nhất để mô hình hóa.

- OpenRefine: Được thiết kế để xử lý các thách thức từ dữ liệu rối, OpenRefine là công cụ độc lập giúp làm sạch và chuyển đổi dữ liệu. Nó rất hữu ích trong việc chuẩn hóa định dạng dữ liệu và làm giàu bộ dữ liệu bằng thông tin từ các nguồn bên ngoài.

Các công cụ xử lý dữ liệu tự động giúp bạn tập trung vào việc rút ra những thông tin quan trọng thay vì bị mắc kẹt trong việc chuẩn bị dữ liệu.

Data Preprocessing là bước không thể thiếu trong bất kỳ dự án học máy hoặc AI nào, giúp cải thiện chất lượng dữ liệu và nâng cao hiệu suất mô hình. Với các kỹ thuật như làm sạch, giảm chiều dữ liệu, và mã hóa đặc trưng, bạn có thể chuẩn bị dữ liệu một cách hiệu quả để đạt được những kết quả phân tích chính xác.

Các công cụ hỗ trợ xử lý dữ liệu như Pandas, Scikit-learn và OpenRefine càng làm cho quá trình này trở nên dễ dàng và hiệu quả hơn. Hãy áp dụng đúng các kỹ thuật và công cụ Data Preprocessing để tối ưu hóa dự án học máy của bạn.

Tại InterData, chúng tôi cung cấp dịch vụ Hosting giá rẻ tốc độ cao, sử dụng phần cứng thế hệ mới như CPU AMD EPYC/Intel Xeon Platinum và SSD NVMe U.2, giúp bạn triển khai website và ứng dụng mượt mà, tối ưu hiệu suất và băng thông cao. Các gói dịch vụ này được tối ưu hóa để đáp ứng nhu cầu của doanh nghiệp với chi phí hợp lý.

Ngoài ra, bạn có thể tham khảo dịch vụ thuê VPS chất lượng giá rẻ hoặc thuê Cloud Server giá rẻ tốc độ cao tại InterData. Với cấu hình mạnh mẽ, dung lượng tối ưu và ổn định, các giải pháp này hỗ trợ các dự án cần hiệu suất cao, giúp tiết kiệm chi phí và nâng cao trải nghiệm người dùng. Hãy liên hệ với chúng tôi để nhận thêm thông tin chi tiết.

INTERDATA

- Website: Interdata.vn

- Hotline: 1900-636822

- Email: [email protected]

- VPĐD: 240 Nguyễn Đình Chính, P.11. Q. Phú Nhuận, TP. Hồ Chí Minh

- VPGD: Số 211 Đường số 5, KĐT Lakeview City, P. An Phú, TP. Thủ Đức, TP. Hồ Chí Minh