Fine-tuning trong học máy là một kỹ thuật quan trọng giúp điều chỉnh các mô hình học sâu đã được huấn luyện sẵn để áp dụng vào các nhiệm vụ cụ thể. Bài viết này sẽ giải thích chi tiết về khái niệm fine-tuning là gì, những lợi ích và hạn chế của nó, cũng như các ứng dụng thực tế trong nhiều lĩnh vực như dịch vụ khách hàng, y tế và nghiên cứu lịch sử. Đọc ngay!

Fine-tuning là gì?

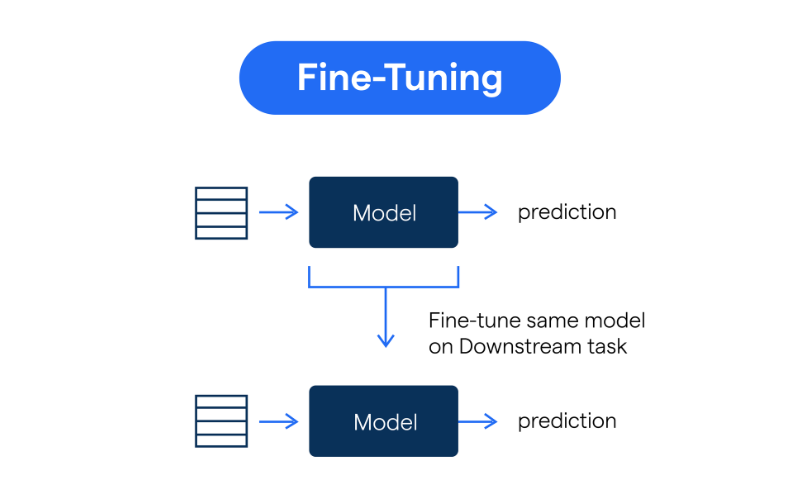

Fine-tuning trong học máy là quá trình điều chỉnh một mô hình đã được huấn luyện sẵn để áp dụng cho các nhiệm vụ hoặc trường hợp sử dụng cụ thể. Đây là một kỹ thuật cơ bản trong học sâu, đặc biệt là trong quá trình huấn luyện các mô hình nền tảng dùng cho trí tuệ nhân tạo (AI) sinh tạo.

Fine-tuning có thể được coi là một nhánh con của kỹ thuật học chuyển giao (transfer learning): việc tận dụng kiến thức mà một mô hình hiện có đã học được như là điểm khởi đầu để học các nhiệm vụ mới.

Cơ sở của fine-tuning là việc điều chỉnh khả năng của một mô hình nền tảng đã được huấn luyện trước đó, mà không cần phải huấn luyện lại hoàn toàn từ đầu cho mục đích cụ thể. Điều này đặc biệt có ý nghĩa đối với các mô hình học sâu với hàng triệu hoặc thậm chí hàng tỷ tham số, như các mô hình ngôn ngữ lớn (LLMs) trong xử lý ngôn ngữ tự nhiên (NLP), hoặc các mạng nơ-ron tích chập (CNNs) và các transformer trong thị giác máy tính cho các nhiệm vụ phân loại hình ảnh, phát hiện đối tượng hay phân đoạn hình ảnh.

Bằng cách tận dụng quá trình huấn luyện mô hình trước đó thông qua học chuyển giao, fine-tuning có thể giảm thiểu đáng kể chi phí tính toán đắt đỏ và lượng dữ liệu có nhãn cần thiết để tạo ra các mô hình lớn phù hợp với các trường hợp sử dụng đặc thù và nhu cầu kinh doanh.

Ví dụ, fine-tuning có thể chỉ đơn giản điều chỉnh tông giọng trò chuyện của một mô hình LLM đã được huấn luyện trước, hoặc phong cách minh họa của một mô hình sinh hình ảnh đã được huấn luyện; nó cũng có thể bổ sung kiến thức từ bộ dữ liệu huấn luyện ban đầu của mô hình với dữ liệu riêng của bạn hoặc kiến thức chuyên ngành.

Do đó, fine-tuning đóng vai trò quan trọng trong việc ứng dụng mô hình học máy trong thực tế, giúp làm cho các mô hình tiên tiến trở nên dễ tiếp cận và dễ dàng tùy chỉnh hơn.

Lợi ích và hạn chế của việc fine-tuning là gì?

Giống như bất kỳ kỹ thuật học máy nào, việc fine-tuning mô hình có những lợi ích và bất lợi nhất định. Vậy những lợi ích của fine-tuning là gì?

Lợi ích chính của fine-tuning

- Hiệu quả chi phí và tài nguyên: Fine-tuning một mô hình đã được huấn luyện sẵn thường nhanh hơn, tiết kiệm chi phí và hiệu quả tính toán hơn nhiều so với việc huấn luyện một mô hình từ đầu. Điều này giúp giảm chi phí và yêu cầu cơ sở hạ tầng ít hơn.

- Hiệu suất tốt hơn trong các trường hợp sử dụng hẹp: Các mô hình đã được fine-tuned, kết hợp giữa kiến thức nền tảng rộng và huấn luyện cụ thể cho nhiệm vụ, có thể đạt được hiệu suất cao trong các trường hợp sử dụng chuyên biệt. Điều này đặc biệt hữu ích trong các tình huống khi dữ liệu cho nhiệm vụ cụ thể hạn chế.

- Dân chủ hóa khả năng học máy: Fine-tuning giúp làm cho các mô hình học máy tiên tiến dễ tiếp cận hơn đối với các cá nhân và tổ chức có hạn chế về tài nguyên tính toán và tài chính. Ngay cả các tổ chức nhỏ không thể xây dựng một mô hình từ đầu cũng có thể điều chỉnh các mô hình đã được huấn luyện sẵn cho một loạt các ứng dụng.

Hạn chế của Fine-tuning

Fine-tuning cũng có một số rủi ro và thách thức, bao gồm:

- Overfitting (quá khớp): Một vấn đề phổ biến khi làm việc với các bộ dữ liệu nhỏ, overfitting xảy ra khi mô hình học máy quá khớp với dữ liệu huấn luyện và học các đặc điểm không liên quan, hoặc “nhiễu”, dẫn đến hiệu suất kém trên dữ liệu mới chưa thấy. Các chiến lược như tăng cường dữ liệu, chuẩn hóa và sử dụng các lớp dropout có thể giúp giảm thiểu hạn chế này.

- Cân bằng giữa kiến thức mới và kiến thức đã học: Có một số rủi ro là mô hình đã được fine-tuned có thể quên kiến thức tổng quát đã học được trong quá trình huấn luyện ban đầu, đặc biệt nếu dữ liệu mới khác biệt đáng kể so với dữ liệu gốc. Việc “đóng băng” quá nhiều lớp có thể ngăn cản mô hình thích ứng tốt với nhiệm vụ mới, trong khi “đóng băng” quá ít lớp có thể làm mất các đặc điểm quan trọng đã được học trước đó.

- Phụ thuộc vào mô hình đã huấn luyện sẵn: Vì fine-tuning phụ thuộc rất nhiều vào mô hình đã được huấn luyện sẵn, bất kỳ khuyết điểm hoặc hạn chế nào trong mô hình gốc cũng có thể ảnh hưởng đến mô hình đã fine-tuned. Ví dụ, nếu mô hình đã huấn luyện sẵn có sự thiên lệch hoặc lỗ hổng bảo mật, những khuyết điểm đó có thể tiếp tục tồn tại hoặc thậm chí trở nên tồi tệ hơn trong mô hình đã fine-tuned nếu không được sửa chữa trước hoặc trong quá trình fine-tuning.

Các trường hợp sử dụng fine-tuning phổ biến

Fine-tuning có thể được sử dụng cho nhiều mục đích, từ việc tùy chỉnh bổ sung kiến thức cơ bản của mô hình cho đến mở rộng mô hình ra các nhiệm vụ và lĩnh vực hoàn toàn mới.

- Tùy chỉnh phong cách: Các mô hình có thể được fine-tuned để phản ánh phong cách mà một thương hiệu mong muốn, từ việc thực hiện các mô hình hành vi phức tạp và phong cách minh họa đặc biệt, đến các thay đổi đơn giản như bắt đầu mỗi cuộc trao đổi bằng một lời chào lịch sự.

- Chuyên môn hóa: Khả năng ngôn ngữ chung của các mô hình LLM có thể được tinh chỉnh cho các nhiệm vụ cụ thể. Ví dụ, các mô hình Llama 2 của Meta đã được phát hành như là các mô hình nền tảng cơ bản, các biến thể tinh chỉnh chatbot (Llama-2-chat) và các biến thể tinh chỉnh mã nguồn (Code Llama).

- Thêm kiến thức chuyên ngành: Mặc dù các mô hình LLM đã được huấn luyện trên một tập hợp dữ liệu khổng lồ, chúng không phải là toàn diện. Việc sử dụng các mẫu huấn luyện bổ sung để bổ sung kiến thức cho mô hình nền tảng đặc biệt quan trọng trong các lĩnh vực như pháp lý, tài chính hoặc y tế, nơi thường xuyên sử dụng các từ vựng chuyên ngành mà có thể chưa được đại diện đầy đủ trong huấn luyện ban đầu.

- Học với ít ví dụ: Các mô hình đã có kiến thức tổng quát mạnh mẽ có thể thường xuyên được fine-tuned cho các văn bản phân loại cụ thể với một lượng ví dụ tương đối ít.

- Giải quyết các trường hợp đặc biệt: Bạn có thể muốn mô hình của mình xử lý một số tình huống mà khó có thể được đề cập trong quá trình huấn luyện ban đầu theo cách cụ thể. Fine-tuning mô hình trên các ví dụ có nhãn của các tình huống như vậy là một cách hiệu quả để đảm bảo chúng được xử lý đúng cách.

- Kết hợp dữ liệu riêng của công ty: Công ty của bạn có thể có một quy trình dữ liệu riêng, có liên quan mật thiết đến trường hợp sử dụng cụ thể của bạn. Fine-tuning cho phép bạn tích hợp kiến thức này vào mô hình mà không phải huấn luyện lại từ đầu.

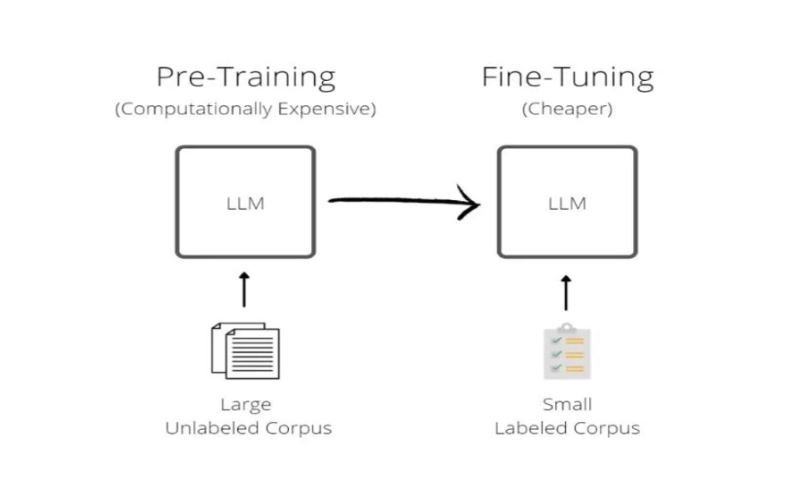

So sánh Fine-tuning vs. training

Mặc dù tinh chỉnh là một kỹ thuật được sử dụng trong quá trình đào tạo mô hình, nhưng nó là một quá trình khác biệt so với những gì thường được gọi là “đào tạo.” Để tránh sự nhầm lẫn, các nhà khoa học dữ liệu thường gọi quá trình sau là “đào tạo ban đầu” trong bối cảnh này.

(Pre-)Training

Khi bắt đầu quá trình (Pre-)Training, mô hình chưa “học” được gì. (Pre-)Training bắt đầu với việc khởi tạo ngẫu nhiên các tham số của mô hình – các trọng số và độ chệch khác nhau được áp dụng cho các phép toán toán học xảy ra tại mỗi nút trong mạng thần kinh.

(Pre-)Training diễn ra theo cách lặp đi lặp lại trong hai giai đoạn: trong lần đi qua đầu tiên, mô hình đưa ra dự đoán cho một nhóm đầu vào mẫu từ bộ dữ liệu huấn luyện, và một hàm mất mát đo lường sự khác biệt (hay mất mát) giữa dự đoán của mô hình đối với mỗi đầu vào và các câu trả lời “đúng” (hay sự thật cơ sở); trong quá trình lan truyền ngược (backpropagation), một thuật toán tối ưu hóa – thường là phương pháp giảm dần gradient (gradient descent) – được sử dụng để điều chỉnh trọng số của mô hình trên toàn bộ mạng để giảm thiểu mất mát.

Những điều chỉnh này đối với trọng số của mô hình là cách mà mô hình “học.” Quá trình này được lặp lại qua nhiều vòng đào tạo cho đến khi mô hình được coi là đã được đào tạo đầy đủ.

Học có giám sát thông thường, thường được sử dụng để đào tạo mô hình cho các tác vụ thị giác máy tính như phân loại hình ảnh, phát hiện vật thể hay phân đoạn hình ảnh, sử dụng dữ liệu có nhãn: nhãn (hoặc chú thích) cung cấp cả phạm vi các câu trả lời có thể có và kết quả đúng cho mỗi mẫu.

Mô hình ngôn ngữ lớn (LLMs) thường được đào tạo ban đầu qua học tự giám sát (SSL), trong đó các mô hình học thông qua các tác vụ giả định được thiết kế để rút ra sự thật cơ sở từ cấu trúc tự nhiên của dữ liệu không có nhãn. Các tác vụ giả định này truyền đạt kiến thức hữu ích cho các tác vụ sau này. Chúng thường có một trong hai phương pháp sau:

- Tự dự đoán: che giấu một phần của đầu vào gốc và yêu cầu mô hình tái tạo lại nó. Đây là phương thức đào tạo chủ yếu cho các mô hình ngôn ngữ lớn.

- Học tương phản: đào tạo mô hình học các biểu diễn tương tự cho các đầu vào liên quan và các biểu diễn khác biệt cho các đầu vào không liên quan. Phương pháp này được sử dụng nổi bật trong các mô hình thị giác máy tính thiết kế cho việc học với ít ví dụ hoặc học không ví dụ (few-shot hoặc zero-shot), như trong huấn luyện ngôn ngữ-ảnh đối chiếu (Contrasting Language-Image Pretraining – CLIP).

Do đó, học tự giám sát cho phép sử dụng các bộ dữ liệu lớn khổng lồ trong đào tạo mà không cần phải chú thích hàng triệu hoặc hàng tỷ điểm dữ liệu. Điều này tiết kiệm rất nhiều công sức lao động, nhưng vẫn đòi hỏi tài nguyên tính toán khổng lồ.

Fine-tuning

Ngược lại, Fine-tuning là kỹ thuật đào tạo thêm cho một mô hình mà trọng số của nó đã được cập nhật thông qua đào tạo trước đó. Sử dụng kiến thức của mô hình cơ bản làm điểm khởi đầu, tinh chỉnh điều chỉnh mô hình bằng cách đào tạo nó trên một bộ dữ liệu nhỏ, chuyên biệt cho một tác vụ cụ thể.

Mặc dù bộ dữ liệu chuyên biệt này có thể lý thuyết đã được sử dụng trong đào tạo ban đầu, việc đào tạo một mô hình lớn từ đầu trên một bộ dữ liệu nhỏ có thể dẫn đến hiện tượng “quá khớp” (overfitting): mô hình có thể học tốt trên các ví dụ đào tạo, nhưng lại tổng quát kém đối với dữ liệu mới. Điều này sẽ khiến mô hình không phù hợp với tác vụ được giao và làm mất đi mục đích của việc đào tạo mô hình.

Fine-tuning do đó mang lại lợi ích của cả hai thế giới: tận dụng kiến thức rộng và sự ổn định đạt được từ đào tạo ban đầu trên một bộ dữ liệu lớn và mài giũa sự hiểu biết của mô hình về các khái niệm chi tiết, cụ thể hơn.

Với sự phát triển mạnh mẽ của các mô hình nền mã nguồn mở, lợi ích này có thể thường xuyên đạt được mà không phải chịu gánh nặng tài chính, tính toán hay hậu cần của việc đào tạo ban đầu.

Ứng dụng thực tế của Fine-tuning

Fine-tuning có nhiều trường hợp sử dụng trong các tình huống thực tế. Dưới đây là một số ví dụ:

- Dịch vụ khách hàng: Một công ty có thể tinh chỉnh một mô hình LLM (mô hình ngôn ngữ lớn) tổng quát trên một bộ dữ liệu các cuộc tương tác hỗ trợ khách hàng trước đó, đặc biệt là dữ liệu liên quan đến ngành hoặc tổ chức của công ty. Chatbot đã được tinh chỉnh này có thể trả lời hiệu quả hơn các câu hỏi của người dùng về ngành và sản phẩm của công ty.

- Bán lẻ và thương mại điện tử: Một nền tảng thương mại điện tử muốn cải thiện công cụ gợi ý sản phẩm có thể tinh chỉnh một mô hình đã được đào tạo trước trên dữ liệu tương tác người dùng của công ty, chẳng hạn như lịch sử mua hàng và đánh giá của người dùng. Mô hình đã được tinh chỉnh này có thể đưa ra các gợi ý sản phẩm chính xác và cá nhân hóa hơn cho người dùng.

- Y tế và y học: Các nhà nghiên cứu y tế đang nghiên cứu một căn bệnh hiếm có thể tinh chỉnh một mô hình xử lý hình ảnh đã được đào tạo trước trên một bộ dữ liệu nhỏ các ảnh CT của bệnh. Mô hình đã được tinh chỉnh có thể nhận diện các dấu hiệu của căn bệnh này với độ chính xác cao hơn.

- Nghiên cứu lịch sử: Một nhà sử học làm việc với việc số hóa các văn bản cổ có thể gặp khó khăn trong việc thực hiện nhận dạng ký tự quang học tự động trên một ngôn ngữ cổ xưa. Việc đào tạo trước một mô hình xử lý ngôn ngữ tự nhiên (NLP) trên một tập hợp các văn bản cổ này có thể giúp mô hình nhận diện tốt hơn các đặc điểm ngôn ngữ đặc trưng của chúng.

- Bảo tồn và bền vững: Một nhóm sinh thái học theo dõi động vật hoang dã trong rừng có thể cần phân biệt âm thanh động vật với tiếng ồn nền trong các bản ghi âm. Họ có thể tinh chỉnh một mô hình xử lý âm thanh đã được đào tạo trước trên một bộ dữ liệu các bản ghi âm từ rừng, giúp mô hình đã được tinh chỉnh này nhận diện và phân biệt âm thanh của các loài động vật cụ thể.

Tóm lại, fine-tuning là một kỹ thuật mạnh mẽ giúp cải thiện hiệu suất của các mô hình học máy trong các tình huống thực tế, giảm thiểu chi phí tính toán và dễ dàng tùy chỉnh cho các nhiệm vụ cụ thể.

Mặc dù có một số hạn chế như vấn đề quá khớp (overfitting), fine-tuning vẫn là lựa chọn tối ưu trong nhiều ứng dụng, từ dịch vụ khách hàng đến y tế và bảo tồn thiên nhiên. Việc hiểu rõ về fine-tuning là gì sẽ giúp các chuyên gia và tổ chức tối ưu hóa các mô hình AI và tận dụng tối đa các nguồn lực hiện có.

- Website: Interdata.vn

- Hotline: 1900-636822

- Email: [email protected]

- VPĐD: 240 Nguyễn Đình Chính, P.11. Q. Phú Nhuận, TP. Hồ Chí Minh

- VPGD: Số 211 Đường số 5, KĐT Lakeview City, P. An Phú, TP. Thủ Đức, TP. Hồ Chí Minh